Pacorrr escribió:Daylon87 escribió: Yo me juego 2 a que nace muerto con esos requisitos jaja

Pues el juego se ve bastante guapo. El que no pueda poner las texturas al máximo por falta de VRAM, pues las bajará a high y listo.

xecollons escribió:Pacorrr escribió:Daylon87 escribió: Yo me juego 2 a que nace muerto con esos requisitos jaja

Pues el juego se ve bastante guapo. El que no pueda poner las texturas al máximo por falta de VRAM, pues las bajará a high y listo.

Pero es un poco triste que no puedas poner las texturas en Ultra en una gráfica prácticamente tope de gama que acaba de salir.

xecollons escribió:Pacorrr escribió:Daylon87 escribió: Yo me juego 2 a que nace muerto con esos requisitos jaja

Pues el juego se ve bastante guapo. El que no pueda poner las texturas al máximo por falta de VRAM, pues las bajará a high y listo.

Pero es un poco triste que no puedas poner las texturas en Ultra en una gráfica prácticamente tope de gama que acaba de salir.

PepeC12 escribió:@adriano_99 El tema para mi es que las consolas tienen 16gB que pueden utilizar asi que no veo porque no van a gastar 12 o 13 gb de ram en texturas

roberto28live escribió:Con un 5600X y una RX 6800 tengo más que suficiente. Toca ahorrar.

Pacorrr escribió:Pues el juego se ve bastante guapo. El que no pueda poner las texturas al máximo por falta de VRAM, pues las bajará a high y listo.

sin estrenar a un compañero de trabajo, no es que juegue y con una 5700 voy sobrado un par de años, porque la 6800, dudo que baje de los 600€...

sin estrenar a un compañero de trabajo, no es que juegue y con una 5700 voy sobrado un par de años, porque la 6800, dudo que baje de los 600€... AzagraMac escribió:Pacorrr escribió:Pues el juego se ve bastante guapo. El que no pueda poner las texturas al máximo por falta de VRAM, pues las bajará a high y listo.

Te dejas una pasta en una GPU que ha salido hace pocas semanas, para no poder poner el juego en ULTRA.... casi que me quedo con la basura que tengo de 1660 Super para eso y me ahorro el coste de la GPU.

Es mas, me estoy planteando pillar una RX 5700 XT por 300€, modelo referencia.sin estrenar a un compañero de trabajo, no es que juegue y con una 5700 voy sobrado un par de años, porque la 6800, dudo que baje de los 600€...

Pacorrr escribió:AzagraMac escribió:Pacorrr escribió:Pues el juego se ve bastante guapo. El que no pueda poner las texturas al máximo por falta de VRAM, pues las bajará a high y listo.

Te dejas una pasta en una GPU que ha salido hace pocas semanas, para no poder poner el juego en ULTRA.... casi que me quedo con la basura que tengo de 1660 Super para eso y me ahorro el coste de la GPU.

Es mas, me estoy planteando pillar una RX 5700 XT por 300€, modelo referencia.sin estrenar a un compañero de trabajo, no es que juegue y con una 5700 voy sobrado un par de años, porque la 6800, dudo que baje de los 600€...

Repito, pasó exactamente lo mismo con la 2080 y el Battlefield V, no se podía poner al máximo con RT ni siquiera a 1440p por falta de VRAM... Nvidia siempre ha racaneado mucho con la cantidad de VRAM. Con las RX 6800/6900 no habrá problema, llevan 16GB.

Blackpo92 escribió:Habrá que ver cómo rinden las Radeon en el Cyberpunk no? sin DLSS y con RT.

Entre jugar regular el Godfall y jugar regular el Cyberpunk yo creo que todos lo tenemos claro.

Y voy más allá, que un juego cómo Cyberpunk chupara 12 gb de vram lo podría llegar incluso a entender, pero Godfall? de verdad?

Por otro lado, poner el Battlefield V cómo ejemplo me parece una broma, está bastante mal optimizado, y el DLSS funciona fatal en ese juego.

Estoy casi seguro que la 6800 va a rendir más que la 3070, sólo faltaría costando 80-100 pavos más.

Saludos

Pacorrr escribió:Blackpo92 escribió:Habrá que ver cómo rinden las Radeon en el Cyberpunk no? sin DLSS y con RT.

Entre jugar regular el Godfall y jugar regular el Cyberpunk yo creo que todos lo tenemos claro.

Y voy más allá, que un juego cómo Cyberpunk chupara 12 gb de vram lo podría llegar incluso a entender, pero Godfall? de verdad?

Por otro lado, poner el Battlefield V cómo ejemplo me parece una broma, está bastante mal optimizado, y el DLSS funciona fatal en ese juego.

Estoy casi seguro que la 6800 va a rendir más que la 3070, sólo faltaría costando 80-100 pavos más.

Saludos

El Cyberpunk 2077 no tendrá soporte RT para otras tarjetas que no sean Nvidia al menos los primeros meses, suena a exclusiva temporal (es un juego patrocinado por Nvidia). Y en general, los efectos RT chupan más VRAM que si no los usas, si se juntan con texturas ultra mega HD pues cóctel explosivo.

Blackpo92 escribió:Pacorrr escribió:Blackpo92 escribió:Habrá que ver cómo rinden las Radeon en el Cyberpunk no? sin DLSS y con RT.

Entre jugar regular el Godfall y jugar regular el Cyberpunk yo creo que todos lo tenemos claro.

Y voy más allá, que un juego cómo Cyberpunk chupara 12 gb de vram lo podría llegar incluso a entender, pero Godfall? de verdad?

Por otro lado, poner el Battlefield V cómo ejemplo me parece una broma, está bastante mal optimizado, y el DLSS funciona fatal en ese juego.

Estoy casi seguro que la 6800 va a rendir más que la 3070, sólo faltaría costando 80-100 pavos más.

Saludos

El Cyberpunk 2077 no tendrá soporte RT para otras tarjetas que no sean Nvidia al menos los primeros meses, suena a exclusiva temporal (es un juego patrocinado por Nvidia). Y en general, los efectos RT chupan más VRAM que si no los usas, si se juntan con texturas ultra mega HD pues cóctel explosivo.

Y digo yo, crees que no se va a poder jugar al Cyberpunk a la perfección con la 3070 y la 3080 a 2k y 4k respectivamente a tope siendo un juego cómo comentas patrocinado por Nvidia? Sería pegarse un tiro en el pie.

La verdad es que no sabía de la exclusividad del RT en Cyberpunk (vaya putada si tienes o vas a comprar una 6000)

Blackpo92 escribió:Y digo yo, crees que no se va a poder jugar al Cyberpunk a la perfección con la 3070 y la 3080 a 2k y 4k respectivamente a tope siendo un juego cómo comentas patrocinado por Nvidia? Sería pegarse un tiro en el pie.

La verdad es que no sabía de la exclusividad del RT en Cyberpunk (vaya putada si tienes o vas a comprar una 6000)

Er_Garry escribió:Blackpo92 escribió:Y digo yo, crees que no se va a poder jugar al Cyberpunk a la perfección con la 3070 y la 3080 a 2k y 4k respectivamente a tope siendo un juego cómo comentas patrocinado por Nvidia? Sería pegarse un tiro en el pie.

La verdad es que no sabía de la exclusividad del RT en Cyberpunk (vaya putada si tienes o vas a comprar una 6000)

El WD Legión también es un juego patrocinado por Nvidia (lo regalan con las 3000), y no puedes jugar en 4K@60 con RT ni con una 3090, así que ...

La cosa es que anuncien de una vez los precios finales en €, y así ver si compensa ir a por una 6800/3070 o 6800XT/3080

Salu2

Pacorrr escribió:Blackpo92 escribió:Habrá que ver cómo rinden las Radeon en el Cyberpunk no? sin DLSS y con RT.

Entre jugar regular el Godfall y jugar regular el Cyberpunk yo creo que todos lo tenemos claro.

Y voy más allá, que un juego cómo Cyberpunk chupara 12 gb de vram lo podría llegar incluso a entender, pero Godfall? de verdad?

Por otro lado, poner el Battlefield V cómo ejemplo me parece una broma, está bastante mal optimizado, y el DLSS funciona fatal en ese juego.

Estoy casi seguro que la 6800 va a rendir más que la 3070, sólo faltaría costando 80-100 pavos más.

Saludos

El Cyberpunk 2077 no tendrá soporte RT para otras tarjetas que no sean Nvidia al menos los primeros meses, suena a exclusiva temporal (es un juego patrocinado por Nvidia). Y en general, los efectos RT chupan más VRAM que si no los usas, si se juntan con texturas ultra mega HD pues cóctel explosivo.

JagerCrow escribió:Pacorrr escribió:Blackpo92 escribió:Habrá que ver cómo rinden las Radeon en el Cyberpunk no? sin DLSS y con RT.

Entre jugar regular el Godfall y jugar regular el Cyberpunk yo creo que todos lo tenemos claro.

Y voy más allá, que un juego cómo Cyberpunk chupara 12 gb de vram lo podría llegar incluso a entender, pero Godfall? de verdad?

Por otro lado, poner el Battlefield V cómo ejemplo me parece una broma, está bastante mal optimizado, y el DLSS funciona fatal en ese juego.

Estoy casi seguro que la 6800 va a rendir más que la 3070, sólo faltaría costando 80-100 pavos más.

Saludos

El Cyberpunk 2077 no tendrá soporte RT para otras tarjetas que no sean Nvidia al menos los primeros meses, suena a exclusiva temporal (es un juego patrocinado por Nvidia). Y en general, los efectos RT chupan más VRAM que si no los usas, si se juntan con texturas ultra mega HD pues cóctel explosivo.

paremos la moto un momento, primero que todo para tener Raytracing necesitamos un APi que lo soporte y para el caso Windows 10 versión 1903 (actualización de mayo de 2019, número de compilación 18362 que es la que habilita en DirectX 12 el Raytracing, otra API como es VULKAN también lo soporta hasta donde se pero de momento no hay implementaciones, la cosa es que hasta donde me entero NVIDIA con su RTX hace es una aceleración por hardware dedicado para DXR, de la misma forma que permite también hacerlo en graficas sin hardware dedicado con rendimiento inferior, incluso si nos vamos a la especificación de DXR de Microsoft por alla en 2018 que hizo el anuncio

https://devblogs.microsoft.com/directx/ ... aytracing/

en la cual vemos que uso de DXR no esta amarrado a ningún hardware y que habilitar el uso depende que este se implemente por los drivers de la grafica, a ver si nos ponemos serios con el asunto, yo entiendo que en las especificaciones/requerimientos de todos los juegos próximos a salir no halla ninguna mención al Raytracing con graficas AMD por sencillamente estas graficas no habían sido anunciadas que es una explicación mas plausible a decir que no se dara soporte a graficas que no sean NVIDIA cuando es la propia API DiretX 12 a travez de su complemento DXR la que permite tener Raytracing

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Pacorrr escribió: Es cosa de cd projekt (seguramente tenga un suculento acuerdo con Nvidia), hasta 2021 no sacará un parche para habilitar DXR en tarjetas que no sean Nvidia

Lo dijo uno de los desarrolladores en una entrevista en pc gamer.

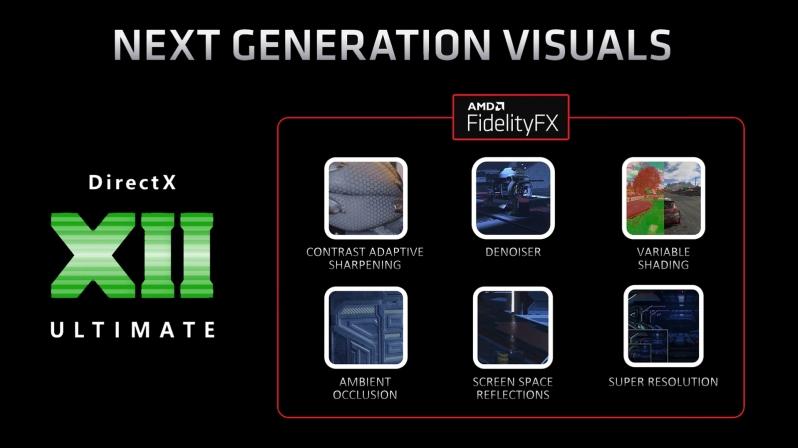

PCGH: ha optado por utilizar Direct X 12 Ultimate. ¿Habrá una alternativa para que los jugadores que todavía están ejecutando Win 7 / 8.x también puedan jugar? ¿Hubo una decisión entre las API de nivel inferior DirectX 12 y Vulkan y, de ser así, por qué eligió DX12?

Marcin Gollent: Gracias a la introducción del soporte DX12 para Windows 7 SP1 que Microsoft presentó el año pasado, el juego se ejecutará en este sistema. Hacemos, y continuaremos, probando Cyberpunk 2077 en Windows 7 en un intento de resolver los casos extremos que puedan surgir. Desafortunadamente, Windows 8 no recibió su variante de bibliotecas DX12.

Con respecto a DX12 Ultimate, Cyberpunk 2077 funcionará absolutamente bien con todas las GPU compatibles con DX12. Lo que hace el conjunto de características "Ultimate" es que nos permite hacer más si el hardware lo permite. Optamos por DX12 por dos razones principales. En primer lugar, es la API estándar para las plataformas Xbox y, dado que el juego también llegará a Xbox One, naturalmente queríamos implementarlo lo antes posible. En segundo lugar, es el lugar de nacimiento de DXR, y dado que teníamos planes de invertir en DXR desde el principio, eso hizo que la elección de ir con DX12 fuera bastante sencilla.

Tenga en cuenta que todos estos juegos que utilizan las funciones de DX12 Ultimate funcionarán bien en todo el hardware compatible con DirectX 12 Ultimate. Y cada mes, más juegos actuales y futuros se unen a esta lista en constante crecimiento.

JagerCrow escribió:Pacorrr escribió: Es cosa de cd projekt (seguramente tenga un suculento acuerdo con Nvidia), hasta 2021 no sacará un parche para habilitar DXR en tarjetas que no sean Nvidia

Lo dijo uno de los desarrolladores en una entrevista en pc gamer.

primero que Todo aca la entrevista y dejo link para el que quiera revisar por si mismo

https://www.pcgameshardware.de/Cyberpun ... J5EI1rfJyw

y aca los extractos de lo que dijo Jakub Knapik (director de arte de iluminación y efectos) y Marcin Gollent (programador principal de gráficos) de CD Projekt Red. traducción Cortesia de Google TraslatorPCGH: ha optado por utilizar Direct X 12 Ultimate. ¿Habrá una alternativa para que los jugadores que todavía están ejecutando Win 7 / 8.x también puedan jugar? ¿Hubo una decisión entre las API de nivel inferior DirectX 12 y Vulkan y, de ser así, por qué eligió DX12?

Marcin Gollent: Gracias a la introducción del soporte DX12 para Windows 7 SP1 que Microsoft presentó el año pasado, el juego se ejecutará en este sistema. Hacemos, y continuaremos, probando Cyberpunk 2077 en Windows 7 en un intento de resolver los casos extremos que puedan surgir. Desafortunadamente, Windows 8 no recibió su variante de bibliotecas DX12.

Con respecto a DX12 Ultimate, Cyberpunk 2077 funcionará absolutamente bien con todas las GPU compatibles con DX12. Lo que hace el conjunto de características "Ultimate" es que nos permite hacer más si el hardware lo permite. Optamos por DX12 por dos razones principales. En primer lugar, es la API estándar para las plataformas Xbox y, dado que el juego también llegará a Xbox One, naturalmente queríamos implementarlo lo antes posible. En segundo lugar, es el lugar de nacimiento de DXR, y dado que teníamos planes de invertir en DXR desde el principio, eso hizo que la elección de ir con DX12 fuera bastante sencilla.

y dime de la entrevista en que parte hablo de forma clara y explícita diciendo que le soporte solo será para tarjetas NVIDIA??, donde pone que hasta 2021???, donde dice lo de la exclusiva temporal???, lo único que se menciona es el uso de DirectX 12 ultimate y la cual de la propia pagina de Microsoft menciona esto y dejo link

https://devblogs.microsoft.com/directx/ ... iday-2020/

- DirectX Raytracing

- Variable Rate Shading

- Sampler Feedback

- Mesh Shaders

y pongo el apunte que esta al final de la publicación y donde efectivamente se pone como ejemplo Cyberpunk 2077 por lo mostrado por NVIDIATenga en cuenta que todos estos juegos que utilizan las funciones de DX12 Ultimate funcionarán bien en todo el hardware compatible con DirectX 12 Ultimate. Y cada mes, más juegos actuales y futuros se unen a esta lista en constante crecimiento.

en ninguna parte habla de que AMD o Consolas no vayan a funcionar con directX Ultimate que en ultimas es la extensión que habilita el DXR para que las graficas lo puedan usar

Ray tracing will only be available on PCs with GeForce graphics cards or via GeForce NOW at launch, though we expect that it'll be eventually compatible with AMD's new Navi graphics cards as well as being featured on PlayStation 5 and Xbox Series X once the proper enhancement updates drop for the next-gen consoles in 2021.

JagerCrow escribió:@Pacorrr primero ese apunte es una interpretación de wccftech a la información dada por NVIDIA y CD PROJEKT RED al expresar que Cyberpunk 2077 estaría disponible desde el día 1 con todas sus características en PC con una grafica NVIDIA y Geforce NOW

de la publicación que hablas de de PC Gamer UK en la preview de las paginas 4-5 se lee

"to better make us of brand new graphics hardware built for DX12"

"para hacernos mejor con hardware de gráficos completamente nuevo construido para DX12"

dejo link

https://www.magazinesdirect.com/az-sing ... 323b2406bc

sin ninguna mención de exclusividad por ningún lado, siempre se habla de que el juego será exclusivo de Windows 10 y directX 12 y que para el soporte completo se necesita directx 12 Ultimate, no mas... ya miramos el 10 a ver que pasa y con que es compatible y con que no

sergiokarra escribió:Yo estoy esperando a ver si sacan unas 6700 xt o 6600xt porque no tengo intención de gastarme tanto, esperamos que bajen de precio

metalgear escribió:...

Y de paso, amd tambien ha presentado su compentencia contra el dlss de nvidia, en colaboración con microsoft.

DirectML Super Resolution

Muestran una imagen de como la ia es capaz de reescalar una imagen de 1080p a 4k. (brutal) de ser cierto puede dejar en pañales al actual dlss pero queda por ver, ya que aún no hay fecha de lanzamiento. (Se entiende que no será dentro de mucho tiempo, porque tanto la nueva generación de consolas como estas tarjetas están ya al salir al mercado)

De ser cierto y lo bueno es que esto no es exclusivo de AMD, quiere decir que se podrá usar sobre tarjetas de nvidia. Que logicamente lo que imagino que ocurrirá es que igual que muchas tecnologías de nvidia pasarán al cajón del olvido.

![reojillo [reojillo]](/images/smilies/nuevos2/ooooops.gif)

sergiokarra escribió:Yo estoy esperando a ver si sacan unas 6700 xt o 6600xt porque no tengo intención de gastarme tanto, esperamos que bajen de precio

eykhon escribió:sergiokarra escribió:Yo estoy esperando a ver si sacan unas 6700 xt o 6600xt porque no tengo intención de gastarme tanto, esperamos que bajen de precio

Estoy igual, o la 3060...es q se pasan, ya estoy hasta meditando si veo a 300 o menos una 5700 xt comprarla y darle un par de años y lueho cambiar a otra de 300 del momento, q no ir ahora a una de 600 pa esos 4-5 años (q no se si duraría)