Beatwin escribió:gothnux escribió:Cuando una gama o serie pasa a legacy (así hizo Nvidia con Kepler en cuanto salio Maxwell) dejan de darle soporte en los nuevos y próximos juegos. Por lo tanto, hasta esos últimos drivers esa arquitectura ha sido explotada, a raíz de ahí "que el cielo nos coja confesados".

La gama GTX 700 no ha pasado a legacy y te lo demuestro con información oficial dada por NVIDIA. Últimos drivers (365.10) publicados el 2 de Mayo de 2016:Prior to a new title launching, our driver team is working up until the last minute to ensure every performance tweak and bug fix possible makes it into the Game Ready driver. As a result, you can be sure you’ll have the best day-1 gaming experience for your favorite new titles.

GeForce 900 Series:

GeForce GTX TITAN X, GeForce GTX 980 Ti, GeForce GTX 980, GeForce GTX 970, GeForce GTX 960, GeForce GTX 950

GeForce 700 Series:

GeForce GTX TITAN Z, GeForce GTX TITAN Black, GeForce GTX TITAN, GeForce GTX 780 Ti, GeForce GTX 780, GeForce GTX 770, GeForce GTX 760, GeForce GTX 760 Ti (OEM), GeForce GTX 750 Ti, GeForce GTX 750, GeForce GTX 745, GeForce GT 740, GeForce GT 730, GeForce GT 720, GeForce GT 710, GeForce GT 705

GeForce 600 Series:

GeForce GTX 690, GeForce GTX 680, GeForce GTX 670, GeForce GTX 660 Ti, GeForce GTX 660, GeForce GTX 650 Ti BOOST, GeForce GTX 650 Ti, GeForce GTX 650, GeForce GTX 645, GeForce GT 645, GeForce GT 640, GeForce GT 635, GeForce GT 630, GeForce GT 620, GeForce GT 610, GeForce 605

GeForce 500 Series:

GeForce GTX 590, GeForce GTX 580, GeForce GTX 570, GeForce GTX 560 Ti, GeForce GTX 560 SE, GeForce GTX 560, GeForce GTX 555, GeForce GTX 550 Ti, GeForce GT 545, GeForce GT 530, GeForce GT 520, GeForce 510

GeForce 400 Series:

GeForce GTX 480, GeForce GTX 470, GeForce GTX 465, GeForce GTX 460 SE v2, GeForce GTX 460 SE, GeForce GTX 460, GeForce GTS 450, GeForce GT 440, GeForce GT 430, GeForce GT 420

http://www.nvidia.com/download/driverRe ... 2069/en-us

Por otra parte está el driver 341.95 publicado el 16 de Marzo de 2016 donde se limitan a realizar actualizaciones de seguridad o de mantenimiento, con los siguientes productos donde NO está la serie GTX 700:Este controlador añade actualizaciones de seguridad para GPUs con arquitectura Tesla.

GeForce 400 Series:

GeForce 405

GeForce 300 Series:

GeForce GT 340, GeForce GT 330, GeForce GT 320, GeForce 315, GeForce 310

GeForce 200 Series:

GeForce GTX 295, GeForce GTX 285, GeForce GTX 280, GeForce GTX 275, GeForce GTX 260, GeForce GTS 250, GeForce GTS 240, GeForce GT 230, GeForce GT 240, GeForce GT 220, GeForce G210, GeForce 210, GeForce 205

GeForce 100 Series:

GeForce GT 140, GeForce GT 130, GeForce GT 120, GeForce G100

GeForce 9 Series:

GeForce 9800 GX2, GeForce 9800 GTX/GTX+, GeForce 9800 GT, GeForce 9600 GT, GeForce 9600 GSO, GeForce 9600 GSO 512, GeForce 9600 GS, GeForce 9500 GT, GeForce 9500 GS, GeForce 9400 GT, GeForce 9400, GeForce 9300 GS, GeForce 9300 GE, GeForce 9300 SE, GeForce 9300, GeForce 9200, GeForce 9100

GeForce 8 Series:

GeForce 8800 Ultra, GeForce 8800 GTX, GeForce 8800 GTS 512, GeForce 8800 GTS, GeForce 8800 GT, GeForce 8800 GS, GeForce 8600 GTS, GeForce 8600 GT, GeForce 8600 GS, GeForce 8500 GT, GeForce 8400 GS, GeForce 8400 SE, GeForce 8400, GeForce 8300 GS, GeForce 8300, GeForce 8200, GeForce 8200 /nForce 730a, GeForce 8100 /nForce 720a

ION (Desktops):

ION

ION LE (Desktops):

ION LE

http://www.nvidia.es/download/driverRes ... /100337/es

Y ya por último están los drivers legacy para tarjetas antiguas, desde la Geforce 2, hasta la serie 7, con soporte para Windows 98:

http://www.nvidia.com/object/wdm_drivers.html

Como ves, y así lo demuestra la documentación oficial de NVIDIA: ( http://us.download.nvidia.com/Windows/3 ... pdated.pdf ) las tarjetas GTX 700 disfrutan de las últimas actualizaciones y optimizaciones para los juegos más recientes lanzados al mercado.

Por lo cual ese despecho que sientes hacia NVIDIA no está justificado en el sentido de basarte en una afirmación falsa ("la anterior generación vea mermada su rendimiento con la no implementación de las mejoras necesarias en los lanzamientos de los juegos nuevos en los drivers").

Es falso por la información dada por NVIDIA, y es falso además por la información dada en multitud de páginas web como Noticias3D donde foreros que han hecho pruebas y testeos certifican que las tarjetas GTX 700 mejoran su rendimiento con los nuevos drivers, y además de forma muy notable:

gothnux escribió:¿Me podrías explicar justo en donde pone Nvidia que todo ese listado de gráficas tengan las mejoras correspondientes a los juegos?

Por que según tu Link, justo el mismo donde has querido copiar y pegar todo en uno, lo pone bien clarito:

Quedando claro que son dos imágenes diferentes en las que en la primera te especifica que hay mejoras para los juegos y en la segunda las gráficas que están soportadas por dicho driver. En ningún sitio dice que dichas gráficas lleven esas mejoras, cosa obvia porque solo se incluyen para Maxwell. Y cosa que tu has manipulado para simular que era real al agrupar dicha información en un mismo mensaje.

Por un momento, me has hecho hasta dudar de lo que yo he vivido, pero viendo comentarios de @KailKatarn donde os conoce y pertenecéis todos a la misma "tribu" ya me explico el porque de todo esto.

En fin, como me temía discutir esto con gente así es prácticamente imposible. Pero desde luego, deberíais de dejar de desinformar y manipular las cosas para que se lo crea la gente.

![Lee! [rtfm]](/images/smilies/rtfm.gif)

Beatwin escribió:gothnux escribió:¿Me podrías explicar justo en donde pone Nvidia que todo ese listado de gráficas tengan las mejoras correspondientes a los juegos?

Por que según tu Link, justo el mismo donde has querido copiar y pegar todo en uno, lo pone bien clarito:

Quedando claro que son dos imágenes diferentes en las que en la primera te especifica que hay mejoras para los juegos y en la segunda las gráficas que están soportadas por dicho driver. En ningún sitio dice que dichas gráficas lleven esas mejoras, cosa obvia porque solo se incluyen para Maxwell. Y cosa que tu has manipulado para simular que era real al agrupar dicha información en un mismo mensaje.

Por un momento, me has hecho hasta dudar de lo que yo he vivido, pero viendo comentarios de @KailKatarn donde os conoce y pertenecéis todos a la misma "tribu" ya me explico el porque de todo esto.

En fin, como me temía discutir esto con gente así es prácticamente imposible. Pero desde luego, deberíais de dejar de desinformar y manipular las cosas para que se lo crea la gente.

En Derecho existe un viejo aforismo de derecho que expresa que «lo normal se entiende que está probado, lo anormal se prueba». Por tanto, quien invoca algo que rompe el estado de normalidad, debe probarlo («affirmanti incumbit probatio»: ‘a quien afirma, incumbe la prueba’). Básicamente, lo que se quiere decir con este aforismo es que la carga o el trabajo de probar un enunciado debe recaer en aquel que rompe el estado de normalidad (el que afirma poseer una nueva verdad sobre un tema).

Cuando tú, aunque reconozcas (porque no te queda más remedio ante la documentación oficial de NVIDIA) que lo últimos drivers dan soporte a la serie GTX 700, afirmas que no dan mejoras a los juegos, lo haces sin aportar ninguna prueba sobre ello, y con desprecio temerario a la verdad. Lo haces llevado por tu despecho a la marca NVIDIA por tu sensación de haber sido "estafado", igual que mucha gente también hecha pestes en los foros de AMD por haberse sentido "estafados" con AMD.

A pesar de que la carga de la prueba no recaía sobre mí, te he hecho un ZASCA con la siguiente gráfica que demuestra la mejora de rendimiento de la GTX 780 con los últimos drivers 35X.XX del momento:

http://foro.noticias3d.com/vbulletin/sh ... p?t=446555

Las pruebas hablan por sí solas![Lee! [rtfm]](/images/smilies/rtfm.gif)

No nos merecemos que ciertos usuarios nos mientan, llevados por el despecho personal hacia determinadas marcas, diciéndonos que los últimos drivers dejan de llevar mejoras y optimizaciones para las tarjetas GTX 700, porque eso es simple y llanamente MENTIRA.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

adriano_99 escribió:Puedes hacer un pequeño resumen para los sucios mortales que no sabemos lo que son los SM? xD

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif) . Cuando nos venden gráficas siempre nos comentan el número de unidades de shader que llevan, TMUs, ROPs y demás tecnicismos, supongo que te sonarán, sobre todo los primeros.

. Cuando nos venden gráficas siempre nos comentan el número de unidades de shader que llevan, TMUs, ROPs y demás tecnicismos, supongo que te sonarán, sobre todo los primeros.gothnux escribió:......

En fin, como me temía discutir esto con gente así es prácticamente imposible. Pero desde luego, deberíais de dejar de desinformar y manipular las cosas para que se lo crea la gente.

wwwendigo escribió:adriano_99 escribió:Puedes hacer un pequeño resumen para los sucios mortales que no sabemos lo que son los SM? xD

Bueno, lo intentaré, aunque @Rivroner no tenga mucha fe en ello. Cuando nos venden gráficas siempre nos comentan el número de unidades de shader que llevan, TMUs, ROPs y demás tecnicismos, supongo que te sonarán, sobre todo los primeros.

Las unidades de shader son las unidades de ejecución donde se van a ejecutar las operaciones sobre los píxeles o vertex que sean necesarios para renderizar un triángulo, con las texturas necesarias y toda la tostá.

El problema está en que cuando nos venden este número, las unidades de shader, en realidad nos hacen pensar que la gpu tiene una cantidad ingente de pequeños microprocesadores "tontos" funcionando en paralelo, pero independientes, cuando esto no es así. Estos trabajan en grupos.

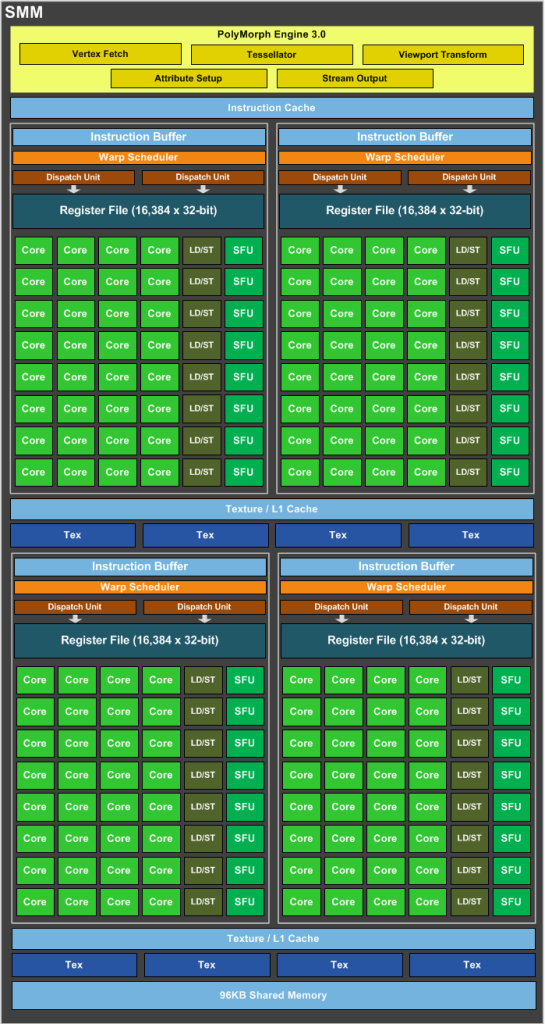

En el caso de nvidia, estos grupos de unidades de shader se reúnen en un conjunto llamado SM, SMX, SMM, dependiendo del chip concreto que mires, pero que tienen en común lo mismo: Es la unidad de ejecución mínima donde se ejecuta un shader dado (de hecho varios a la vez, pero dejémoslo como si sólo fuera uno). Esto es, un SM es como una cpu con un proceso, por comparar con algo más familiar, donde hay un flujo de instrucciones y éstas se van enviando a las unidades de ejecución, en este caso shaders, que ejecutan el mismo shader sobre pixeles consecutivos (dado que en render 3D es fácil que muchos de estos píxeles realmente necesiten ejecutar dicho shader, si no es así, el resultado es rechazado antes de enviarse a la VRAM y por tanto nunca aparecerá un pixel "pintado" con un shader que no le correponda, aunque en realidad sí haya sido calculado).

Un SM es un análogo a una cpu, porque tiene sus propios planificadores de shaders, sus propias cachés y registros, y va usando las distintas unidades que tiene (shaders, TMUs, LD/ST). Es la base sobre la que se ejecuta en realidad lo que ves en la pantalla.

Es imposible acceder a una unidad shader de forma única y discreta, sí puedes acceder a una batería de éstos a través del SM.

Luego, con varios SMs juntos nvidia crea un GPC, que es por así decirlo una "cuasigpu" completa, ya que hace básicamente todas las operaciones de rasterización necesarios, sólo quedando las operaciones de ROPs y los controladores de memoria fuera de la ecuación.

unidad de shader->SM->GPC->GPU. Siendo los SMs la unidad mínima que "corre" un código shader, realmente.

adriano_99 escribió:Entonces si no te he entendido mal a lo que te referías antes es que pascal ordena esas unidades de procesamiento de un modo parecido o que le envía las lineas de ordenes de u modo parecido a como lo hace en maxwell ?

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![Ok! [oki]](/images/smilies/net_thumbsup.gif)

wwwendigo escribió:adriano_99 escribió:Entonces si no te he entendido mal a lo que te referías antes es que pascal ordena esas unidades de procesamiento de un modo parecido o que le envía las lineas de ordenes de u modo parecido a como lo hace en maxwell ?

Bueno, me refería a que los nuevos SMs de Pascal, que parecen "distintos" a los SM de Maxwell, en realidad no lo son tanto si te fijas en un par de SMs de Pascal juntos (que además van así, en una nueva estructura que se llama TPC).

Que cuando los observas así y comparas ese TPC (con 2 SM) de Pascal con un SM de Maxwell, se ven parecidos razonables (un SM de Maxwell se parece a esos 2 SM "pegados"). Y que la nueva estructura llamada TPC bien puede ser la parte donde iba el Polymorph engine que había antes por cada SM, como en maxwell y chips anteriores.

Creo que he acabado liando más la explicación...![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Esto es un SM de Maxwell:

Y esto uno de Pascal:

Ahora coge e imagina dos de estos uno encima del otro, y compara con lo que ves en el SM de Maxwell, ¿a que ya se parecen así?, pues en lo que ahora nvidia llama un TPC, hay dos SMs así mismamente colocados, y comparten algún hard que no tiene que ver con los shaders ni tmus y demás. Si te fijas en el esquema del SM de Maxwell verás que hay algo llamado Polymorph engine arriba, que es el que hace todo el trabajo relacionado con procesar la geometría que entra en el SM para renderizar un triángulo, o para generar triángulos nuevos con teselación.

Pues bien, yo lo que dije es que es posible que lo que se comparta a nivel de TPC sea sólo ese tipo de hard dedicado a procesar geometría, ya sea un polymorph engine igual, más potente o como si son dos. Lo que sea, pero es lo único que veo que tiene sentido compartir a ese nivel, el TPC.

Bueno, que si es como digo, por los parecidos que observo, es que con Pascal han acabado de separar los dos grandes bloques de shaders que ya empezaron a separar con Maxwell si comparamos con Kepler, al ya no compartir estructuras como la memoria compartida, caché de instrucciones, etc. Así que en ese sentido, más que una revolución del diseño haciendo SMs mucho más compactos, en realidad no sería más que una evolución de lo visto en Maxwell, por llamarlo de alguna forma, una especie de Maxwell 4.0.

Si te apetece ver y comparar un SM de kepler, aquí tienes uno bajo el spoiler:

[spoiler]

Si te fijas verás que además de tener muchas más unidades, no parece estar compartimentado como sí está el de maxwell, y ya con Pascal se separarían de facto los dos grandes compartimentos en el SM de un maxwell.

Sí, son parecidos pero hay mejoras varias sobre todo en tamaño de registros, cachés, memoria compartida, etc, lo que hará que los SMs de Maxwell sean más eficientes sobre todo con computación, pero también algo con juegos.

Pero creo que conviene pensar que 2 SMs de Pascal se podrían comparar con 1 SMM de Maxwell, y sumarle un % de mejora, digamos un 10%, como mucho un 20% más rápido comparando shader a shader en 3D, pero eso me parece bastante optimista ya.

Fuera de la mejora que tendrán por frecuencia, que parece que será lo más importante para aumentar el rendimiento con Pascal, por lo poco visto con la gráfica Tesla que presentaron hace ya casi un mes. Para mí la frecuencia de funcionamiento será tan clave como la nueva arquitectura.

Eso es lo que intentaba decir antes, y no sé si ahora estará más claro.[/spoiler]

adriano_99 escribió:Entonces a ver si no lo he entendido mal cada gráfica tiene unas pequeñas unidades que son las SM que se encargan del calculo mas pequeño, con maxwell cambiaron la manera en que funcionan para optimizarlas mas y en pascal han evolucionado ese cambio parece, no?

Gracias por tomarte el tiempo en responderme.

wwwendigo escribió:adriano_99 escribió:Entonces a ver si no lo he entendido mal cada gráfica tiene unas pequeñas unidades que son las SM que se encargan del calculo mas pequeño, con maxwell cambiaron la manera en que funcionan para optimizarlas mas y en pascal han evolucionado ese cambio parece, no?

Gracias por tomarte el tiempo en responderme.

Sí, básicamente es así, la unidad de trabajo real son los SMs, las unidades de shaders van juntas en varias baterías y es el SM el que les envía el trabajo a ejecutar (código shader) a esas baterías de unidades shader (que van en grupos de 32 en 32).

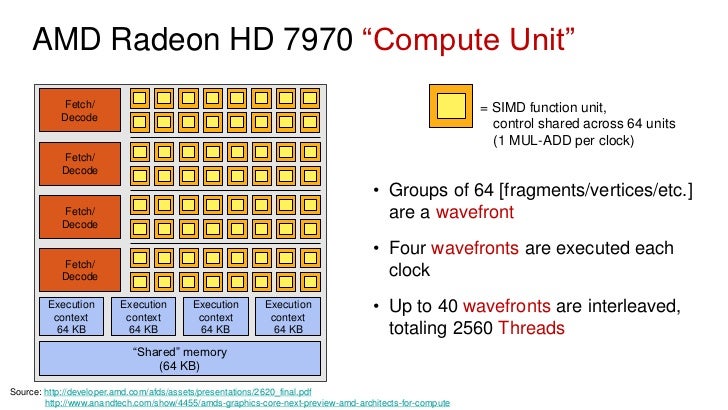

En AMD hay algo parecido, son los CUs (compute units) que son grupos de 64 unidades de shaders que trabajan juntos, comparten cachés, memoria compartida, etc:

No son exactamente iguales, porque carecen de la lógica del planificador y la gestión de los "shaders" que sí tiene el SM, pero es lo más parecido en AMD (la gestión de qué shader se ejecuta y cómo en cada CU de AMD la hace un planificador general para varias unidades CUs, ojo, no para todas las CUs de la gpu, hay varios de estos planificadores).

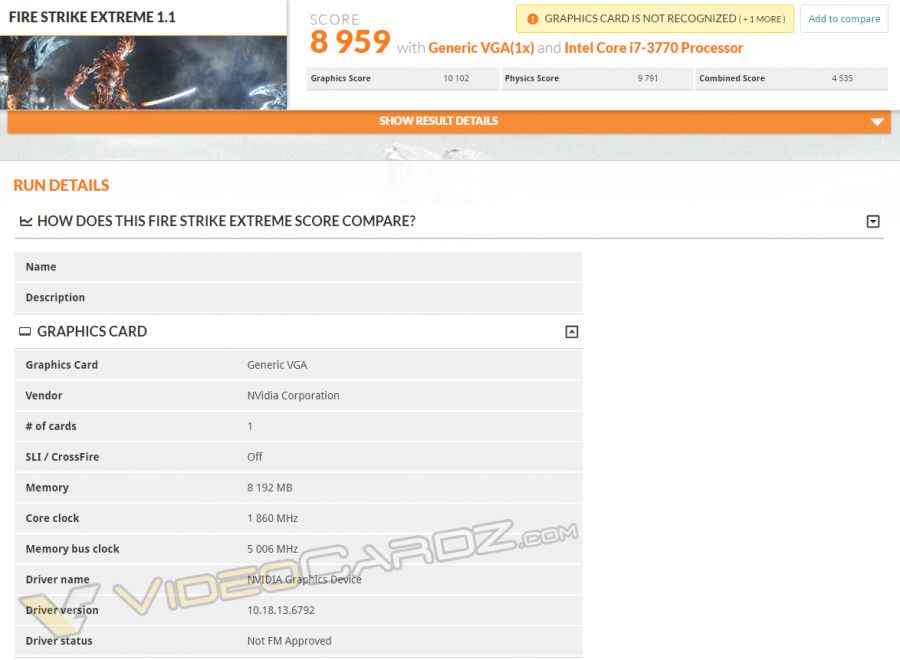

Boris I escribió:Supuesto primer benchmark de la 1080... http://videocardz.com/59558/nvidia-geforce-gtx-1080-3dmark-benchmarks

Aproximadamente un 20% mejor que la 980ti http://www.guru3d.com/articles_pages/nvidia_geforce_gtx_980_ti_review,24.html. Pero claro, sin drivers para Pascal, imagino que sera un poco mas. Dicen que a igualdad de frecuencias la 980ti rinde mas que la 1080, pero claro parece ser que solo cuenta con 2560 por 2816 cores de la 980ti. Se rumorea tambien un aumento de IPC del 10% con la nueva arquitectura y que las frecuencias van a ser unos 500 mhz mas altas que lo visto en Maxwell. Ahi ya se ven 1860mhz, asi que es muy posible que acaben rondando los 2ghz con OC. La diferencia con la 1070 imagino que sera bastante mayor que la que hay entre 970 y 980, pero puede que la 1070 este un poco por encima de la 980ti.

Boris I escribió:Supuesto primer benchmark de la 1080... http://videocardz.com/59558/nvidia-geforce-gtx-1080-3dmark-benchmarks

Aproximadamente un 20% mejor que la 980ti http://www.guru3d.com/articles_pages/nvidia_geforce_gtx_980_ti_review,24.html. Pero claro, sin drivers para Pascal, imagino que sera un poco mas. Dicen que a igualdad de frecuencias la 980ti rinde mas que la 1080, pero claro parece ser que solo cuenta con 2560 por 2816 cores de la 980ti. Se rumorea tambien un aumento de IPC del 10% con la nueva arquitectura y que las frecuencias van a ser unos 500 mhz mas altas que lo visto en Maxwell. Ahi ya se ven 1860mhz, asi que es muy posible que acaben rondando los 2ghz con OC. La diferencia con la 1070 imagino que sera bastante mayor que la que hay entre 970 y 980, pero puede que la 1070 este un poco por encima de la 980ti.

supernafamacho escribió:Muy prometedor ese benchmark,pero estareis de acuerdo conmigo en que el aumento de rendimiento sera proporcional al aumento de precio.

yameli escribió:399 la 1070 y 499 la 1080 digo yo jeje

Krain escribió:yameli escribió:399 la 1070 y 499 la 1080 digo yo jeje

Yo descartaría por completo una diferencia de precio tan pequeña entre dos modelos que no son los mainstream en principio. Si la 1070 vale 399 la 1080 se irá a 599 (que viendo la potencia que se rumorea sería un chollo a ese precio) A 499 soy capaz de pensar en un sli.

Yo apostaría por 4XX-6XX

![tristón [triston]](/images/smilies/nuevos/triste_ani2.gif)

adriano_99 escribió:supernafamacho escribió:Muy prometedor ese benchmark,pero estareis de acuerdo conmigo en que el aumento de rendimiento sera proporcional al aumento de precio.

No, no lo estamos.

yameli escribió:a que hora es la presentación mañana? y desde donde se puede ver?

.

. lwordl escribió:futuro mad max escribió:la clave sera el precio

gtx 1070 por 500€

![calabaza [hallow]](/images/smilies/nuevos/hallowen.gif)

![calabaza [hallow]](/images/smilies/nuevos/hallowen.gif)

![calabaza [hallow]](/images/smilies/nuevos/hallowen.gif)

Boris I escribió:Supuesto primer benchmark de la 1080... http://videocardz.com/59558/nvidia-geforce-gtx-1080-3dmark-benchmarks

Aproximadamente un 20% mejor que la 980ti http://www.guru3d.com/articles_pages/nvidia_geforce_gtx_980_ti_review,24.html. Pero claro, sin drivers para Pascal, imagino que sera un poco mas. Dicen que a igualdad de frecuencias la 980ti rinde mas que la 1080, pero claro parece ser que solo cuenta con 2560 por 2816 cores de la 980ti. Se rumorea tambien un aumento de IPC del 10% con la nueva arquitectura y que las frecuencias van a ser unos 500 mhz mas altas que lo visto en Maxwell. Ahi ya se ven 1860mhz, asi que es muy posible que acaben rondando los 2ghz con OC. La diferencia con la 1070 imagino que sera bastante mayor que la que hay entre 970 y 980, pero puede que la 1070 este un poco por encima de la 980ti.

KingCube escribió:Para los que tengamos la Gigabyte G1 Gaming GTX 970 OC y similares, podemos saltarnos esta generación o tengo que ir preparando el bolsillo.

![demoniaco [sati]](/images/smilies/nuevos2/demonio.gif)

juanmahl9 escribió:Pfffff 400€ no me gasto en una GPU ni loco, mi tope son 250-300, a ver la 1060 que tal o la 1060ti

DaNi_0389 escribió:Pues no esta mal el resultado de esa supuesta 1080, mas o menos lo que se venia rumoreando, un 25% por encima de la 980Ti esta bastante bien para el gp104.

Ademas tiene pinta que van a ocear la mar de bien, 1800Mhz a stock no esta mal, los 1600Mhz de mi 980ti ya me empiezan a saber a poco, vaya empujon ha metido el nuevo nodo.

wwwendigo escribió:DaNi_0389 escribió:Pues no esta mal el resultado de esa supuesta 1080, mas o menos lo que se venia rumoreando, un 25% por encima de la 980Ti esta bastante bien para el gp104.

Ademas tiene pinta que van a ocear la mar de bien, 1800Mhz a stock no esta mal, los 1600Mhz de mi 980ti ya me empiezan a saber a poco, vaya empujon ha metido el nuevo nodo.

1800 suena muy bien, pero no quiere decir nada. Seguramente será incluso un poco más. Pero un dato, ¿qué pasa si no suben apenas nada, digamos que 100 MHz? U otra posibilidad, suben, pero digamos que 200 o 250 MHz como mucho. ¿Te sigue pareciendo tanto, o es la barrera psicológica de los 2 GHz la que te está ofuscando?

Imagina, frecuencia base 1800 MHz. + 200 MHz-> 2000 MHz, muy bonito todo. ¿Ganancia máxima de rendimiento por la gpu? -> un 11%.

NO es lo mismo subir 100 MHz a un chip de 1 GHz que a uno a 2 GHz, y que salga el GP104 a tanta frecuencia, además de la espectacularidad de las cifras y logro técnico, no quiere decir que vaya a ser un buen chip para OC o que con OC lo que suba sea más que chips anteriores.

Para hablar de eso, habrá que esperar a verlo en acción. No nos ofusquemos con su terror tecnológico (MHz for everyone).

KAISER-77 escribió:Yo me piro a dormir que al final no aguanto, mañana me levantare con las noticias

supernafamacho escribió:KAISER-77 escribió:Yo me piro a dormir que al final no aguanto, mañana me levantare con las noticias

5 Horas sres,no me llega la camisa al cuello.

adriano_99 escribió:supernafamacho escribió:KAISER-77 escribió:Yo me piro a dormir que al final no aguanto, mañana me levantare con las noticias

5 Horas sres,no me llega la camisa al cuello.

De 5 nada quedan 14.

adriano_99 escribió:supernafamacho escribió:KAISER-77 escribió:Yo me piro a dormir que al final no aguanto, mañana me levantare con las noticias

5 Horas sres,no me llega la camisa al cuello.

De 5 nada quedan 14.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif) Se le ha pasado al hombre que eran las 18h hora del pacífico.

Se le ha pasado al hombre que eran las 18h hora del pacífico. wwwendigo escribió:DaNi_0389 escribió:Pues no esta mal el resultado de esa supuesta 1080, mas o menos lo que se venia rumoreando, un 25% por encima de la 980Ti esta bastante bien para el gp104.

Ademas tiene pinta que van a ocear la mar de bien, 1800Mhz a stock no esta mal, los 1600Mhz de mi 980ti ya me empiezan a saber a poco, vaya empujon ha metido el nuevo nodo.

1800 suena muy bien, pero no quiere decir nada. Seguramente será incluso un poco más. Pero un dato, ¿qué pasa si no suben apenas nada, digamos que 100 MHz? U otra posibilidad, suben, pero digamos que 200 o 250 MHz como mucho. ¿Te sigue pareciendo tanto, o es la barrera psicológica de los 2 GHz la que te está ofuscando?

Imagina, frecuencia base 1800 MHz. + 200 MHz-> 2000 MHz, muy bonito todo. ¿Ganancia máxima de rendimiento por la gpu? -> un 11%.

NO es lo mismo subir 100 MHz a un chip de 1 GHz que a uno a 2 GHz, y que salga el GP104 a tanta frecuencia, además de la espectacularidad de las cifras y logro técnico, no quiere decir que vaya a ser un buen chip para OC o que con OC lo que suba sea más que chips anteriores.

Para hablar de eso, habrá que esperar a verlo en acción. No nos ofusquemos con su terror tecnológico (MHz for everyone).

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

).

). Krain escribió:

Se le ha pasado al hombre que eran las 18h hora del pacífico.