Xi0N escribió:Si, yo o sacan gráficas con 32 Gb de VRAM o no compro.,

Ah! Y a menos de 600 euros eh?

A AMD le va a pasar ahora con la VRAM como cuando empezó a sacar procesadores con mil threads, pero cada thread no daba pa ná comparado con intel.

Aquí igual: GDDR, 16 Gb de memoria más lenta que la de nVidia.

Pero 16 es más que 10 asi que todo dios a comprar 16

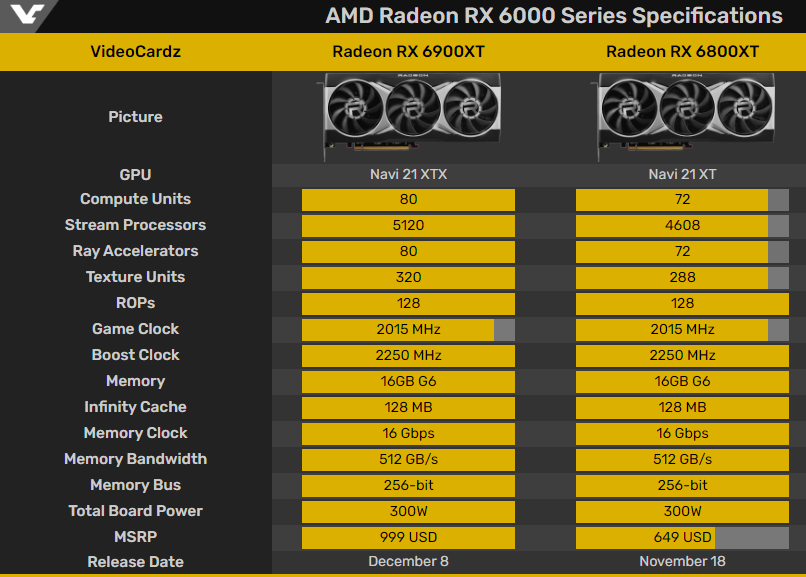

Mirad, lo demuestra esta gráfica:

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Ok! [oki]](/images/smilies/net_thumbsup.gif)

PepeC12 escribió:@Blackpo92 Eso es lo que mucha gente esta viendo y esperando (yo incluido), que seguramente Nvidia saque graficas con más vram.

La 3070 con 12GB de ram seria una opción ideal, al igual que la 3080 con 16GB.

Y visto lo visto tampoco deberian subir mucho de precio porque los 650$ de la 6800xt la dejarian en mala posición.

alfye20 escribió:@Blackpo92 hay otros que se han gastado hace 2 meses 1300€ por 11gb, nunca llueve a gusto de todos,de momento a disfrutar la 3080

@jrdj si llegas a 2050 constantes es porque tienes una Strix de 470w y nunca le hace throtling por Power.

Luego, el TombRider que ni te llega al Power Limit,seguro que el boost y la temperatura están engañandote, luego pones otro juego/sim más exigente con triple pantalla o similar y verás que no mantiene los 2ghz por mucho tiempo cuando la GPU está al 100% de uso

Metalyard escribió:@metalero24 Lo que @Xi0N no está contando es que AMD ha utilizado la tecnología infinity caché vista también en Ryzen, pasan de 16 mb a 128mb, una auténtica burrada.

Todos sabemos que la gpu tira primero de ésta memoria que es la más rápida para luego tirar de la gddr.

Eso es un punto fuerte y una solución excelente que hace que puedan montar memorias más baratas que la gddrx,solventar el poco stock de éstas y aumentar la cantidad de gb en sus gráficas.

Algo que para los modders de juegos nos viene de pm.

En éste sentido AMD le está haciendo a Nvidia lo que le ha hecho a Intel.

![facepalm [facepalm]](/images/smilies/facepalm.gif) .. como la vram no importa... afirmar que una tarjeta grafica con 10 GB tiene de sobra para mover los juegos de nueva generación a 4k y con Ray tracing... es no tener ni idea de como funciona esta industria

.. como la vram no importa... afirmar que una tarjeta grafica con 10 GB tiene de sobra para mover los juegos de nueva generación a 4k y con Ray tracing... es no tener ni idea de como funciona esta industria ![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif) , con cada nueva generación suben las especificaciones de Vram es lo que tiene subir la calidad visual y complejidad de los mundos.. y durante lo que dura la generación siguen subiendo los requisitos de Vram por que por si alguien no se ha enterado los videojuegos van mejorando a nivel técnico con los años y lo que en 2017 era suficiente con 11 GB para 4K en 2021/2022 ya no lo será.

, con cada nueva generación suben las especificaciones de Vram es lo que tiene subir la calidad visual y complejidad de los mundos.. y durante lo que dura la generación siguen subiendo los requisitos de Vram por que por si alguien no se ha enterado los videojuegos van mejorando a nivel técnico con los años y lo que en 2017 era suficiente con 11 GB para 4K en 2021/2022 ya no lo será. Bio81 escribió:No si algunos aun querrán tarjetas graficas con 512 megas.. como la vram no importa... afirmar que una tarjeta grafica con 10 GB tiene de sobra para mover los juegos de nueva generación a 4k y con Ray tracing... es no tener ni idea de como funciona esta industria

, con cada nueva generación suben las especificaciones de Vram es lo que tiene subir la calidad visual y complejidad de los mundos.. y durante lo que dura la generación siguen subiendo los requisitos de Vram por que por si alguien no se ha enterado los videojuegos van mejorando a nivel técnico con los años y lo que en 2017 era suficiente con 11 GB para 4K en 2021/2022 ya no lo será.

PepeC12 escribió:@Daylon87 sabes que tienen raytracing verdad?

Blackpo92 escribió:A mi lo que me da miedo es que Nvidia saque ahora unas 3070 y 3080 con más vram y se nos quede un poco cara de tontos. Si es una estrategia apostando por una memoria más rápida y sus tecnologías me parece perfecto, pero ya digo que si sacan ahora deprisa y corriendo versiones con más VRAM a mi por lo menos se me queda una buena cara de imbécil. Yo me he comprado la 3070 viniendo de una 2060 y el salto ha sido increíble, pero si en 6 meses voy a tener que estar bajando calidad por la VRAM me parece una tomadura de pelo.

Saludos

pakolo1977 escribió:Por lo poco que sé sobre esto, AMD se han permitido meter esos 128 Megabytes de memoria caché en sus gpus porque usan la litografía de 7 nanómetros de TSMC, que supongo será algo mejor que la de Samsung y podrá tener una densidad de transistores mayor por milímetro cuadrado y por su propio diseño de los chips. Al no tener que meter ni rt cores porque el raytracing lo están haciendo con las mismas unidades de ejecución que ya tenían antes, adaptadas para hacer esos nuevos cálculos y el tema de los tensor cores ni está ni se le espera tampoco, también supongo que el resultado a nivel de diseño es más homogéneo en su caso, algo más fácil de implementar y además deja en el chip una cantidad de espacio suficiente como para meter toda esa memoria ultrarrápida.

Nvidia ya dio su solución al problema, ahora AMD da la suya propia. Cada una de ellas tendrá sus ventajas e inconvenientes. Sinceramente, sigo creyendo que la mejor es la de Nvidia (pero más cara al necesitar cada vez memorias con mayores anchos de banda, más nuevas con stocks más bajos) ya que hacen lo que se ve cada vez más en la informática, los procesadores modernos tienen hoy en día muchas zonas diferentes especializadas en los cálculos para según que tareas. Aún así, puede que su enfoque con circuitos altamente especializados a la larga se vea inferior a ese otro enfoque algo menos heterogéneo.

parh escribió:Blackpo92 escribió:A mi lo que me da miedo es que Nvidia saque ahora unas 3070 y 3080 con más vram y se nos quede un poco cara de tontos. Si es una estrategia apostando por una memoria más rápida y sus tecnologías me parece perfecto, pero ya digo que si sacan ahora deprisa y corriendo versiones con más VRAM a mi por lo menos se me queda una buena cara de imbécil. Yo me he comprado la 3070 viniendo de una 2060 y el salto ha sido increíble, pero si en 6 meses voy a tener que estar bajando calidad por la VRAM me parece una tomadura de pelo.

Saludos

la pregunta no es si Nvidia lanzara nuevos modelos, la pregunta es cuando. Yo era de la idea que ya quedarian para el año que viene, pero ojo que con noticias que ya hay juegos que por falta de ram dejan obsoletas estas graficas, y lo bien que han salido las de AMD y,encima, mas baratas, podria obligar a Nvidia a mover ficha incluso para la campaña navideña..

Daylon87 escribió:@paconan que es eso del step up de evga?

paconan escribió:Daylon87 escribió:no se si las compras de segunda mano vandrán para eso...

aleyalicia21 escribió:Señores como veis la curva que me ha echo el msi afterburner del oc en la ventus 3080?

He mirado varios videos de undervolt y no me puto aclaro.. alguien puede iluminarme? He intentado cojer y poner una linea recta a 862 mv en 1990mhz.. y cuando e iniciado el witcher 3.. pum crash del pc jajajajja lo he echo fatal verdad?

1 Actualizo, con esa curva, a los 5 min de jugar al witcher me ha crasheado y sacado del juego a windows..

alfye20 escribió:aleyalicia21 escribió:Señores como veis la curva que me ha echo el msi afterburner del oc en la ventus 3080?

He mirado varios videos de undervolt y no me puto aclaro.. alguien puede iluminarme? He intentado cojer y poner una linea recta a 862 mv en 1990mhz.. y cuando e iniciado el witcher 3.. pum crash del pc jajajajja lo he echo fatal verdad?

1 Actualizo, con esa curva, a los 5 min de jugar al witcher me ha crasheado y sacado del juego a windows..

No has capado los voltios...

Pon el OC en default, baja CoreClock a -290mhz aprox y aplicas,la gráfica te va a dar un bajón pero es necesario para que ahora pinches la bola de 0.900v y puedas subirla por encima del resto de bolas, aplicas y verás que a partir del 0.900v se hace plana, ya está.

Guarda el profile y aplicas al iniciar sesión de windows

Daylon87 escribió:Tanto la 6800 como la 6800xt son más caras que contra las que compiten, sin ver benchmark reales no se de donde os sacáis que amd es mejor calidad precio la verdad

PepeC12 escribió:@Daylon87 vamos a ver.

6800xt vale 650$ lo que son 50$ menos que la 3080

La 6900xt cuesta 999$ que compite con la 3090 de 1500$.

La 6800 esta por encima de la 3070 (está entre la 3070 y la 3080) cuesta 570$ y viene con 16gb.

Tu me dirás...

Blackpo92 escribió:PepeC12 escribió:@Daylon87 vamos a ver.

6800xt vale 650$ lo que son 50$ menos que la 3080

La 6900xt cuesta 999$ que compite con la 3090 de 1500$.

La 6800 esta por encima de la 3070 (está entre la 3070 y la 3080) cuesta 570$ y viene con 16gb.

Tu me dirás...

Hay que hacer la conversión compi, aquí siempre salen más caras que cuando las presentan con su precio en dólares a lo que hay que añadirle impuestos.

De ahí que si la 6800 sale por 579 dólares, aquí saldría cómo poco por 600 euros + impuestos, se puede ir a 630 euros sin ningún problema.

Saludos

Blackpo92 escribió:PepeC12 escribió:@Daylon87 vamos a ver.

6800xt vale 650$ lo que son 50$ menos que la 3080

La 6900xt cuesta 999$ que compite con la 3090 de 1500$.

La 6800 esta por encima de la 3070 (está entre la 3070 y la 3080) cuesta 570$ y viene con 16gb.

Tu me dirás...

Hay que hacer la conversión compi, aquí siempre salen más caras que cuando las presentan con su precio en dólares a lo que hay que añadirle impuestos.

De ahí que si la 6800 sale por 579 dólares, aquí saldría cómo poco por 600 euros + impuestos, se puede ir a 630 euros sin ningún problema.

Saludos

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Beta Reverse escribió:jrdj escribió:Xi0N escribió:Como decían ppor ahí arriba "Si te dejas 900 euros en un componente de hardware y luego vas a andar mirando lo que consume en voltaje, mal vamos"

Supongo que esos 20 euros al año serán muy significativos.

Eso si, si es verdad que undervolt hace que vaya a más FPS, será algo que probaré aunque no me entra en la cabeza, habiendo precisamente BIOS para hacer Overvolt.

No va a dar mas rendimiento con undervolt, ni te molestes... En el único caso que le veo sentido es en que tu caja refrigere de pena. y se te ponga la grafica a mas de 80 grados, que quizá ahí puedas ganar algo haciendo que se caliente menos y suba algo la frecuencia por estar mas fresca, si no, no tiene sentido...El ruido que hacen al menos mi TUF hasta el 85% prácticamente ni se oye. Temas de factura de luz etc que siempre se oye lo mismo, igual son 15 euros AL AÑO vamos que me da la risa jaja

Si no oyes la TUF hasta el 85%, déjame decirte que tienes un grave problema de audición, o un ordenador que suena como un compresor neumático.

Pero bueno, que al final cada uno hace lo que le sale de los huevos con sus gráficas, y listo. En las Ampere la ganancia en juegos con overclock es completamente irrisoria, así como la pérdida de rendimiento con undervolt. A partir de ahí, que cada uno decida.

aleyalicia21 escribió:alfye20 escribió:aleyalicia21 escribió:Señores como veis la curva que me ha echo el msi afterburner del oc en la ventus 3080?

He mirado varios videos de undervolt y no me puto aclaro.. alguien puede iluminarme? He intentado cojer y poner una linea recta a 862 mv en 1990mhz.. y cuando e iniciado el witcher 3.. pum crash del pc jajajajja lo he echo fatal verdad?

1 Actualizo, con esa curva, a los 5 min de jugar al witcher me ha crasheado y sacado del juego a windows..

No has capado los voltios...

Pon el OC en default, baja CoreClock a -290mhz aprox y aplicas,la gráfica te va a dar un bajón pero es necesario para que ahora pinches la bola de 0.900v y puedas subirla por encima del resto de bolas, aplicas y verás que a partir del 0.900v se hace plana, ya está.

Guarda el profile y aplicas al iniciar sesión de windows

Le he echo lo que me has dicho, y a 0,875v lo he puesto a 1905mhz y mirad:

El consumo está oscilando todo el rato entre 260w y 300w, la mayor parte está entre 260w y 280w, raro es que pase un poco de 300w a 320w

Lo veis bien así o creeis que le podría bajar un poco más a los mismos mhz?

PepeC12 escribió:@Blackpo92 No he hecho conversion ninguna, he dado los precios en $.

El cambio $ - € nos favorece y efectivametne esos 570$ al cambio son 588€, y los 650$ son 670€ al cambio con iva incluido. El precio en las tiendas ya lo veremos.

PepeC12 escribió:@Blackpo92 estoy dando el precio con iva incluido tio, lee bien.

para simplificar, la 6800 son 50$ o € más que la 3070 y la 6800xt son 50€$/€ menos que la 3080.

PepeC12 escribió:@Blackpo92 estoy dando el precio con iva incluido tio, lee bien.

para simplificar, la 6800 son 50$ o € más que la 3070 y la 6800xt son 50€$/€ menos que la 3080.

VanSouls escribió:PepeC12 escribió:@Blackpo92 estoy dando el precio con iva incluido tio, lee bien.

para simplificar, la 6800 son 50$ o € más que la 3070 y la 6800xt son 50€$/€ menos que la 3080.

a parte de esa diferencia de precio, no hay que olvidar que la 6800xt va a rebufo de la 6900xt

Blackpo92 escribió:VanSouls escribió:PepeC12 escribió:@Blackpo92 estoy dando el precio con iva incluido tio, lee bien.

para simplificar, la 6800 son 50$ o € más que la 3070 y la 6800xt son 50€$/€ menos que la 3080.

a parte de esa diferencia de precio, no hay que olvidar que la 6800xt va a rebufo de la 6900xt

No digo yo que no, lo que yo me niego a creer es que Nvidia haya sacado la 3070 y 3080 con la vram que llevan para quedarse cortas enseguida y tener que sacar modelos "súper o TI" que además no vas a poder vender mucho más caras porque se solapan con las anteriores, a parte de que cómo dije antes me parece una estafa al consumidor directamente.

leto escribió:Yo creo que las sacaran con mas memoria, si !!!, pero mas caras , lo importante es que en el mercado tengas donde elegir, Si yo en su dia hubiese podido comprar una 1080ti con menos memoria , y me hubiese constado 150€ menos la hubiese comprado, porque de todo el tiempo que la usé , nunca llegue a las de 7gb. Por lo tanto yo estoy contento con la relación precio memoria. Si tengo que pagar mas por mas memoria , quizas me hubiese pensado comprar una 3080.

Es mi punto de vista.

Blackpo92 escribió:VanSouls escribió:a parte de esa diferencia de precio, no hay que olvidar que la 6800xt va a rebufo de la 6900xt

No digo yo que no, lo que yo me niego a creer es que Nvidia haya sacado la 3070 y 3080 con la vram que llevan para quedarse cortas enseguida y tener que sacar modelos "súper o TI" que además no vas a poder vender mucho más caras porque se solapan con las anteriores, a parte de que cómo dije antes me parece una estafa al consumidor directamente.