darksch escribió:Si piensas eso es que no lo has entendido. Porque no concuerda ni una sola.

Szasz escribió:HSA es la FUSION de CPU y GPU, lo q lleva buscando AMD desde q desarrolló la primera APU (advanced processor unit).

No hay GPU y CPU como tal (físicamente sí, pero para el desarrollador no). La APU gestiona cuando usa la GPU y la CPU, dependiendo de la tarea a realizar.

Por eso AMD habla de 12 compute cores en kavery. 4 cores de CPU + 8 cores de GPU.

El software llegará, el HSA es el siguiente paso evolutivo en CPUs.

Szasz escribió:No hay GPU y CPU como tal (físicamente sí, pero para el desarrollador no).

josemurcia escribió:Yo veo también las APUs como el futuro de las CPUs, pero precisamente por eso veo que una GPU dedicada nunca va a poder sustituirse por una APU, y más bien la GPU de la APU podrá encargarse de parte del GPGPU dejando a la GPU dedicada más espacio para gráficos.

josemurcia escribió:Volvemos a lo de siempre, HSA no parece ser de ninguna utilidad en consolas, donde ya se supone que cada parte hace lo que mejor sabe hacer y la memoria es compartida.

Mulzani escribió:Luego, resulta que el principal software que puede aprovecharse actualmente de HSA pertenece a tu competencia, es decir, dos de los motores de físicas con más licencias pertenecen a Nvidia, con PhysX, y a Intel, con Havok.

Szasz escribió:No, no tengo info del desarrollo en HSA, es un poco especulación por lo q he ido leyendo sobre el HSA, q el objetivo es facilitar el trabajo al desarrollador.

darksch escribió:...

josemurcia escribió:Phil Spencer estará en la conferencia del PC en el e3, seguramente tengamos demostración de DX12 por todo lo alto.

eloskuro escribió:josemurcia escribió:Phil Spencer estará en la conferencia del PC en el e3, seguramente tengamos demostración de DX12 por todo lo alto.

Yo creo que explicarán lo del cross buy entre xbo y pc

Mulzani escribió:@eloskuro

El problema es cuando te responden diciendo "no tienes ni puta idea" y se queda tan pancho. Al menos quería exponer lo que estaba diciendo y desarrollarlo un poco, quizá así entendiera mis palabras.

darksch escribió:@Mulzani se entiende que no es GPGPU tradicional. No empecemos con la semántica.

Y en esa diapositiva se explica todo perfectamente, no se para que voy a repetir exactamente lo que pone, porque mejor no sabría explicarlo la verdad. Así que menos bullshits y un poco de lectura antes de criticar.

darksch escribió:@Mulzani se entiende que no es GPGPU tradicional. No empecemos con la semántica.

Y en esa diapositiva se explica todo perfectamente, no se para que voy a repetir exactamente lo que pone, porque mejor no sabría explicarlo la verdad. Así que menos bullshits y un poco de lectura antes de criticar.

Mulzani escribió:Luego, Intel sí es el mayor vendendor de APUs, otra cosa es que no permitan el uso de HSA ni tengan sus características, pero todos (o casi todos) los procesadores de socket 115x son APUs, y sí, está desarrollando una tecnología similar, al menos en el hecho de compartir la memoria entre la GPU y la CPU de sus APUs y usarlas como SIMD:

http://wccftech.com/article/exploring-a ... d-part-ii/

cercata escribió:Mulzani escribió:Luego, Intel sí es el mayor vendendor de APUs, otra cosa es que no permitan el uso de HSA ni tengan sus características, pero todos (o casi todos) los procesadores de socket 115x son APUs, y sí, está desarrollando una tecnología similar, al menos en el hecho de compartir la memoria entre la GPU y la CPU de sus APUs y usarlas como SIMD:

http://wccftech.com/article/exploring-a ... d-part-ii/

Que es SIMD ?

Sacado de ese enlace, no se sabe aun que tiene Intel entre manos:

"It’s not quite clear yet if Intel’s approach is going to completely mitigate the need for explicit data copies between the CPU and the GPU to maintain coherency."

dejan claro que HSA es GPGPU y algo más

se llama Intel y ya está desarrollando algo similar a HSA, pero a nivel de instrucciones con AVX 3.2

luego muestra como funciona con un FX+GPU

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

argam escribió:Single Instruction Multiple Data.

http://en.wikipedia.org/wiki/SIMD

Una operacion se realiza sobre muchos datos.

AMD's global head of technical marketing Robert Hallock [url="http://www.computerbase.de/2015-06/directx-12-amd-radeon-feature-level-12-0-gcn/"]confirmed to Computerbase[/url] GCN-based graphics cards will support DX12 and at least some will also support DX12 feature level 12_0. Computerbase mentions Tonga, Hawaii and the Xbox One GPU will surely support 12_0, however question marks remain for older chipsets like Bonaire, Tahiti and Pitcairn.

Meanwhile, Nvidia confirmed earlier their chipsets GM200, GM204 and GM206 will already support DX12 feature level 12_1. At GDC this year, MS gave an overview of feature level 12_0 and 12_1:

Hallock said it shouldn't be an issue that AMD cards only support feature level 12_0 since all the features relevant for games are included in 11_1 and 12_0. Also, most games will stick closely to what the consoles use and will therefore mostly use 12_0. Keep in mind, though, he's the global head of technical marketing, so his words shouldn't just be taken as gospel. Computerbase also pointed out Nvidia said the same thing when their Kepler cards didn't support feature level 11_1.

tl;dr: If you want a fully compatible DX12 card you should look into getting a Nvidia GTX 960, 970, 980, 980 Ti or Titan X. Or wait until more information regarding AMD's upcoming Fiji card(s) are released.

David Ricardo escribió:AMD confirma que las gpus gcn, incluyendo la que lleva xbox one, soportarán las features 12.0 de directx12. No soportarán sin embargo las features 12.1, las cuales quedan reservadas para las últimas tarjetas de Nvidia. Os dejo quote del hilo de Neogaf:AMD's global head of technical marketing Robert Hallock [url="http://www.computerbase.de/2015-06/directx-12-amd-radeon-feature-level-12-0-gcn/"]confirmed to Computerbase[/url] GCN-based graphics cards will support DX12 and at least some will also support DX12 feature level 12_0. Computerbase mentions Tonga, Hawaii and the Xbox One GPU will surely support 12_0, however question marks remain for older chipsets like Bonaire, Tahiti and Pitcairn.

Meanwhile, Nvidia confirmed earlier their chipsets GM200, GM204 and GM206 will already support DX12 feature level 12_1. At GDC this year, MS gave an overview of feature level 12_0 and 12_1:

Hallock said it shouldn't be an issue that AMD cards only support feature level 12_0 since all the features relevant for games are included in 11_1 and 12_0. Also, most games will stick closely to what the consoles use and will therefore mostly use 12_0. Keep in mind, though, he's the global head of technical marketing, so his words shouldn't just be taken as gospel. Computerbase also pointed out Nvidia said the same thing when their Kepler cards didn't support feature level 11_1.

tl;dr: If you want a fully compatible DX12 card you should look into getting a Nvidia GTX 960, 970, 980, 980 Ti or Titan X. Or wait until more information regarding AMD's upcoming Fiji card(s) are released.

http://m.neogaf.com/showthread.php?t=1056976

Imagen con las diferencias entre feature set 12.0 y 12.1

http://postimg.org/image/fd4kuk85v/full/

J_Ark escribió:Pues parece que no sabían lo que estaban haciendo cuando creaban la Xbox One.

josemurcia escribió:Lo lógico, por mucho que hubiera gente empeñada en decir que la GPU de ONE era 100% DX12.

De todas formas esto va mejor en su hilo.

David Ricardo escribió:Hallock said it shouldn't be an issue that AMD cards only support feature level 12_0 since all the features relevant for games are included in 11_1 and 12_0. Also, most games will stick closely to what the consoles use and will therefore mostly use 12_0.

cercata escribió:David Ricardo escribió:Hallock said it shouldn't be an issue that AMD cards only support feature level 12_0 since all the features relevant for games are included in 11_1 and 12_0. Also, most games will stick closely to what the consoles use and will therefore mostly use 12_0.

¿ Y que features son las que trae 12_1 para que digan eso ?

cercata escribió:David Ricardo escribió:Hallock said it shouldn't be an issue that AMD cards only support feature level 12_0 since all the features relevant for games are included in 11_1 and 12_0. Also, most games will stick closely to what the consoles use and will therefore mostly use 12_0.

¿ Y que features son las que trae 12_1 para que digan eso ?

Szasz escribió:Son las features q presentaron con un juego de Xbox One, Fable legends.

El artículo habla de un amigo, de un amigo me ha dicho....

No creo q hablarán de Xbox One, sino de las arquitectura GCN y ya sabemos q de las actúales, ninguna es 12_1.

Me parece una interpretación del redactor. El cual puede estar en lo cierto o no. Confirmación no veo ninguna.

josemurcia escribió:cercata escribió:David Ricardo escribió:Hallock said it shouldn't be an issue that AMD cards only support feature level 12_0 since all the features relevant for games are included in 11_1 and 12_0. Also, most games will stick closely to what the consoles use and will therefore mostly use 12_0.

¿ Y que features son las que trae 12_1 para que digan eso ?

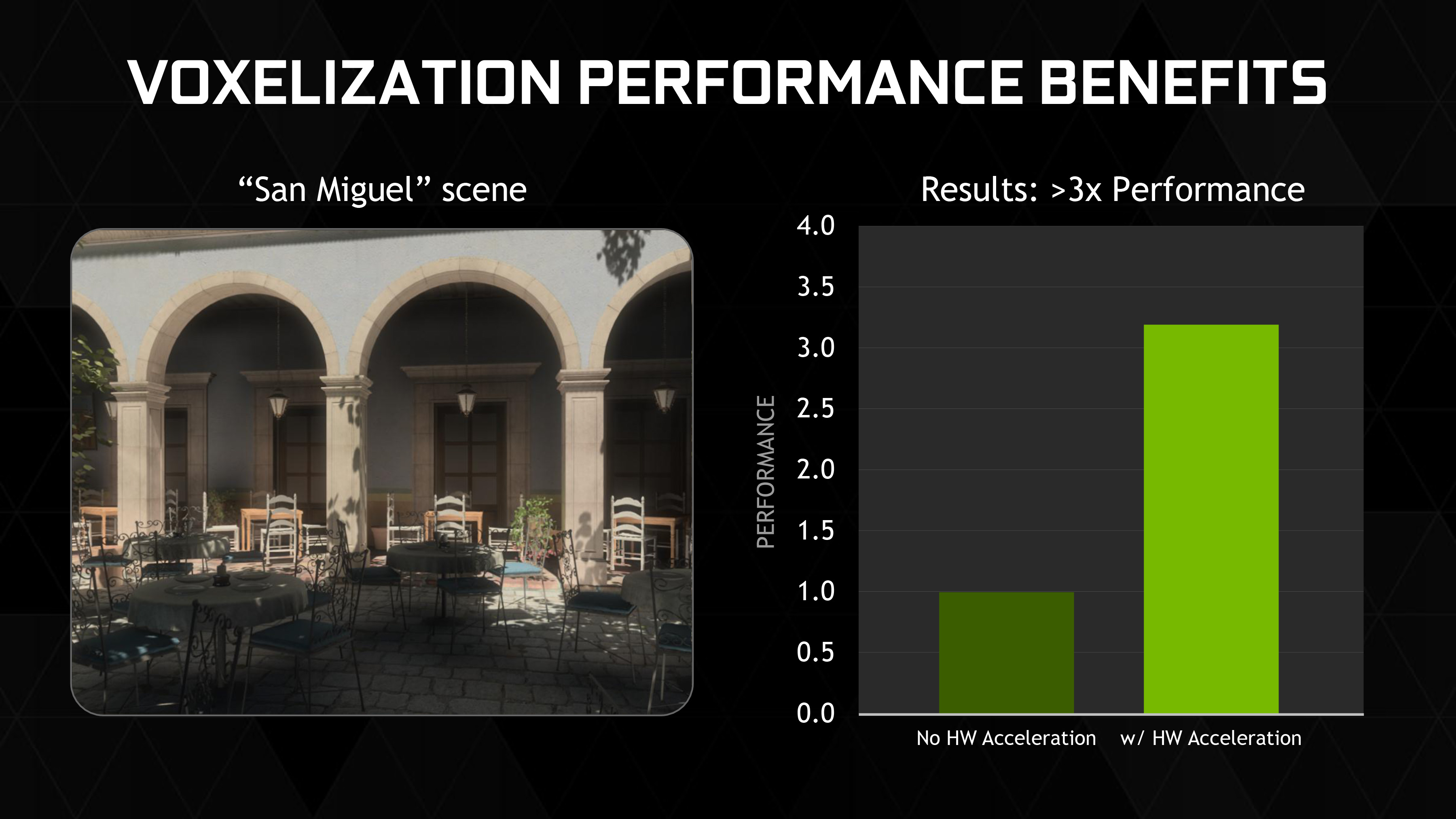

Según NVIDIA, el uso de estas características puede hacer las técnicas de voxelización hasta 3 veces más rápidas. Por ejemplo en su VXGI.

Con lo cual estamos hablando de una mejora importante respecto al FL12.0.

![fumando [fumando]](/images/smilies/nuevos/fumando.gif)

Nuhar escribió:Entonces soporta dx12.0 pero no dx12.1?

Asi que la gente que dijo que soportaba dx12.0 al 100% tendría razon, no?

Nuhar escribió:Entonces soporta dx12.0 pero no dx12.1?

Asi que la gente que dijo que soportaba dx12.0 al 100% tendría razon, no?

josemurcia escribió:Nuhar escribió:Entonces soporta dx12.0 pero no dx12.1?

Asi que la gente que dijo que soportaba dx12.0 al 100% tendría razon, no?

Lo soporta exactamente igual que las gráficas AMD que salieron ese mismo trimestre, lo que llevamos muchos diciendo desde el principio.Nuhar escribió:Entonces soporta dx12.0 pero no dx12.1?

Asi que la gente que dijo que soportaba dx12.0 al 100% tendría razon, no?

No hay DX12.1, hay DX12.0 con 4 niveles de compatibilidad por hardware: 11.0, 11.1, 12.0 y 12.1.

Soportar DX12 al 100% es ser feature level 12.1, cosa que solo soporta Maxwell ahora mismo.

Morepawer escribió:Coño, por ahora las perpectivas en X1 son cojonudas. Dx12.0 y por ahora compatibilidad por hardware 12.0. Hemos saltado de Bonaire o lo ya sabemos 100% seguro asi que me siento satisfecho. Si se confirma mas adelante que tendra 12.1 al menos por software estaremos de enhorabuena. Al caballo regalado no le mires los dientes.

josemurcia escribió:Morepawer escribió:Coño, por ahora las perpectivas en X1 son cojonudas. Dx12.0 y por ahora compatibilidad por hardware 12.0. Hemos saltado de Bonaire o lo ya sabemos 100% seguro asi que me siento satisfecho. Si se confirma mas adelante que tendra 12.1 al menos por software estaremos de enhorabuena. Al caballo regalado no le mires los dientes.

Bonaire también es nivel 12.0.

![fumando [fumando]](/images/smilies/nuevos/fumando.gif)

josemurcia escribió:El medio alemán ha estado en la Computex Taipei y ha hablado con el director de global marketing técnico de AMD. ¿Por qué dices que el alemán miente al decir que se lo ha dicho Robert Hallock y son suposiciones suyas?

Que Bonaire es 12.0 es un hecho, eso no lo ha dicho el alemán, eso lo dice el propio driver beta de AMD para W10.

josemurcia escribió:El medio alemán ha estado en la Computex Taipei y ha hablado con el director de global marketing técnico de AMD. ¿Por qué dices que el alemán miente al decir que se lo ha dicho Robert Hallock y son suposiciones suyas?

Que Bonaire es 12.0 es un hecho, eso no lo ha dicho el alemán, eso lo dice el propio driver beta de AMD para W10.

eloskuro escribió:josemurcia escribió:El medio alemán ha estado en la Computex Taipei y ha hablado con el director de global marketing técnico de AMD. ¿Por qué dices que el alemán miente al decir que se lo ha dicho Robert Hallock y son suposiciones suyas?

Que Bonaire es 12.0 es un hecho, eso no lo ha dicho el alemán, eso lo dice el propio driver beta de AMD para W10.

Da igual el aleman a dicho "surely" . Si AMD le ha dicho surely es que no le han dicho nada y es suposición de el. No crees?

Morepawer escribió:josemurcia escribió:El medio alemán ha estado en la Computex Taipei y ha hablado con el director de global marketing técnico de AMD. ¿Por qué dices que el alemán miente al decir que se lo ha dicho Robert Hallock y son suposiciones suyas?

Que Bonaire es 12.0 es un hecho, eso no lo ha dicho el alemán, eso lo dice el propio driver beta de AMD para W10.

Donde he dicho yo que mienta?.

Entonces seguimos con las mismas de siempre. X1 monta bonaire, no?

josemurcia escribió:eloskuro escribió:josemurcia escribió:El medio alemán ha estado en la Computex Taipei y ha hablado con el director de global marketing técnico de AMD. ¿Por qué dices que el alemán miente al decir que se lo ha dicho Robert Hallock y son suposiciones suyas?

Que Bonaire es 12.0 es un hecho, eso no lo ha dicho el alemán, eso lo dice el propio driver beta de AMD para W10.

Da igual el aleman a dicho "surely" . Si AMD le ha dicho surely es que no le han dicho nada y es suposición de el. No crees?

¿Dónde dice el alemán surely? Porque para empezar está el artículo escrito en alemán y no en inglés.

Según Google Translate dice que Tonga, Carrizo y la GPU de ONE seguro, y que por lo tanto Hawai es probable que también.Morepawer escribió:josemurcia escribió:El medio alemán ha estado en la Computex Taipcei y ha hablado con el director de global marketing técnico de AMD. ¿Por qué dices que el alemán miente al decir que se lo ha dicho Robert Hallock y son suposiciones suyas?

Que Bonaire es 12.0 es un hecho, eso no lo ha dicho el alemán, eso lo dice el propio driver beta de AMD para W10.

Donde he dicho yo que mienta?.

Entonces seguimos con las mismas de siempre. X1 monta bonaire, no?

No he dicho que monte Bonaire, he dicho que tiene el mismo nivel de compatibilidad por hardware con DX12 que Bonaire.

Tonga y así también el nuevo Carrizo-APU puede hacer esto en cualquier caso, ya que la GPU de la Xbox Uno y por lo tanto probablemente el Hawaii-GPU. La cuestión es, sin embargo, en Bonaire, pero especialmente en el chip más antigua, Tahití, Pitcairn y Cabo Verde. H intenta en este sentido aún para más información.

Tonga und so auch die neue Carrizo-APU können dies auf jeden Fall, ebenso die GPU der Xbox One und damit wahrscheinlich auch die Hawaii-GPU.