![facepalm [facepalm]](/images/smilies/facepalm.gif)

![facepalm [facepalm]](/images/smilies/facepalm.gif)

Nomada_Firefox escribió:Putoskizzo escribió:Menuda chorrada, eso será para los que necesitan poner todas las settings a la derecha, se baja la calidad de las texturas y listo. Los desarrolladores no se van a pegar un tiro en el pie haciendo que su juego solo funcione bien en un 10% de los ordenadores del mercado

Evidentemente pero......... viene la pregunta ¿gastarias 600/700€ en una grafica para tener que bajar el detalle en un juego? y no hablamos de dentro de años, ahora mismo te puede suceder.

uchi23a escribió:@KindapearHD

Uff mucho tiene que bajar los settings, tuve una 770 evga versión Fe que vendí para uno para pc de photoshop, frente a la 7950 ya se la comía con patatas sin necesidad de compararla con la hd7970.

> El 1gb extra se notaba (2 vs 3 mucho) salvo que te de por ponerlo praticamente al minimo o a 1,7gb de uso de vram.

En cuanto a Unreal Engine 5.1 debería aprovechar mas la ram, por no optimizar nada lo cargar todo en la vram en vez de la ram...

Seria razonable tener 8gb de vram y 64gb de ram para 8K pero ya 19gb vram en 1440p

Ashenbach escribió:Yo tengo una 970 y he jugado al The Last of Us con 0 problemas a 1080p (con todo al mínimo y creo que a 30 fps). Hace nada me he terminado el Jedi Fallen Order, también a 1080p y bajando un poco los settings y ayer empecé el Sherlock Holmes, que de momento lo estoy jugando tb con los settings en alto (no en máximo) y va muy bien.

Lastima que Nvidia no comparta el DLSS3 con sus graficas anteriores, cosa que seguramente si suceda con el FSR3 y las RX6000.

Lastima que Nvidia no comparta el DLSS3 con sus graficas anteriores, cosa que seguramente si suceda con el FSR3 y las RX6000. uchi23a escribió:@KindapearHD

Uff mucho tiene que bajar los settings, tuve una 770 evga versión Fe que vendí para uno para pc de photoshop, frente a la 7950 ya se la comía con patatas sin necesidad de compararla con la hd7970.

> El 1gb extra se notaba (2 vs 3 mucho) salvo que te de por ponerlo praticamente al minimo o a 1,7gb de uso de vram.

En cuanto a Unreal Engine 5.1 debería aprovechar mas la ram, por no optimizar nada lo cargar todo en la vram en vez de la ram...

Seria razonable tener 8gb de vram y 64gb de ram para 8K pero ya 19gb vram en 1440p

KindapearHD escribió:uchi23a escribió:@KindapearHD

Uff mucho tiene que bajar los settings, tuve una 770 evga versión Fe que vendí para uno para pc de photoshop, frente a la 7950 ya se la comía con patatas sin necesidad de compararla con la hd7970.

> El 1gb extra se notaba (2 vs 3 mucho) salvo que te de por ponerlo praticamente al minimo o a 1,7gb de uso de vram.

En cuanto a Unreal Engine 5.1 debería aprovechar mas la ram, por no optimizar nada lo cargar todo en la vram en vez de la ram...

Seria razonable tener 8gb de vram y 64gb de ram para 8K pero ya 19gb vram en 1440p

Obviamente hay que jugar con los settings en bajo, pero hablamos de una gpu con 2gb d vram con 10 años a la espalda.

Pueden salir las noticias y los nostradamus que quieran pero luego ves estas cosas y te olvidas.

Ni obsoletas ni nada. Que habrá que bajar settings? Claro, nadie se compra una 4060/4070 para jugar a full. Siempre habrá juegos top donde toque bajar settings.

parh escribió:KindapearHD escribió:uchi23a escribió:@KindapearHD

Uff mucho tiene que bajar los settings, tuve una 770 evga versión Fe que vendí para uno para pc de photoshop, frente a la 7950 ya se la comía con patatas sin necesidad de compararla con la hd7970.

> El 1gb extra se notaba (2 vs 3 mucho) salvo que te de por ponerlo praticamente al minimo o a 1,7gb de uso de vram.

En cuanto a Unreal Engine 5.1 debería aprovechar mas la ram, por no optimizar nada lo cargar todo en la vram en vez de la ram...

Seria razonable tener 8gb de vram y 64gb de ram para 8K pero ya 19gb vram en 1440p

Obviamente hay que jugar con los settings en bajo, pero hablamos de una gpu con 2gb d vram con 10 años a la espalda.

Pueden salir las noticias y los nostradamus que quieran pero luego ves estas cosas y te olvidas.

Ni obsoletas ni nada. Que habrá que bajar settings? Claro, nadie se compra una 4060/4070 para jugar a full. Siempre habrá juegos top donde toque bajar settings.

Pero estas hablando en serio? jugando con calidad PS3 claro que tu 4070ti te podra durar hasta 2032 sin problemas. Pero que yo sepa, quien invierte en PC espera jugar con calidad PC que siempre es jugar mejor que en consolas.

parh escribió:KindapearHD escribió:uchi23a escribió:@KindapearHD

Uff mucho tiene que bajar los settings, tuve una 770 evga versión Fe que vendí para uno para pc de photoshop, frente a la 7950 ya se la comía con patatas sin necesidad de compararla con la hd7970.

> El 1gb extra se notaba (2 vs 3 mucho) salvo que te de por ponerlo praticamente al minimo o a 1,7gb de uso de vram.

En cuanto a Unreal Engine 5.1 debería aprovechar mas la ram, por no optimizar nada lo cargar todo en la vram en vez de la ram...

Seria razonable tener 8gb de vram y 64gb de ram para 8K pero ya 19gb vram en 1440p

Obviamente hay que jugar con los settings en bajo, pero hablamos de una gpu con 2gb d vram con 10 años a la espalda.

Pueden salir las noticias y los nostradamus que quieran pero luego ves estas cosas y te olvidas.

Ni obsoletas ni nada. Que habrá que bajar settings? Claro, nadie se compra una 4060/4070 para jugar a full. Siempre habrá juegos top donde toque bajar settings.

Pero estas hablando en serio? jugando con calidad PS3 claro que tu 4070ti te podra durar hasta 2032 sin problemas. Pero que yo sepa, quien invierte en PC espera jugar con calidad PC que siempre es jugar mejor que en consolas de ultima generacion

KindapearHD escribió:nadie se compra una 4060/4070 para jugar a full.

LostsoulDark escribió:Yo creo que no, la mayoria se arma un PC gamer para simplemente jugar y con la configuracion que le alcance o solo quiera gastar, la encuesta de Steam lo deja claro.

parh escribió:KindapearHD escribió:uchi23a escribió:@KindapearHD

Uff mucho tiene que bajar los settings, tuve una 770 evga versión Fe que vendí para uno para pc de photoshop, frente a la 7950 ya se la comía con patatas sin necesidad de compararla con la hd7970.

> El 1gb extra se notaba (2 vs 3 mucho) salvo que te de por ponerlo praticamente al minimo o a 1,7gb de uso de vram.

En cuanto a Unreal Engine 5.1 debería aprovechar mas la ram, por no optimizar nada lo cargar todo en la vram en vez de la ram...

Seria razonable tener 8gb de vram y 64gb de ram para 8K pero ya 19gb vram en 1440p

Obviamente hay que jugar con los settings en bajo, pero hablamos de una gpu con 2gb d vram con 10 años a la espalda.

Pueden salir las noticias y los nostradamus que quieran pero luego ves estas cosas y te olvidas.

Ni obsoletas ni nada. Que habrá que bajar settings? Claro, nadie se compra una 4060/4070 para jugar a full. Siempre habrá juegos top donde toque bajar settings.

Pero estas hablando en serio? jugando con calidad PS3 claro que tu 4070ti te podra durar hasta 2032 sin problemas. Pero que yo sepa, quien invierte en PC espera jugar con calidad PC que siempre es jugar mejor que en consolas de ultima generacion

Nomada_Firefox escribió:KindapearHD escribió:nadie se compra una 4060/4070 para jugar a full.

Eso que dices no tienen ningun sentido de ser, ni razonamiento alguno. Yo he comprado casi siempre graficas de esa linea y siempre con la idea de que al menos mientras la generación este vigente, puedas jugar a todo a tope.

Ashenbach escribió:uchi23a escribió:@KindapearHD

Uff mucho tiene que bajar los settings, tuve una 770 evga versión Fe que vendí para uno para pc de photoshop, frente a la 7950 ya se la comía con patatas sin necesidad de compararla con la hd7970.

> El 1gb extra se notaba (2 vs 3 mucho) salvo que te de por ponerlo praticamente al minimo o a 1,7gb de uso de vram.

En cuanto a Unreal Engine 5.1 debería aprovechar mas la ram, por no optimizar nada lo cargar todo en la vram en vez de la ram...

Seria razonable tener 8gb de vram y 64gb de ram para 8K pero ya 19gb vram en 1440p

Bueno, pero jugar se puede.

Yo tengo una 970 y he jugado al The Last of Us con 0 problemas a 1080p (con todo al mínimo y creo que a 30 fps). Hace nada me he terminado el Jedi Fallen Order, también a 1080p y bajando un poco los settings y ayer empecé el Sherlock Holmes, que de momento lo estoy jugando tb con los settings en alto (no en máximo) y va muy bien.

Desde luego que me jodería pagar 700€ para no poder jugar en ultra a 1440p, pero es que eso ya tampoco depende de mi, por desgracia, las consolas regulan el mercado y los desarrolladores (o al menos, muchos de ellos) no se esfuerzan en optimizar sus juegos para que las tarjetas destinadas a jugar en 1440p puedan hacerlo en condiciones óptimas.

KindapearHD escribió:Dependerá de la resolución y los frame que esperes tener.

Yo no me compro una 4060/4070 si mi idea es jugar a 4K con todo al máximo, a 120 fps, RT incluido, etc.

NADIE SE COMPRA UNA 4060/4070 PARA JUGAR A FULL.

NanakiXIII escribió:Ashenbach escribió:uchi23a escribió:@KindapearHD

Uff mucho tiene que bajar los settings, tuve una 770 evga versión Fe que vendí para uno para pc de photoshop, frente a la 7950 ya se la comía con patatas sin necesidad de compararla con la hd7970.

> El 1gb extra se notaba (2 vs 3 mucho) salvo que te de por ponerlo praticamente al minimo o a 1,7gb de uso de vram.

En cuanto a Unreal Engine 5.1 debería aprovechar mas la ram, por no optimizar nada lo cargar todo en la vram en vez de la ram...

Seria razonable tener 8gb de vram y 64gb de ram para 8K pero ya 19gb vram en 1440p

Bueno, pero jugar se puede.

Yo tengo una 970 y he jugado al The Last of Us con 0 problemas a 1080p (con todo al mínimo y creo que a 30 fps). Hace nada me he terminado el Jedi Fallen Order, también a 1080p y bajando un poco los settings y ayer empecé el Sherlock Holmes, que de momento lo estoy jugando tb con los settings en alto (no en máximo) y va muy bien.

Desde luego que me jodería pagar 700€ para no poder jugar en ultra a 1440p, pero es que eso ya tampoco depende de mi, por desgracia, las consolas regulan el mercado y los desarrolladores (o al menos, muchos de ellos) no se esfuerzan en optimizar sus juegos para que las tarjetas destinadas a jugar en 1440p puedan hacerlo en condiciones óptimas.

Yo el fallen order lo intenté jugar con mi vieja 970 e imposible. Llegaba un punto que el juego pegaba un stuttering de cojones.

KindapearHD escribió:

Dependerá de la resolución y los frame que esperes tener.

Yo no me compro una 4060/4070 si mi idea es jugar a 4K con todo al máximo, a 120 fps, RT incluido, etc.

Nomada_Firefox escribió:KindapearHD escribió:Dependerá de la resolución y los frame que esperes tener.

Yo no me compro una 4060/4070 si mi idea es jugar a 4K con todo al máximo, a 120 fps, RT incluido, etc.

Es que por logica general, una 4060 es una grafica de 1080p y la 4070 de 1440p, hasta seguramente la caja de la grafica lo ponga, igual que sucede con los modelos de AMD.

Si alguien se compra una 4060 para 4K, pues.......no recuerdo haber visto nadie con esa idea en graficas de esa gama, absolutamente nadie. Alguno habra, pero no es normal.

Pero no intentes cambiar lo que has dicho, editalo si quieres. Porque posiblemente nadie compre esas graficas para 4K............ni se venden para ello.NADIE SE COMPRA UNA 4060/4070 PARA JUGAR A FULL.

Te has equivocado y no hay ninguna verguenza por ello.

@NanakiXIII Con una 970 no pero con una 1060 si que lo he jugado. En 1080p lo mueve perfectisimamente.

Wookiee escribió:KindapearHD escribió:

Dependerá de la resolución y los frame que esperes tener.

Yo no me compro una 4060/4070 si mi idea es jugar a 4K con todo al máximo, a 120 fps, RT incluido, etc.

Es que no es preciso 4k, ni 120fps, ni RT. La 3060 con sus "machacantes" 12GB de vram no permite actualmente jugar a todo con todo a tope sin RT a 1080p y 60fps estables, y apenas llevamos 3 años de gen... ¿Que sentido tendría la segmentación en las gpu si con la gama de entrada te permitiera hacer eso? Los juegos tienen settings gráficos precisamente para hacer posible jugar a todo con una calidad y velocidad de cuadros adecuada con el grueso del hard del momento. Además, todos los años sacan algún "Crysis" devora recursos (y si no se lo inventan con parches como ha pasado con cyberpunk).

FranciscoVG escribió:El resumen parece ser claro, nvidia se equivoco poniendo 8Gb a la 3070, con 4Gb hubiesen sido suficientes total no importan xd

Nomada_Firefox escribió:KindapearHD escribió:nadie se compra una 4060/4070 para jugar a full.

Eso que dices no tienen ningun sentido de ser, ni razonamiento alguno. Yo he comprado casi siempre graficas de esa linea y siempre con la idea de que al menos mientras la generación este vigente, puedas jugar a todo a tope.LostsoulDark escribió:Yo creo que no, la mayoria se arma un PC gamer para simplemente jugar y con la configuracion que le alcance o solo quiera gastar, la encuesta de Steam lo deja claro.

No es que lo espere, es que siguiendo esta logica que dices, no tienes más remedio.

Pero esa logica que comentas no tiene sentido ni relata a la mayoria de usuarios de Steam.

La gente que se monta un PC gamer en una torre, tiene una idea buena de para que lo quiere y lo que espera de el. Todo lo demas seran equipos OEM o gente que no sabe que compra. Por supuesto que todos compramos acorde a lo que podemos gastar y esperamos jugar acorde a eso.

Y luego esta muchisima gente, de esa lista de steam con portatiles. Que se pueden englobar en saben lo que hacen, no tienen ni idea, gente que heredo el portatil de un familiar y gente que se tiene que conformar con lo que hay.

Y que te alcance o quieras gastar es practicamente lo mismo. Al final es lo que gastas.

![pelota [boing]](/images/smilies/nuevos/pelota_ani1.gif) Desmonta por completo el argumento de los 8gb, si no lo estaba ya.

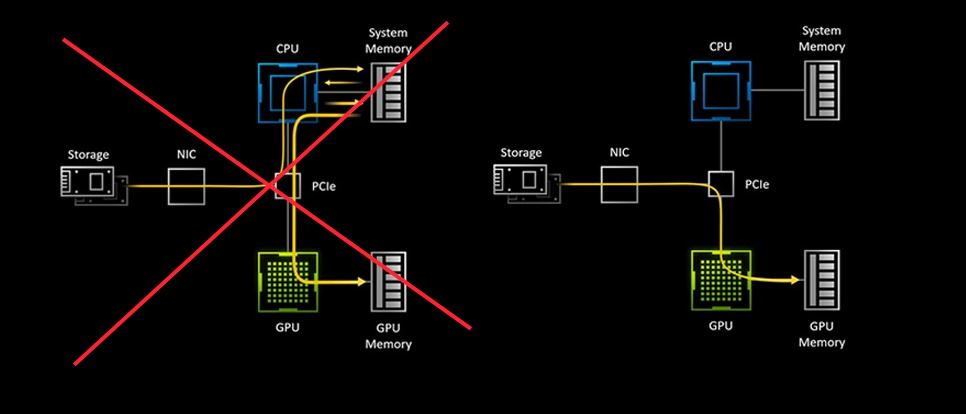

Desmonta por completo el argumento de los 8gb, si no lo estaba ya. chris76 escribió:Y yo que creia que el DirectStorage era para librar la Vram de las GPUs…

BladeRunner escribió:@chris76 parece q sólo es para liberar de esa carga de trabajo a la CPU, y pasarla a la GPU.

chris76 escribió:Y yo que creia que el DirectStorage era para librar la Vram de las GPUs…

A 1080P obviamente si lo van a hacer. Y dicho esto, yo con una RTX 4000, no activo el RT porque ni me parece necesario, ni me parece increíble y resta muchisimo rendimiento.

BladeRunner escribió:@AxelStone y ya están trabajando en el concepto de butterfly effect tracing para la series RTX 7000.

@Wookiee no sé, algo me dice q es más rápido tirar de RAM si se tiene capacidad de sobra q de SSD. Habrá una carga inicial más lenta pero ya dentro del juego todo debería ir perfecto. Pero ojalá ayude a gestionar mejor la VRAM.

chris76 escribió:Y yo que creia que el DirectStorage era para librar la Vram de las GPUs…

VíctorXD escribió:chris76 escribió:Y yo que creia que el DirectStorage era para librar la Vram de las GPUs…

Depende si se hace un streaming agresivo de texturas ,si que debería liberar bastante espació en la VRAM , ya que solo los mips Maps mas necesarios de las textura estarían en la VRAM y todo lo demás mip maps se haría por streaming al vuelo desde el SSD.

Nomada_Firefox escribió:VíctorXD escribió:chris76 escribió:Y yo que creia que el DirectStorage era para librar la Vram de las GPUs…

Depende si se hace un streaming agresivo de texturas ,si que debería liberar bastante espació en la VRAM , ya que solo los mips Maps mas necesarios de las textura estarían en la VRAM y todo lo demás mip maps se haría por streaming al vuelo desde el SSD.

Estais equivocados vos. Las texturas seguiran cargandose en la vram.......lo unico que hace el directstorage es agilizar la lectura. Sino se cargan en la vram, nunca se pintaran en el juego.

Nomada_Firefox escribió:Lo cierto es que ya se publico alguna prueba sintetica de esto y la ganancia de rendimiento era inexistente.

@VíctorXD Yo no digo que no reduzca el tiempo de lectura de texturas pero las tarjetas y los juegos cargan todas las texturas de un escenario de una tacada, sin repetir nada aunque un objeto este multiplicado en pantalla. Lo que quiero decir es esto ssd--->grafica-->pantalla en pocas palabras, asi que la idea de permitir ir leyendo y cargando acelerando todo no es tan asi porque habra momentos en el cual sature la memoria tanto como antes sino tienes una cantidad grande. La idea del direcstorage es que las texturas HD no ralenticen la carga pero eso no supone más velocidad jugando.

Cuando salgan juegos con esto, acabaremos por verlo en funcionamiento.

Nomada_Firefox escribió:Quizas me explique mal. Vosotros estais pensando que las tarjetas graficas y los juegos van a funcionar de otro modo pero la realidad es que esto no va a hacer eso. Lo unico que hace es crear un almacenamiento en el SSD donde se almacenaran las texturas descomprimidas ahorrando tiempo de procesamiento, pero ocupar en memoria, van a ocupar lo mismo y los juegos no van a correr más rapido.

Hay que entender que las texturas de los juegos son texturas comprimidas y la grafica tiene que descomprimirlas, cosa que lleva tiempo con texturas muy grandes. Con el directstorage ahorran ese tiempo.

Pensais que se salta la vram y no es asi. En fin, cuando salgan juegos con esto, lo veremos funcionar en vivo.

Y evidentemente los de Epic lo saben. Que esto no va a ahorrar vram, más bien todo lo contrario porque van a cargar unas texturas enormes en la memoria que se va a seguir usando.

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

y te cruzas muy a menudo con camiones cisterna q te pueden llenar el depósito a demanda, de forma automática y sin pararte (ésto último lo pueden hacer los aviones). Los camiones cisterna son el SSD/HDD. Si funcionara bien la tecnología igual no habría mucha diferencia entre un depósito de 8L y otro de 24L.

y te cruzas muy a menudo con camiones cisterna q te pueden llenar el depósito a demanda, de forma automática y sin pararte (ésto último lo pueden hacer los aviones). Los camiones cisterna son el SSD/HDD. Si funcionara bien la tecnología igual no habría mucha diferencia entre un depósito de 8L y otro de 24L. ![disimulando [fiu]](/images/smilies/fiu.gif)

VíctorXD escribió:La descompresión al ser por GPU será más rápida por cual se ahorrará un poco de latencia.

Nueva API GetCompressionSupport

DirectStorage actualmente elige la ruta de descompresión para los formatos de compresión integrados en función de las capacidades compatibles de la GPU. Hay escenarios en los que se elige una ruta alternativa basada en CPU.

Escuchamos de los desarrolladores que sería beneficioso comprender qué ruta de descompresión se está utilizando para que la configuración de resolución de textura predeterminada se pueda establecer en función de esto. Para habilitar esto, agregamos una nueva API para consultar qué ruta ha elegido el tiempo de ejecución.

IDStorageQueue2::GetCompressionSupport() devuelve un valor que indica si se usa una implementación optimizada de GPU, un respaldo de GPU para un respaldo de CPU para la descompresión, así como qué tipos de colas usará DirectStorage para la descompresión.