![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif) y si Volta nace sin competencia... igual son capaces de volver a subir los precios, lo cual sería malo para nosotros

y si Volta nace sin competencia... igual son capaces de volver a subir los precios, lo cual sería malo para nosotros

cercata escribió:Parece que va a ser como Polaris, peor de lo que nos habían vendido ... a ver si al menos ajustan los precios.

Motita escribió:cercata escribió:Parece que va a ser como Polaris, peor de lo que nos habían vendido ... a ver si al menos ajustan los precios.

Las Polaris solo son refritos con mejor consumo y temperaturas, no tiene nada que ver.

mmiiqquueell escribió:No se porque algo me dice que lo del nombre es como si dijeran que costaran un pastizal y como si no hubieras comprado nada, osea un timo. Los de AMD últimamente van muy a lo alto haciendo demostraciones y demás y luego cuando se pone a la venta y los usuarios hacen pruebas se demuestra que todo lo mostrado por AMD era falso, como que las 2 RX480 eran como una 1080 cuando en realidad rinden como una 1070, los Ryzen eran superiores a los de i7 de intel y al final el mejor Ryzen se queda a la altura de un i5 de hace varios años, como es el R7 1700 que rinde por igual que un i5 de hace 5 años.... Cuando presenten las vegas veréis que harán lo mismo, la gente dirá que chulada y demás y cuando se pongan a la venta y hagan benchmaks se llevaran una decepción. AMD antes hacia productos de calidad que superaban a intel, caso de gráficas era ATi que ganaba a Nvidia con algunas y yo compraba tanto AMD como ATi, al unirse estos 2 no se que paso que la calidad de los productos bajo... AMD, tu antes molabas.

mmiiqquueell escribió:No se porque algo me dice que lo del nombre es como si dijeran que costaran un pastizal y como si no hubieras comprado nada, osea un timo. Los de AMD últimamente van muy a lo alto haciendo demostraciones y demás y luego cuando se pone a la venta y los usuarios hacen pruebas se demuestra que todo lo mostrado por AMD era falso, como que las 2 RX480 eran como una 1080 cuando en realidad rinden como una 1070, los Ryzen eran superiores a los de i7 de intel y al final el mejor Ryzen se queda a la altura de un i5 de hace varios años, como es el R7 1700 que rinde por igual que un i5 de hace 5 años.... Cuando presenten las vegas veréis que harán lo mismo, la gente dirá que chulada y demás y cuando se pongan a la venta y hagan benchmaks se llevaran una decepción. AMD antes hacia productos de calidad que superaban a intel, caso de gráficas era ATi que ganaba a Nvidia con algunas y yo compraba tanto AMD como ATi, al unirse estos 2 no se que paso que la calidad de los productos bajo... AMD, tu antes molabas.

![muy furioso [+furioso]](/images/smilies/nuevos/furioso.gif)

Sarggent escribió:

Tio tu de que carajos estas hablando?? todo lo que estas diciendo es FALSO, los rysen en gamming están a la altura de los i5 de ultima generación y en trabajo(render, programas científicos, simulaciones) se COMEN a intel. un 1800X si mal no recuerdo le pasa por encima a un I7 6900k solo costando 500 dolares, cuando el 6900 es PEOR y cuesta 1000 dolares.

Por favor... no digamos sandeces...

![como la niña del exorcista [360º]](/images/smilies/nuevos/vueltas.gif)

leapfrog escribió:Sarggent escribió:

Tio tu de que carajos estas hablando?? todo lo que estas diciendo es FALSO, los rysen en gamming están a la altura de los i5 de ultima generación y en trabajo(render, programas científicos, simulaciones) se COMEN a intel. un 1800X si mal no recuerdo le pasa por encima a un I7 6900k solo costando 500 dolares, cuando el 6900 es PEOR y cuesta 1000 dolares.

Por favor... no digamos sandeces...

Hombre ... comer, comer ... lo que se dice comer ...![como la niña del exorcista [360º]](/images/smilies/nuevos/vueltas.gif)

Comparando un 1800X con un 7700K:

Aunque es cierto que cuando el software hace uso intensivo de multithreading:

Pero programas cientificos y software de simulacion, los que tu usas no se, los que yo uso tiran de GPU (CUDA -> Nvidia) para el procesado de los datos, no de CPU.

Y el precio (Amazon, visto ahora mismo):

1800X -> EUR 507,92

7700K -> EUR 362,00

Y ya si comparamos el 1800X con un 6900X en los mismos tests:

Multi-threaded performance

1577 Points (1800X)

973 Points (7700K)

1798 Points (6950X)

Pero es que un 6950X son casi 2000 lereles (No es peor, pero si unas 4 veces mas caro).

Vamos, que si tengo que montarme un equipo para simulacion te puedo decir que mi eleccion es un 7700K con una Tesla K80.

Esa es la configuracion de mi equipo en el curro ( Y este invierno me voy a ahorrar el calefactor de debajo de la mesa para calentarme.)

Filiprino escribió:No se que software de simulacion usaras, ni que tipo de simulacion, pero dudo mucho que sea eficiente si usa CUDA.

Menos del 10% de supercomputadores del Top 500 usa GPUs. El modelo más común es la K40, con 26 superordenadores. La tendencia es al alza, pero CUDA está muy verde para dar un rendimiento bueno sin un coste humano elevado, que es lo más caro de todo. Quizá con CUDA 9 cambien las cosas, pero teniendo en cuenta el enfoque a Machine Learning que está tomando, para cuestiones de bioinformática o física va a costar que tenga aceptación, con el obstáculo adicional de ser dependiente de software de código cerrado.

Esto es un poco como las suites de Adobe, que dicen soportar GPUs, multihilo y tal pero el hardware que hay que tirarles a la cara para que le saquen un mínimo de provecho da vergüenza ajena.

![enamorados [inlove]](/images/smilies/nuevos2/enamoraos.gif)

![enamorados [inlove]](/images/smilies/nuevos2/enamoraos.gif)

leapfrog escribió:Filiprino escribió:No se que software de simulacion usaras, ni que tipo de simulacion, pero dudo mucho que sea eficiente si usa CUDA.

Menos del 10% de supercomputadores del Top 500 usa GPUs. El modelo más común es la K40, con 26 superordenadores. La tendencia es al alza, pero CUDA está muy verde para dar un rendimiento bueno sin un coste humano elevado, que es lo más caro de todo. Quizá con CUDA 9 cambien las cosas, pero teniendo en cuenta el enfoque a Machine Learning que está tomando, para cuestiones de bioinformática o física va a costar que tenga aceptación, con el obstáculo adicional de ser dependiente de software de código cerrado.

Esto es un poco como las suites de Adobe, que dicen soportar GPUs, multihilo y tal pero el hardware que hay que tirarles a la cara para que le saquen un mínimo de provecho da vergüenza ajena.

El tercer equipo de la lista Top 500 (La ultima, 2016 nov), Titan (Un Cray XK7) consta de:

18.688 nodos de proceso, cada uno conr un Opteron serie 6200 Interlagos (16 Cores) y una Nvidia Tesla K20.

Si no existiesen esas dos monstruosidades llamadas Sunway TaihuLight y su hermano "pobre" Tianhe-2, seria el Superordenador mas potente de la lista (Y viendo las monstruosidades de los chinos me da que los dos primeros puestos van a tardar en cambiar).

Si lo comparamos con el siguiente de la lista que es el Sequoia, que efectivamente no usa GPUs sino procesadores diseñados por IBM exclusivamente para el, Titan practicamente con un tercio de nodos y casi el mismo consumo, consigue casi la misma capacidad de proceso (Sobre 17.000 Tflops).

Por lo que no comparto la opinion de que usar GPUs en supercomputacion sea una mala idea (Aunque si comparto lo de que a CUDA le faltan 5 minutos en el microondas).

Quien quiera construir un pequeño cluster para machacar datos va a acabar tirando de Teslas ...

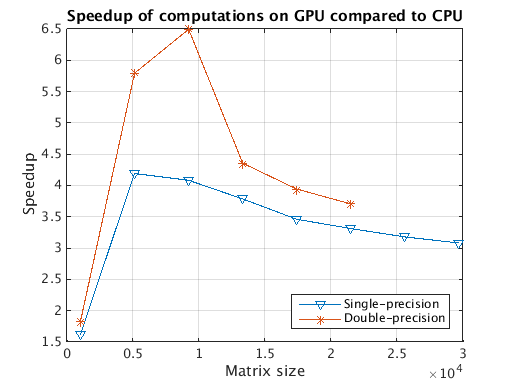

Pero mi comentario no iba de superordenadores, sino de una estacion de trabajo, y te aseguro que si a Matlab le quito la K80, me da algo (Y eso que el siguiente benchmark es "solo" con una K40)

Aunque dado mi profundo amor por PyCUDA igual estoy cegado![enamorados [inlove]](/images/smilies/nuevos2/enamoraos.gif)