Adjunto la noticia de EOL de NVIDIA sobre el acuerdo con GROQ

noticias/tecnologia/nvidia-groq-acuerdo-licenciaNvidia firma un acuerdo de licencia con Groq, una startup de chips para la inferencia de IA, por 20.000 millonesNvidia vuelve a sacar la cartera y en esta ocasión lo hace para firmar un acuerdo de licencia no exclusiva con la startup Groq. No ha trascendido el montante de la operación, pero según la CNBC se trata de una operación de 20.000 millones de dólares. Como parte de esta alianza Jonathan Ross, fundador y director ejecutivo de Groq, Sunny Madra, presidente de Groq, y otros miembros del equipo de Groq, se unirán a Nvidia para impulsar el desarrollo de la tecnología licenciada. Simon Edwards, director financiero de Groq, se queda al frente de la startup.

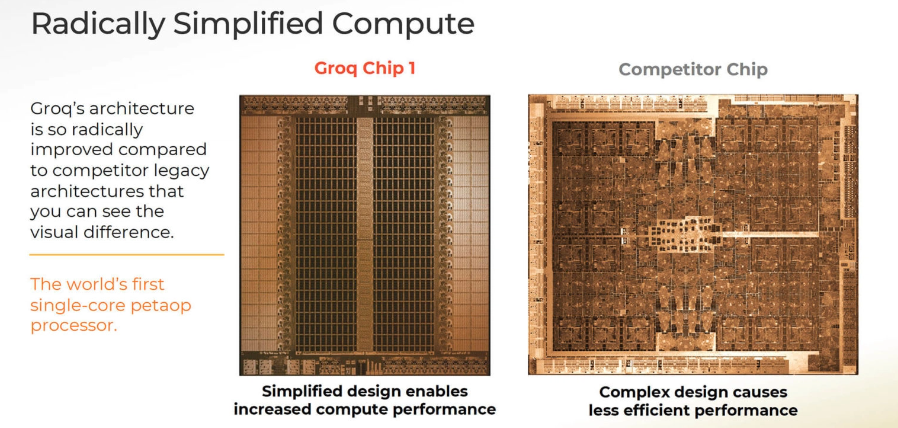

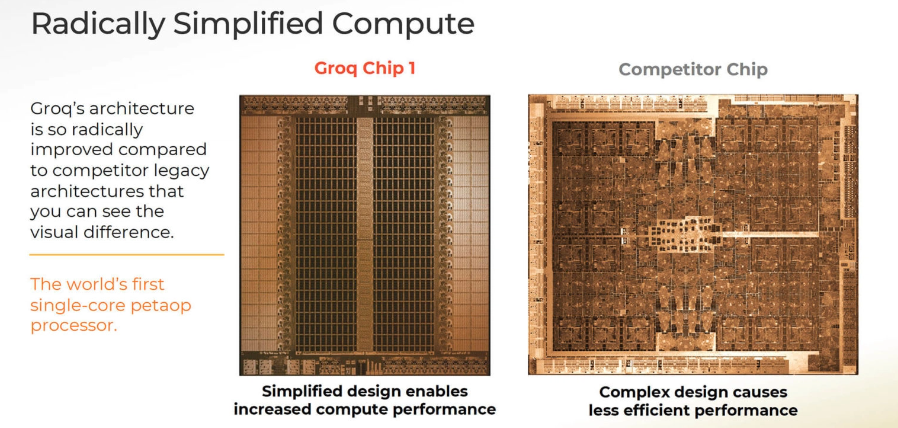

Las GPU de Nvidia son ampliamente conocidas por sus capacidades a la hora acelerar las tareas de aprendizaje automático y profundo, pero cuando se trata con un modelo de IA el entrenamiento no lo es todo. En el ciclo de vida de un modelo de IA también existe la inferencia, que es el proceso de aplicar todo lo aprendido para decidir, predecir o extraer conclusiones a partir de los datos. Para ejecutar esta parte del proceso de forma más rápida Groq ha estado trabajando en un chip diferente conocido como Unidad de Procesamiento de Lenguaje (LPU, por sus siglas en inglés), que puede ejecutar un modelo más rápido y con menor consumo.

En agosto de 2024, cuando Groq anunció el resultado de una ronda de financiación, dijo que su motor de inferencia LPU podría ejecutar modelos de IA generativa existentes a una velocidad diez veces superior y con un consumo de energía diez veces menor. Cuando mayor es la inferencia, más rápido responde el modelo y más natural es la comunicación.

"Planeamos integrar los procesadores de baja latencia de Groq en la arquitectura de IA de Nvidia, ampliando la plataforma para dar servicio a una gama aún más amplia de inferencias de IA y cargas de trabajo en tiempo real", ha dicho Jensen Huang, director ejecutivo de Nvidia, en una carta enviada a sus empleados. Huang también ha comentado que a pesar de que algunos empleados de Groq pasarán a formar parte de Nvidia y que han obtenido una licencia de la propiedad intelectual, "no hemos adquirido a Groq como compañía".

Los 20.000 millones de dólares que Nvidia pagará por la licencia de Groq no es una cifra oficial, pero tampoco ha sido desmentida por la compañía. Lo que no sabemos son los detalles del acuerdo. Nvidia no ha encontrado competidor con sus chips para acelerar tareas de aprendizaje, pero ahora que los modelos ya han escalado de forma generosa los ojos se han puesto en los chips de inferencia.

Groq es una compañía fundada en 2016 por un grupo de ingenieros liderados por Jonathan Ross, que durante su etapa en Google fue uno de los responsables de la unidad de procesamiento tensorial (TPU), un chip de aceleración de IA con un diseño personalizado que está optimizado para el entrenamiento y la inferencia de grandes modelos de IA. La TPU de Google puede ser un gran rival para Nvidia, así que esta se ha puesto las pilas.

Aquí un artículo de 2024 sobre Groq y sus chipshttps://www.xataka.com/robotica-e-ia/gr ... acen-volarGroq (no Grok) es el nuevo fenómeno de la IA, pero no hace LLMs: fabrica chips que los hacen volar

El pasado 9 de noviembre Jonathan Ross escribió un post en el blog de su empresa. Lo tituló "Bienvenido a la galaxia de Groq, Elon". Musk acababa de presentar su chatbot, Grok.

Resultó que ese nombre ya estaba cogido hacía tiempo —aunque con una "q" al final en lugar de una "k"— por parte de esta desconocida empresa que ahora se ha convertido en el nuevo fenómeno del mundo de la IA.

Groq no hace LLMs. No tiene un modelo que compita con GPT-4, con PaLM 2 o con Llama 2. Tampoco tiene un chatbot propio que compita con ChatGPT, Gemini o Copilot. No. Hace algo muy distinto, pero tan importante como eso... o puede que más.

Groq fabrica chips de inteligencia artificial. Los llaman Language Processing Units (LPUs), y con ellos logra algo espectacular: permite que la generación de texto de estos chatbots sea muchísimo más rápida que la que se obtiene con cualquier otro chip, incluidas las potentes GPUs de VIDIA.

Ross —que inició el proyecto en 2016 y que antes creó el primer Tensor Processig Unit en Google— demostró la capacidad de sus chips hace unos días en una entrevista en la CNN. En ella explicó cómo Groq hace que las conversaciones —de texto o habladas— con el chatbot resulten mucho más naturales y mucho más atractivas para quien interactúa con las máquinas.

Velocidad de vértigo = conversaciones naturalesLa clave está en la velocidad. Los humanos somos por lo general poco pacientes, y los chatbots tardan en respondernos porque para hacerlo necesitan tener acceso a una capacidad de cálculo enorme. Hasta ahora las GPUs de NVIDIA eran la mejor opción para obtener conversaciones más o menos fluidas, pero Groq deja a esas GPUs a la altura del betún.

Lo hemos comprobado haciendo una pequeña prueba que cualquiera puede replicar: basta con abrir dos ventanas, una con ChatGPT o cualquier otro chatbot en una parte de la pantalla y la demo de Groq en la otra parte. La velocidad de respuesta del chatbot de Mistral (pero se puede aplicar a cualquier otro) gracias a Groq es sencillamente espectacular.

Hay estudios independientes como el de Artificial Analysis que dejan clara la diferencia: no solo la velocidad es superior, sino que además Groq es más económico.

Así, Groq ofrecía una tasa de 246,79 tokens por segundo con el LLM Llama 2 con un coste de 0,72 dólares por cada millón de tokens. Usar ese mismo LLM en la infraestructura Microsoft Azure daba 18 tokens por segundo y un coste de 1,6 dólares.

Otros análisis confirman esas prestaciones. En el ranking de LLMPerf monitorizado por la empresa Anyscale, Groq es 18 veces más rápido en inferencia LLM que los principales proveedores de esta función en la nube.

Cómo logra Groq ser tan rápidoEstamos pues ante una prometedora revolución no en la precisión o calidad de las respuestas de estos modelos y sus chatbots, sino en la velocidad con la que nos responden. De repente mantener una conversación puede resultar mucho más natural, y esto plantea implicaciones importantes en ese uso práctico de esta tecnología.

¿Cómo logran los chips de Groq algo así? Ross lo explicaba en esa entrevista de la CNN con una analogía sencilla.

"La mayoría de los chips de IA no tienen demasiada memoria disponible. Es como cuando fabricas coches: necesitas grandes fábricas y un millón de pies cuadrados en líneas de ensamblaje. Si no tienes ese tipo de edificio, necesitas dividir las líneas de ensamblaje una y otra vez para que ocupen menos. Eso es lento y lleva mucho tiempo, y eso es lo que pasa con la GPU: tienes que leer de la memoria miles de veces por cada palabra que se genera, como si tuvieras que configurar la línea de ensamblaje una y otra vez [para sacar la pieza necesaria del coche]".

Aunque los responsables de Groq lógicamente no quieren dar muchos detalles sobre cómo funcionan sus chips, sí que explican en el sitio web oficial de la compañía que "la LPU está diseñada para superar los dos cuellos de botella de los LLM: la densidad de cálculo y el ancho de banda de la memoria". La empresa, eso sí, enlaza a estudios premiados de 2020 en los que ya hablaba de procesadores especializados para acelerar tareas de aprendizaje profundo.

Ross explicó que estos chips no están disponibles para usuarios finales, así que no esperéis poder comprar algún tipo de tarjeta PCIe para añadirla a vuestro PC. Al menos, no de momento: la empresa trabaja con compañías que pueden beneficiarse de esta potencia de cálculo en sus centros de datos para luego ofrecer esa velocidad de generación de texto en sus servicios en la nube.

Es de esperar que poco a poco veamos este tipo de solución implantada en chatbots públicamente accesibles —y seguramente, de pago—, pero lo interesante es que esto abre la puerta a que efectivamente este tipo de mejora haga que las GPUs de NVIDIA (o AMD, que avanza en este campo) cuenten con al menos una alternativa totalmente especializada en este ámbito. Y si ha aparecido una, lo lógico es pensar que acabarán apareciendo más y quizás lo hagan con propuestas destinadas a los consumidores.