PSX22 escribió:claro, os habeis liado con precios cuando amd no vende tras lanzarla, de lanzamiento no salio a 540€ ni de blas, es lo que pasa que salen parecidas de precio , pero a los 2 meses, las bajan 100 o 200€, señal de que no les ve valor la gente. Nvidia no baja porque vende sin parar y esto es porque cumplen lo que venden

PSX22 escribió:Una 7800 vale como 50euros menos que la 4070 que es menos potente y la nvidia la destroza en rtx en cyberpunk, como va a pagar la gente mas de 500€ y no poder tener RT decente? el DLSS se paga y vale mucho la pena, el FSR no lo activo ni con la fuente del vecino

PSX22 escribió:claro, os habeis liado con precios cuando amd no vende tras lanzarla, de lanzamiento no salio a 540€ ni de blas, es lo que pasa que salen parecidas de precio , pero a los 2 meses, las bajan 100 o 200€, señal de que no les ve valor la gente. Nvidia no baja porque vende sin parar y esto es porque cumplen lo que venden

Nomada_Firefox escribió:PSX22 escribió:Una 7800 vale como 50euros menos que la 4070 que es menos potente y la nvidia la destroza en rtx en cyberpunk, como va a pagar la gente mas de 500€ y no poder tener RT decente? el DLSS se paga y vale mucho la pena, el FSR no lo activo ni con la fuente del vecino

Sí es cierto. Luego vendra alguien con el RT no vale para nada. Pero todos se fijan en el y lo quieren usar......

Pero Nvidia vende caro porque compramos sus graficas. Sino no las venderia más baratas, eso seguro.

AMD nunca va a dar lo mismo por menos. Eso esta más que comprobado. Paso con las CPUs y si pudieran, pasaria con las GPUs.

Por otro lado, respondiendo a la realidad de cuando lanzo las 7000, no eran tan baratas. Fueron perdiendo fuelle cuando fueron saliendo titulos en donde ya no eran tan buenas. En cierto modo, lo mismo le paso a la 4070 basica. Era mucho más cara, pero perdio fuelle cuando los requisitos subieron, por eso ahora es una grafica de gama media y lo que deberia ser la gama media, las 4060, no alcanzan para jugar excelentemente a esos 4 titulos. Y tambien bajaron de precio.

Luego que para unos u otros sirvan, es otra historia. Hay mucha gente que no juega a lo ultimo. Hay mucha gente que no le tienen porque gustar todos los juegos que salen. Para gustos colores. Yo no me considero jugador de lo ultimo, lo he dicho muchas veces, de hecho me parece que salen muchos juegos que simplemente no me gustan, otros si. Nada anormal.

@darkitu No es por defender a PSX22 ¿pero cuando salio la GRE? nisiquiera estuvo a la venta en PCC el dia que tu crees que fue su lanzamiento porque ya la tenian desde poco déspues de que salio en China y en ese momento, rondaba lo más barato del unico modelo que habia, fueron 599. Y ahora esta muchisimo más cara.

¿Y cuanto tiempo déspues de anunciar las 7000? bastante más de un año.........asi que bueno, el razonamiento de AMD vendio barato desde el primer dia.........no tiene logica alguna ni realidad con las 7000, un modelo años déspues......

darkitu escribió:PSX22 escribió:claro, os habeis liado con precios cuando amd no vende tras lanzarla, de lanzamiento no salio a 540€ ni de blas, es lo que pasa que salen parecidas de precio , pero a los 2 meses, las bajan 100 o 200€, señal de que no les ve valor la gente. Nvidia no baja porque vende sin parar y esto es porque cumplen lo que venden

No das una… la GRE el día de lanzamiento estaba por 550 ya.

Para una gráfica que tiene un buen precio de salida…

PSX22 escribió:darkitu escribió:PSX22 escribió:claro, os habeis liado con precios cuando amd no vende tras lanzarla, de lanzamiento no salio a 540€ ni de blas, es lo que pasa que salen parecidas de precio , pero a los 2 meses, las bajan 100 o 200€, señal de que no les ve valor la gente. Nvidia no baja porque vende sin parar y esto es porque cumplen lo que venden

No das una… la GRE el día de lanzamiento estaba por 550 ya.

Para una gráfica que tiene un buen precio de salida…

venga tu puedes, 549 USD+ tax es el MSRP mundial anunciado de salida, quieres hacer como que sabes, pero no.

que ya cansa tu cantinela de invents

https://elchapuzasinformatico.com/2024/ ... to-global/

PSX22 escribió:darkitu escribió:PSX22 escribió:claro, os habeis liado con precios cuando amd no vende tras lanzarla, de lanzamiento no salio a 540€ ni de blas, es lo que pasa que salen parecidas de precio , pero a los 2 meses, las bajan 100 o 200€, señal de que no les ve valor la gente. Nvidia no baja porque vende sin parar y esto es porque cumplen lo que venden

No das una… la GRE el día de lanzamiento estaba por 550 ya.

Para una gráfica que tiene un buen precio de salida…

venga tu puedes, 549 USD+ tax es el MSRP mundial anunciado de salida, quieres hacer como que sabes, pero no.

que ya cansa tu cantinela de invents

https://elchapuzasinformatico.com/2024/ ... to-global/

Pacorrr escribió:Ah bueno, que sólo vale PCC para comprar, pues vale allá tú con tu mecanismo, tengo una Nvidia actualmente pero no me ciego

Aquí tenéis la prueba de que se pudo comprar una 7900 GRE a 567€ el día del lanzamiento oficial en Europa

https://foro.noticias3d.com/vbulletin/s ... ost5983525

No es bueno cegarse con ninguna marca, ellos sólo miran su beneficio, hay que ser más pragmático.

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

No es bueno cegarse con ninguna marca, ellos sólo miran su beneficio, hay que ser más pragmático.

Pacorrr escribió:Ah bueno, que sólo vale PCC para comprar, pues vale allá tú con tu mecanismo, tengo una Nvidia actualmente pero no me ciego

Gnoblis escribió:Pues yo estoy muy contento con mi RX 6700 XT de AMD pero no voy a comprar nueva tarjeta todos los años ni cada vez que sale nueva serie.

Me gusta el cacharreo pero no tengo tanto presupuesto si el salto de rendimiento no es tan grande.

MrKafka escribió:Si fuera amazon al menos con su garantía, pero pcc que va cada vez a peor, tenerlo de referencia, no es buena idea.

654321 escribió:MrKafka escribió:Si fuera amazon al menos con su garantía, pero pcc que va cada vez a peor, tenerlo de referencia, no es buena idea.

Pues amazon no veas, a mi me hicieron la del trilero para intentar cobrarme un reemplazo de una 3080

Nomada_Firefox escribió:Lo he dicho más de una vez, ninguna tienda va a dejarse palmar dinero y cuando eso sucede, lo normal, son problemas. Da igual que sea Amazon que cualquier otra.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

654321 escribió:MrKafka escribió:Si fuera amazon al menos con su garantía, pero pcc que va cada vez a peor, tenerlo de referencia, no es buena idea.

Pues amazon no veas, a mi me hicieron la del trilero para intentar cobrarme un reemplazo de una 3080

Nomada_Firefox escribió:654321 escribió:MrKafka escribió:Si fuera amazon al menos con su garantía, pero pcc que va cada vez a peor, tenerlo de referencia, no es buena idea.

Pues amazon no veas, a mi me hicieron la del trilero para intentar cobrarme un reemplazo de una 3080

Lo he dicho más de una vez, ninguna tienda va a dejarse palmar dinero y cuando eso sucede, lo normal, son problemas. Da igual que sea Amazon que cualquier otra.

PSX22 escribió:asumelo AMD pagas mas de salida, no tienes DLSS, no hay RT decente, no hay FG decente, consumen mas, y tienen peor estabilidad de drivers.

Hay alguna mentira ? no creo

lo que es verdad es que bajan mucho de precio y por ahi rascan algo de ventas.

Cyborg_Ninja escribió:PSX22 escribió:asumelo AMD pagas mas de salida, no tienes DLSS, no hay RT decente, no hay FG decente, consumen mas, y tienen peor estabilidad de drivers.

Hay alguna mentira ? no creo

lo que es verdad es que bajan mucho de precio y por ahi rascan algo de ventas.

Hombre, mentira lo que es mentira quizás no, pero un poco de verdades a medias sí.

"No tienes el DLSS", no, pero lo cierto es que la mayoría de juegos tienen escalados también muy buenos, como el del Unreal Engine (TSR), Intel XeSS y el propio FSR 2 ha dado buenos resultados en general. Especialmente el del UE es casi mejor que el DLSS en algunos juegos.

"No hay RT decente", vamos a ver, que con este tema se exagera mucho; el problema es que en AMD hay más penalización de rendimiento, pero salvo en un par de juegos la mayoría se pueden jugar con RT perfectamente. RT decente sí hay, pero va a penalizar más, y una 7800xt por ejemplo que es superior a una 4070 de golpe se convertiría en una 4060 si activas el RT, pero es viable.

"Consumen más", esta generación (las 7000) es correcto.

"Tiene peor estabilidad de drivers", eso no lo tengo tan claro.

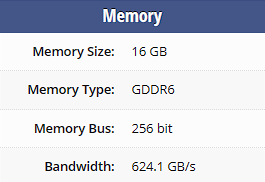

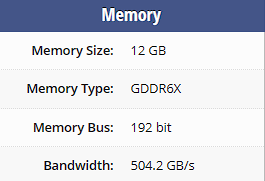

Ahora también te digo que te dejas cosas no menos importantes: más VRAM con similares o inferiores precios y con GPUs más potentes en raster en cuanto a calidad-precio. Y ya hemos visto más de una 3070 frente a su equivalente en AMD (6700XT) se ha llevado el susto por tener 8GB de VRAM, eventualmente eso les pasará a una 4070 Super contra una 7800XT que encima es más barata.

No digo que no tengas parte de razón, pero la historia es mejor al completo.

[Alex] escribió:Ojalá GPUs para los que nos importa 0 trabajar con ellas.

En la vida he editado un vídeo, grabado contenido, etc.

Solo quiero jugar.

![loco [looco]](/images/smilies/nuevos2/borracho.gif)

PSX22 escribió:Yo no trabajo con la RTX, pero si he renderizado un video en NVENC y es una pasada lo rapido que va, y los streamers elogen todos Nvidia por el AV1 codec

El Ray Tracing penaliza menos en Nvidia pero sigue siendo una burrada lo que penaliza

Yo tengo una Nvidia y paso muchísimo del DLSS, si puedo claro, que hay juegos que no tienes más remedio que usarlo porque te va a 30-40 fps como el Alan Wake por ejemplo

PSX22 escribió:@Cyborg_Ninja

la historia es tal cual he dicho y encima he dejado algo importante, las texturas en nvidia se ven mucho mejor. Es una ventaja de hecho, consumen menos VRAM y se ve mejor.

DLSS vs resto ( siempre cogerias DLSS)

RTX vs RT siempre RTX porque penaliza menos, nunca he dicho que se vea peor, sino que es peor su RT.

Pero que no lo digo yo, lo dice la gente con su bolsillo, irse a steam y mirar que % hay de nvidia vs AMD, y canta solo, encima amd es mas barato, a igual precio nvidia venderia 99 de cada 100

Yo no trabajo con la RTX, pero si he renderizado un video en NVENC y es una pasada lo rapido que va, y los streamers elogen todos Nvidia por el AV1 codec

En redes neurales AMD no existe, en after effects....

Porque ensambladoras no quieren montar casi AMD? porque AMD esta pensando en no sacar gama alta este año??

son manias? o que esta fuera del mercado practicamente?

PSX22 escribió:@Cyborg_Ninja

la historia es tal cual he dicho y encima he dejado algo importante, las texturas en nvidia se ven mucho mejor. Es una ventaja de hecho, consumen menos VRAM y se ve mejor.

RTX vs RT siempre RTX porque penaliza menos, nunca he dicho que se vea peor, sino que es peor su RT.

Pacorrr escribió:[Alex] escribió:Ojalá GPUs para los que nos importa 0 trabajar con ellas.

En la vida he editado un vídeo, grabado contenido, etc.

Solo quiero jugar.

Eso digo yo, ahora resulta que todo el mundo usa las gpus para "trabajar"

Yo siempre las he usado para jugar

Se están diciendo muchas burradas, las texturas no se ven mejor en una u otra, se ven exactamente igual

Nvidia tiene un poco mejor compresión y hace que ocupe un poco menos en la VRAM

es que Cuda está muy arraigado en el software profesional

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

AxelStone escribió:En primer lugar AMD debería poner más esfuerzo en limar drivers, de otro modo nunca estará a la altura por muy bueno que sea el hardware que vende.

PSX22 escribió:@Cyborg_Ninja

Informate mejor por favor

No son las mismas texturas ni ocupan lo mismo ni el consumo es el mismo, ya solo obviar el uso de cache L2 deja claro que tienes que revisar datos

No se usa la vram de igual ni rinde igual ni se requiere la misma cantidad, con afterburner de ve en cualquier video, lo mas grave es calidad de texturas y no me refiero al setting del juego que ahi logicamente ambas estarian en ultra

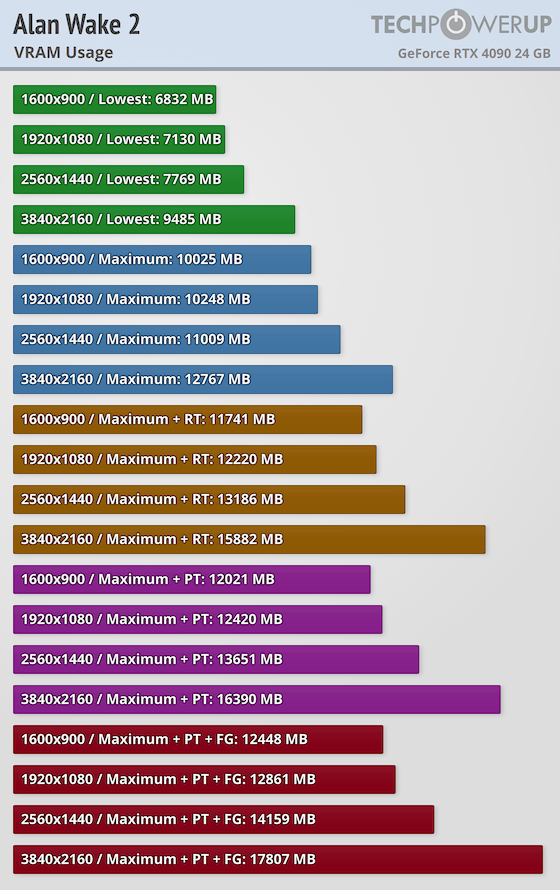

Next up, let's talk about graphics cards with 8GB of VRAM - a setup that hobbled many recent PS5 to PC ports on launch. At 1440p, both the RTX 2070 Super and RTX 3070 had no issues with frame-rate drops due to VRAM running out. I also tried bumping up the resolution to 1800p with the RTX 3070 and found that after a cutscene, during a cutscene, or after fast traveling, I could see big frame-rate drops and swings as VRAM was overfilled and the game started paging to system memory.

PSX22 escribió:@Cyborg_Ninja

informacion tienes, pero saberla interpretar tengo mis dudas , veo bastantes incongruencias en tus planteamientos

en PC se aspira a mas que en consola, por tanto los modos 30 y 60 quedan por debajo de nuestro objetivo, por tanto compremos la 4060 70 80 o 90,nuestro objetivo es jugar a mas de 60, que ocurre? que nvidia ya ha calculado esto

Una GPU de 8 es para 1080, una de 12 es para 1440 y una de 16 o mas es para 4K ( siempre hablando de juegos modernos exigentes).

que pasa que tienes que subir a 1800p la 3070 para tener falta de ram con 8gb, claro, porque estas jugando en malas condiciones, si mi 4070 la pongo a 4K y se muere, hay que usar DLSS 4K ( que es un 1440p que parece 4K si) pero consume VRAM como 1440p. Mucho menos vas a jugar a 1800p a nada moderno con una 3070, porque todo lo que sea bajar de 70-80 fps, automaticamente tengo que bajar graficos o resolucion, porque para jugar peor que en ps5, me voy a ps5.

la VRAM sirve.. para vender y ya esta

Por otro lado hay fallos graves en las tablas de interpretacion, pues mirar con la 4090 la VRAM en 4K no indica el uso real en una 4070 de vram

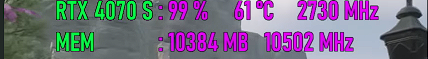

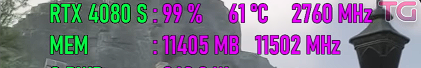

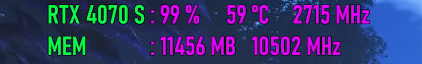

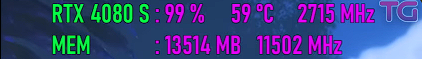

Aquí mismo puedes comprobar que el uso de la vram de la 4070S (12gb) y el de la 7800XT es aproximadamente el mismo en todos los juegos, las discrepancias suelen ser porque cuando tienes más VRAM algunos juegos utilizan más cantidad

Las texturas ni ocupan igual ni se ven igual en nvidia esto te lo dejo a ti para informarse.

AMD te da mas memoria, porque usa mas memoria y ademas se ve peor la textura, es memoria mas lenta y peor ancho de banda por tanto, con lo que es ir en autobus a supermercado, puedes ir.. si. pero no es lo suyo.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

A corto plazo puede que no se note, pero si quieres mantener la GPU muchos años, seguramente te pase factura si no venia bien sobrada de VRAM

Mayban36 escribió:Igual tenemos que recordar como ha envejecido la R9 390 de 8GB frente a la 970 de 3,5GB

PSX22 escribió:Mayban36 escribió:Igual tenemos que recordar como ha envejecido la R9 390 de 8GB frente a la 970 de 3,5GB

Pues igual de mal si te pones avatar y tienes pantalla 4K xd

En caso de jugar en CRT de 14 y a 720p con FSR entonces si, los 8GB han envejecido mejor jajaj

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)