Genie de Google DeepMind crea juegos tipo Super Mario a partir de imágenes https://aibusiness.com/nlp/google-deepm ... lose-modal

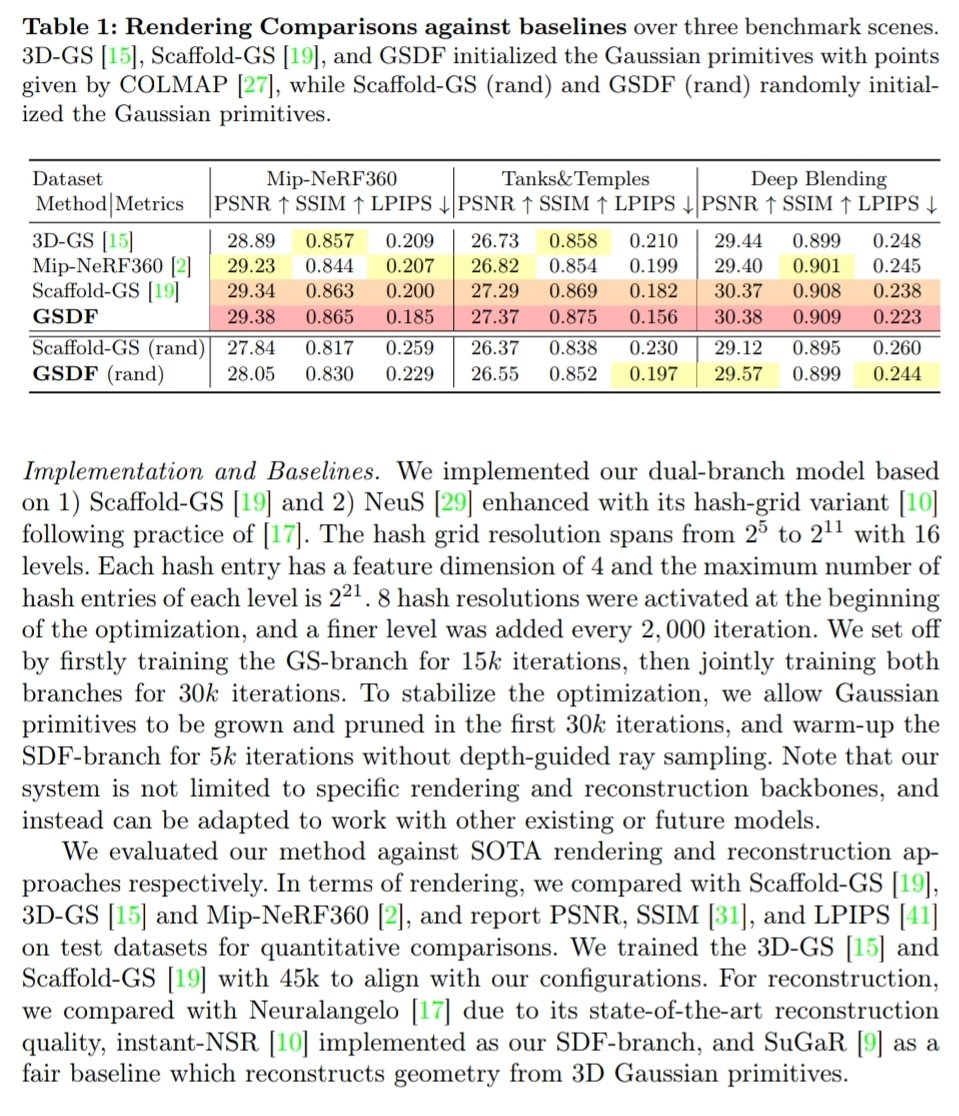

Genie transforma imágenes en juegos interactivos tipo Super Mario.

.jpg?width=850&auto=webp&quality=95&format=jpg&disable=upscale)

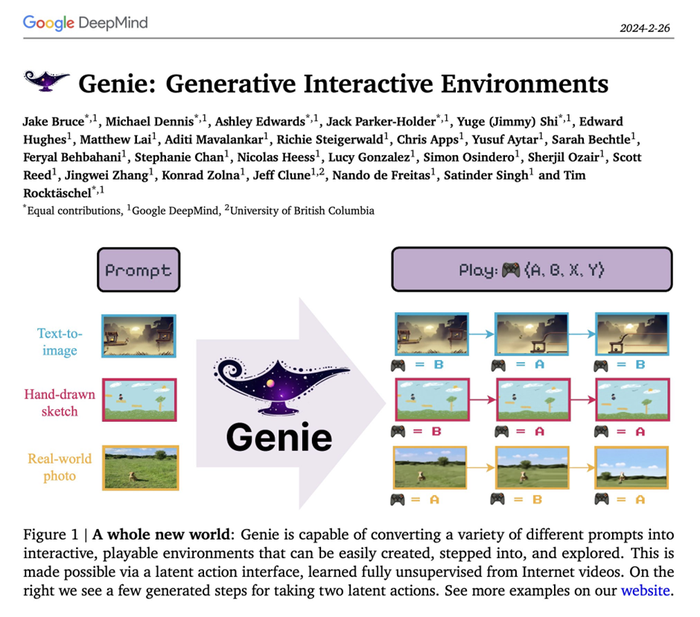

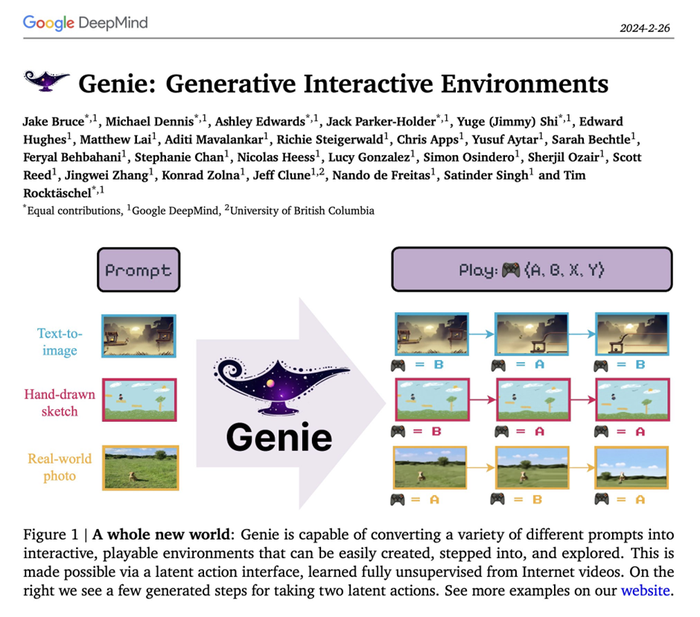

DeepMind se hizo un nombre en el espacio de la IA mediante el uso de videojuegos para evaluar sus ideas algorítmicas. Unos 14 años después y una adquisición por parte de Google , los juegos siguen estando en el centro de su investigación, con su nuevo modelo Genie que permite a los usuarios convertir imágenes en escenas de videojuegos.

Genie (abreviatura de Generative Interactive Environments) se formó con vídeos de Internet, pero puede crear escenas reproducibles a partir de imágenes, vídeos e incluso bocetos que no ha visto antes.

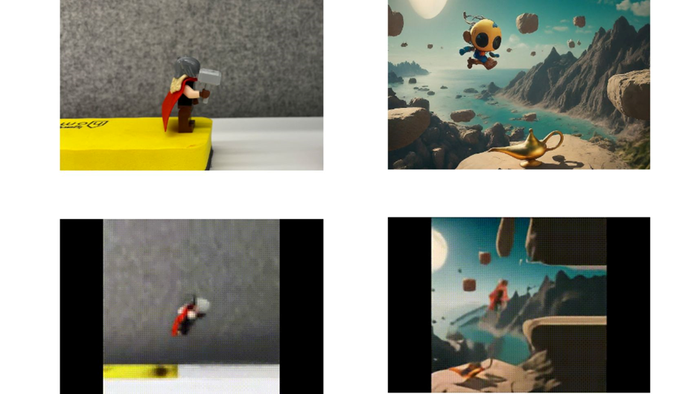

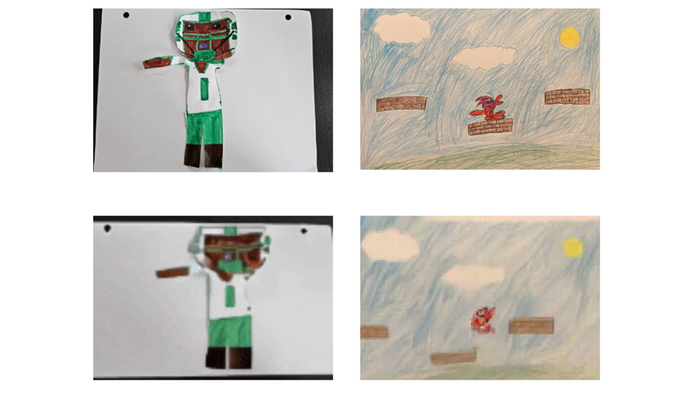

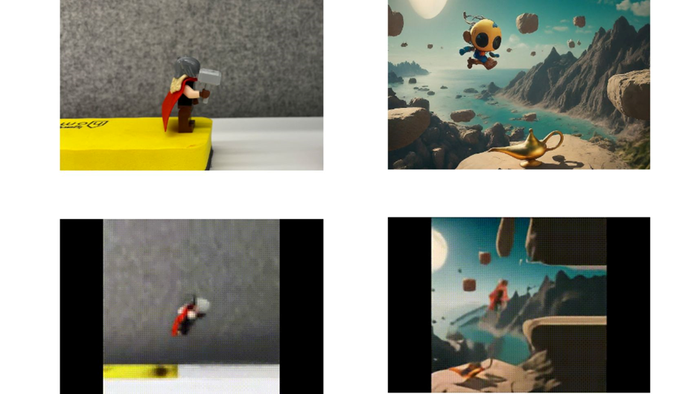

Los usuarios pueden ingresar fotografías del mundo real de, por ejemplo, una escultura de arcilla, y Genie puede generar una representación 2D al estilo de un juego de plataformas 2D (piense en Super Mario Bros. en Nintendo). El modelo puede construir estos entornos de juego a partir de una sola imagen.

Puede parecer una idea divertida para un modelo de IA, pero Google DeepMind cree que este modelo generativo tiene implicaciones para los agentes generalistas: sistemas de IA diseñados para manejar una variedad de tareas de IA.

La idea es que Genie sea un método general: aprender acciones latentes a partir de cosas como vídeos que pueden transferirse a entornos diseñados por humanos. El método podría aplicarse a otros dominios sin requerir ningún conocimiento adicional del dominio.

Google DeepMind tomó Genie y lo aplicó a diferentes escenarios entrenándolo en videos en los que no se realizaban acciones específicas. El modelo pudo comprender esas acciones y aprender de nuevos entornos sin necesidad de instrucciones adicionales.

El equipo detrás de Genie dijo que el proyecto era “sólo rascando la superficie de lo que podría ser posible en el futuro”.

Genie alimentó a la fuerza 200.000 horas de vídeos de Internet de juegos de plataformas 2D como Super Mario y datos robóticos (RT-1). A pesar de que los videos de Internet a menudo no están etiquetados, aprendió controles detallados, incluidas qué partes de la entrada son controlables, pero también infiere diversas acciones latentes que son consistentes en todos los entornos generados.

El modelo aprende de haber visto miles de videos en Internet, comprender acciones como saltar y aplicarlas a un entorno similar a un juego. Muéstrele a Genie una imagen de un personaje cerca de una repisa, por ejemplo, y el modelo inferirá que ese personaje saltará y generará una escena basada en esa acción

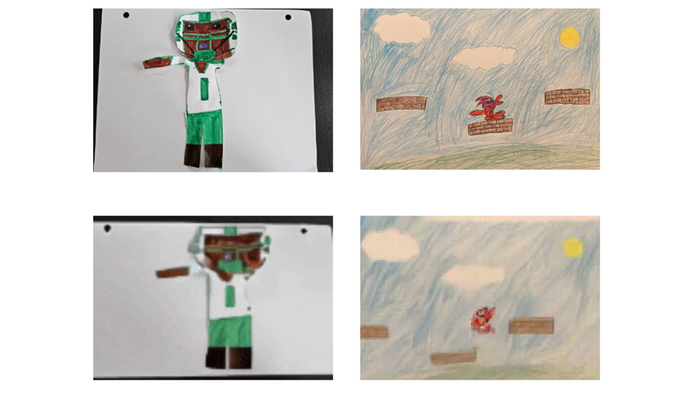

Es como cómo los humanos aprendemos de los videos: miramos y eventualmente captamos cosas. Genie hace lo mismo e incluso puede darle sentido a bocetos dibujados por humanos y convertirlos en representaciones similares a juegos.

Genie tiene un tamaño de 11 mil millones de parámetros, y Google DeepMind lo llama un "modelo mundial fundamental": un modelo mundial es un sistema que aprende de cómo funciona el mundo. Para obtener una explicación detallada, lea la definición de X del científico jefe de IA de Meta, Yann LeCun.

https://sites.google.com/view/genie-2024/home

![Ok! [oki]](/images/smilies/net_thumbsup.gif)

![Ok! [oki]](/images/smilies/net_thumbsup.gif)

.jpg?width=850&auto=webp&quality=95&format=jpg&disable=upscale)