![Babeando [babas]](/images/smilies/babas.gif) .

.![adios [bye]](/images/smilies/nuevos2/adio.gif)

DD

DD500€ para la 380...

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

Como te puede gustar nvidia? sacrílego! jejejee

![Adorando [tadoramo]](/images/smilies/adora.gif)

![Lee! [rtfm]](/images/smilies/rtfm.gif)

,yo creo que este año las Nvidia van a tener Nvidia

,yo creo que este año las Nvidia van a tener Nvidia  DDDDD

DDDDD anikilador_imperial escribió:Yo no diria falsos,pero bastante exagerados si,yo creo que este año las Nvidia van a tener Nvidia

DDDDD

![por aquí! [poraki]](/images/smilies/nuevos/dedos.gif)

Marcos1 escribió:Esos resultados son falsos, vamos, es que no hay por donde cojerlos, se ve a la legua.

Pero como va a ser la 360gtx superior a la Dual de ATI, es total y completa fisicamente imposible, vamos, eso es más falso que un billete de 3 euros.

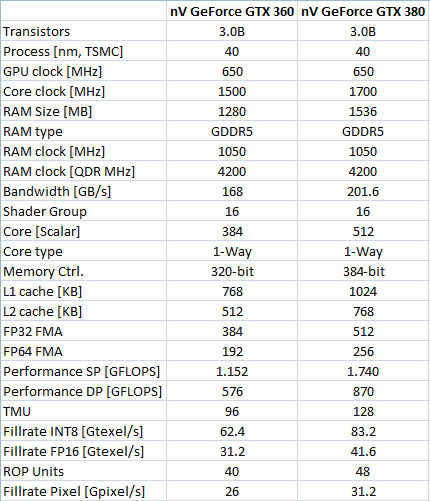

Repito, es totalmente imposible, en el mejor de los casos la 360gtx competira con la 5870, y la 380gtx estara a medio camino entre la 5870 y la 5970.

LordArthas escribió:de entrada voy a decir que no me lo creo... ya vi unas gráficas bastante similares (estéticamente idénticas) en las que decía que la GTX280 movería el Crysis Very High DX10 a 70fps y luego nada de nada... así que a seguir esperando por lo menos mes y medio hasta que nvidia saque algo oficial (en teoría presentación en el CES, salida en papel a finales de enero, diponibilidad limitada en febrero y disponibilidad real en marzo/abril)...Marcos1 escribió:Esos resultados son falsos, vamos, es que no hay por donde cojerlos, se ve a la legua.

Pero como va a ser la 360gtx superior a la Dual de ATI, es total y completa fisicamente imposible, vamos, eso es más falso que un billete de 3 euros.

Repito, es totalmente imposible, en el mejor de los casos la 360gtx competira con la 5870, y la 380gtx estara a medio camino entre la 5870 y la 5970.

me hacen gracia este tipo de comentarios... ¿en qué te basas para afirmar esto tan categóricamente? ¿información privilegiada?... lo que afirmas tiene que ver más con la lógica que con la razón absoluta porque no hay nada oficial sobre Fermi en rendimiento bruto en juegos...

¿y si por lo que sea estas gráficas son reales?... pongamos una hipótesis... si la arquitectura GT200 (que no es más que una G80 atiborrada de esteroides) se pule con cierto margen a la RV770... si la memoria GDDR5 es la gran arma de las ATI de gama alta... si nvidia siempre que se ha dado el batacazo (GeForce FX, GeForce 7), a la siguiente se ha sacado de la manga una bestia parda (GeForce 6, GeForce 8)... ¿no sería plausible que Fermi fuese una bomba que se comiera con patatas a Evergreen?...

no sé, son hipótesis, pero yo creo que con algo tangible en ellas y nada descabelladas... afirmar con tanta vehemencia algo sin datos plausibles me parece muy aventurado...

Marcos1 escribió:información privilegiada, no, sentido común.

djohny24 escribió:Si realmente para abril es cuando van a tenerla bien puesta a la venta, llega bastante tarde porque para entonces ati va a tener preparada la hornada 6XXX o una versión reducida, porque dan el salto a 28nm si mal no recuerdo

LordArthas escribió:Marcos1 escribió:información privilegiada, no, sentido común.

ya, el sentido común dice eso y yo tb creo que es lo más probable... pero, ¿qué decía el sentido común en Junio del año pasado?... ¿no puede ser que la GTX360 barra a la HD5870? ¿o que la HD5870 barra a la GTX360?... sin datos fidedignos sobre la mesa sólo puedes hacer cojenturas, no dictar leyes...

umm... edito, que no lo había visto...djohny24 escribió:Si realmente para abril es cuando van a tenerla bien puesta a la venta, llega bastante tarde porque para entonces ati va a tener preparada la hornada 6XXX o una versión reducida, porque dan el salto a 28nm si mal no recuerdo

si TSMC no produce bien a 40nm, o bien ATI tira de Gobal Foundries (que creo ya tiene el proceso a 28nm ultimado, aunque no probado en masa... cosa que no creo que pase porque AMD no va a producir Bulldozer hasta 2011 en 32nm) o bien TSMC obra el milagro...

LordArthas escribió:pues a mi me parece lo contrarío, que ATI se ha lanzado muy pronto a la arena con toda la mierda el hype del W7, DX11 y demás... sinceramente me parece vergonzoso que una serie con DOS MESES en el mercado no tenga drivers optimizados para ella, de hecho hay varios modelos que no tienen soporte oficial... que una 5970 costando un 60-80% más, apenas rinda un 30-40% más que la HD5870... que una HD5850 con OC (y no mucho, símplemente a las mismas frecuencias) rinda lo mismo que una HD5870 costando 100€ menos... que un CFX de HD5770 rindan tanto o más como una HD5970 ¿WTF?!!!!...

NO estoy defendiendo a nvidia ojo, que ellos tb tienen lo suyo... primero por no ver que ATI podría tener algo en el mercado tan pronto habiendo gastado ellos poco o nada en I+D (GT200 y G80/G92 son lo mismo a nivel arquitectónico)... y segundo por no tener listo a tiempo un chip que pueda hacer frente a ATI, puesto que se especula con que el Fermi A2 es perfectamente funcional pero que no pasa de 500MHz por lo que el rendimiento es un chiste y por eso se ha pasado al A3 para la producción en masa...

KBM escribió:LordArthas escribió:pues a mi me parece lo contrarío, que ATI se ha lanzado muy pronto a la arena con toda la mierda el hype del W7, DX11 y demás... sinceramente me parece vergonzoso que una serie con DOS MESES en el mercado no tenga drivers optimizados para ella, de hecho hay varios modelos que no tienen soporte oficial... que una 5970 costando un 60-80% más, apenas rinda un 30-40% más que la HD5870... que una HD5850 con OC (y no mucho, símplemente a las mismas frecuencias) rinda lo mismo que una HD5870 costando 100€ menos... que un CFX de HD5770 rindan tanto o más como una HD5970 ¿WTF?!!!!...

NO estoy defendiendo a nvidia ojo, que ellos tb tienen lo suyo... primero por no ver que ATI podría tener algo en el mercado tan pronto habiendo gastado ellos poco o nada en I+D (GT200 y G80/G92 son lo mismo a nivel arquitectónico)... y segundo por no tener listo a tiempo un chip que pueda hacer frente a ATI, puesto que se especula con que el Fermi A2 es perfectamente funcional pero que no pasa de 500MHz por lo que el rendimiento es un chiste y por eso se ha pasado al A3 para la producción en masa...

Segun esto un cfx de 4890 se pulen la 5970?

djohny24 escribió:Mas que drivers, juegos, quiero decir DX11

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Crazy Hattori escribió:djohny24 escribió:Mas que drivers, juegos, quiero decir DX11

Estas 2 semanas que no he estado posteando he estado probando una HD5970 y una HD5870 y comparandolas con mi GTX295. Y definitivamente... me quedo con la nVidia. Me ha demostrado que siempre se ponen las pilas sacando drivers decentes.

...

...Crazy Hattori escribió:djohny24 escribió:Mas que drivers, juegos, quiero decir DX11

Que?? lol, si mismamente en el DIRT 2 a 1200p se ve que la HD5770 va justa justa (sobre 30-35 Frames). Una HD5850 no llega ni a 60 Frames. Y eso que el juego no esta completamente programado en DX11, solo han metido un par de detalles chorras. En el Stalker mas de lo mismo.

No me quiero ni imaginar cuando saquen el Bad Company 2 o el AVsP2 que se supone que estan hechos en DX11.

La gente se compra una HD5750 o HD5770 antes que una GTX260 o incluso una GTX275 pensando en el DX11, cuando realmente esas tarjetas dentro de 6 meses cuando se quiera jugar a 1200p en juegos que tengan el DX11 implementado no van a poder moverlo con fluidez. Total, que se quedaran en unas graficas para usarse en DX9, y si no, tiempo al tiempo, ya vereis.

Mas les vale sacar drivers pero ya, porque actualmente son una basura pero de las gordas, no tienen verguenza.

Meten la baza de los nuevos super efectos de DX11 para que? si luego solo puedes jugar con 2 o 3 de las "super" graficas de nueva generacion. Y anda que la 5970... vaya tela.... entre los fallos de imagen en 2 o 3 juegos, que si funcima un solo core, que si esperamos a ver si sacan algun parche para que funcione "algo mejor"...

Triste, muy triste...

Total, que solo vale la pena pillarse una HD5850 y hacerle algo de OC para jugar de momento y rezar para que optimicen drivers.

Estas 2 semanas que no he estado posteando he estado probando una HD5970 y una HD5870 y comparandolas con mi GTX295. Y definitivamente... me quedo con la nVidia. Me ha demostrado que siempre se ponen las pilas sacando drivers decentes.

Con respecto a esos bench de Fermi.... tienen pinta de fake, pero no me estrañaria en absoluto que con unos buenos drivers de nVidia, se sacaran esas diferencias dentro de 6 o 10 meses cuando Fermi ya este mas rodado. Solo hay que fijarse en las GTX260. Al poco de salir rendian similar o algo por debajo que una HD4850, pero ahora incluso se mean en la mayoria de los juegos a una HD4890!!! Por que?? Por que nVidia se puso las pilas con los drivers??? o por que en ATI son unos completos inutiles que no saben sacar drivers decentes??

En fin... hacia muhco que no escribia por aqui,![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

perdon por el toxo

Saludos!!!

) saldran los nuevos drivers de ATi, a ver si dan soporte a las nuevas y arreglan fallos de las actuales con juegos como MW2 (me pega "tirones" y aun no se por que, segun he leido podria ser por la BASURA de drivers de ATi para el Wnidows 7) a ver que tal los benchmarks con estos nuevos drivers y a seguir esperando a "Fermin" que si rinden como es debido creo que la GTX 360 podria ser mi proxima grafica

) saldran los nuevos drivers de ATi, a ver si dan soporte a las nuevas y arreglan fallos de las actuales con juegos como MW2 (me pega "tirones" y aun no se por que, segun he leido podria ser por la BASURA de drivers de ATi para el Wnidows 7) a ver que tal los benchmarks con estos nuevos drivers y a seguir esperando a "Fermin" que si rinden como es debido creo que la GTX 360 podria ser mi proxima grafica ![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)