Darkcaptain escribió:La 2070 no estará muy lejos de una 1080TI , si no tiempo al tiempo. Lo mismo que una 1060 supera a una 970 y se acerca a una 980.

Eso es de una 2080.

Yo tampoco quiero mas gráficos, pero tienen que "vender" algo y esta vez va a ser el RT y el 4k, en mi caso aguantaré con la 1080 lo máximo que pueda jugando en QHD.

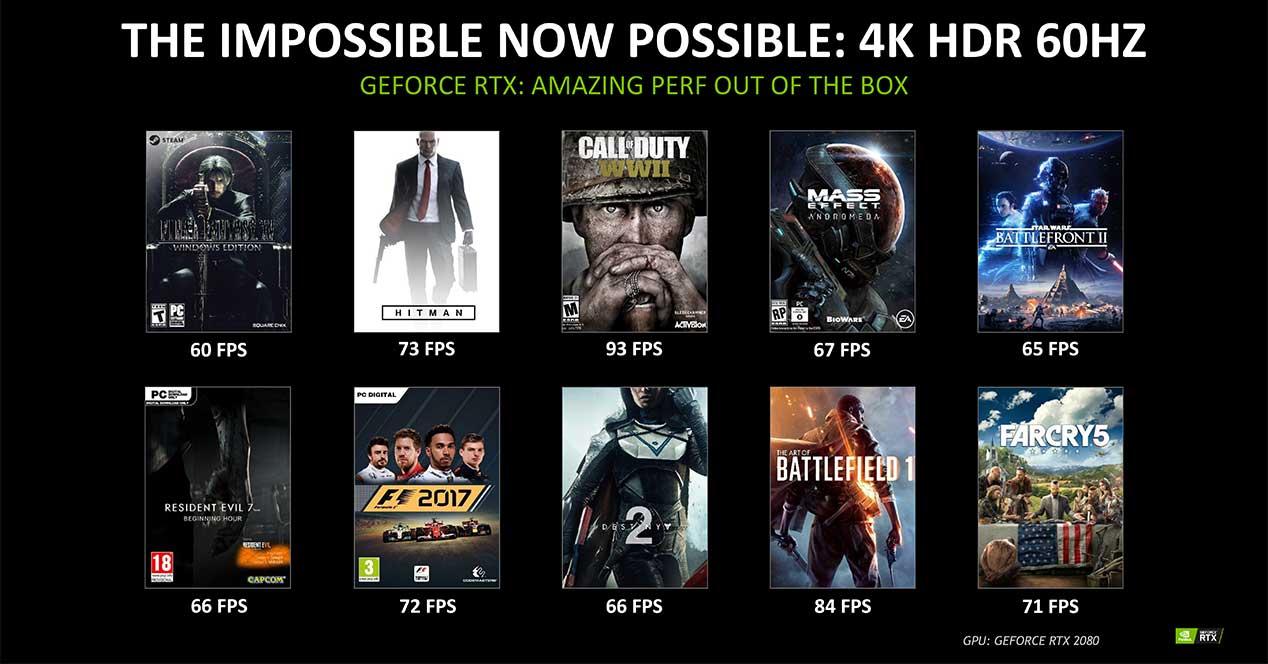

Esa imagen muestra los test con una RTX 2080 y por ejemplo la GTX 1080Ti el FarCry 5 logra 64FPs en ULTRA 4K (Máximo) una media de 50FPs y esta supuesta 2080 saca 70FPs, el F1 2017 la 1080Ti saca 75FPs (de media) y la imagen pone 72, eso no es bueno, la imagen pertenece a una noticia que dice

[En la segunda diapositiva vemos las cifras de rendimiento en FPS de algunos juegos ejecutados en 4K HDR a 60 Hz, superando o igualando todos ellos los 60 FPS. Sin embargo, la compañía no detalla qué calidad gráfica usan, aunque cabría esperar que sean todos los juegos al máximo de calidad.] Así cualquiera, pero suponiendo que sea ultra eso de que la 2070 se acerca a una 1080Ti va a ser que no, dependiendo del juego y viendo videos en youtube la GTX 1080Ti saca mejores o peores resultados que la supuesta imagen de Nvidia con un +/- 15FPs como mucho. Eso no es el "DOBLE" que dice Nvidia ni de coña.

Edy escribió:Efectivamente, esta es la conclusion real.

Es decir, el RT en tiempo real no es en absoluto necesario. Es cierto que para determinadas escenas, puede aportar cosas muy interesantes, pero es una tecnica increible para realizar renders con CAD o con programas de muestra de edificios, etc.

Pero para un videojuego, es ridiculo, basicamente prque la base grafica es tan "simple" que agregarle una rutina que resta tanto rendimiento, es un problema mas que un beneficio. Es como cuando se le aplicaba antialiasing a un juego con una resolucion enorme ... es cierto que ganaba, pero al final restaba tanto rendimiento, que mas valia bajar resolucion, y aumentar los efectos si compensaba a nivel grafico.

AHora ves muchos brillitos que no aportan NADA ... pero que restan muchisimo rendimiento. Por eso que en estos casos, es ridiculo esto teniendo en cuenta los juegos en los que se podria aplicar con cierta calidad.

Como dice Edy se han inventado una nueva forma de frenar las gráficas actuales y así seguir vendiendo churros que no hacen falta. Eso pasa desde siempre, Cuando salio la PS3 el nivel gráfico era increíble y X360 no se quedo corta, luego apareció Crysis y otros juegos más que nos dejaron con la boca abierta, pienso que en ese momento ya no hubiera hecho falta seguir aumentando la calidad gráfica y centrarse más en la historia y detalles pequeños, pero no, eso no interesa, la idea era seguir metiendo más mierda en los juegos para consumir hardware y seguir vendiendo, Nvidia es de soltar pasta a las desarrolladoras para vender sus gráficas. Así normal que el PC siempre sea "Master Race" si es que fuerzan a que sea así por cojones.

El ejemplo más descarado que he visto hasta la fecha es el Crash Remake, muchos se han quejado del capado a 1080 o 1440P y 30 FPs en la versión de consolas, sin contar la de Switch, en PC una 1080Ti apenas llega a 60FPs en ULTRA 4K. Pero luego ves videos como el OFF CAMERA y ves la cantidad de testeos y basura que ha dejado Activision en los niveles, por no decir que un mapa pueden ser hasta 4 niveles a la vez, eso sobrecarga de forma innecesaria la gráfica y procesador para pintar todo eso ademas de aumentar los tiempos de carga, estoy seguro que si quitaran eso por lo menos tendrían 60 FPs asegurados y la versión de PS4 PRO podría llegar incluso al 4K real. Tal y como se ve el juego parece intencionado.

Pienso que para cinemáticas in game como las de Metal Gear si, le daría ese toque más cinemático pero tal y como están ahora los motores gráficos creo que no es necesario esto, lo que han logrado con los motores gráficos en cuanto a luces, sombres y reflejos es una bestial rayada de optimización y años de trabajo, seria una putada que ahora Nvidia por presentar eso mandara a la mierda todos esos años de desarrollo de optimización solo para vender unas cutres gráficas que no son lo que dicen ser. Pero así funciona el mundo y no hay nada que hacer contra el dinero. Es que puedes buscar renders de RayTracing vs UDK o Unity y no ves diferencia, con eevee si porque aun está verde pero no está lejos de estar por igual.

Mira intel, ahora ha salido que por favor la gente no ponga comparativas de rendimiento entre antes y después de aplicar el parche, claro, por que si se muestra la realidad la gente dejara de comprar intel y comprara AMD, si si, lo llevas claro Intel, Anda y sigue con el VLC a mentir a la gente, la gente no es tan tonta, yo ya metí el parche del Meltdown y spectre y si, se nota una perdida, con el nuevo parche la perdida es mucho mayor así que ya ni actualizare.

En fin. A mi solo me falta ver como trabajan estas gráficas con motores de diseño 3D, que aunque me compre una GTX 1060 y rinde mucho mejor que la GTX 660 que tenia antes, aun me tira bastante lento para renders, claro que no la comprare de primeras, solo para hacerme a la idea de si pueden subir más de velocidad aunque viendo el panorama no espero gran cosa. No es la primera vez que Nvidia hace algo así y no es la única AMD también se sube por las paredes con el HYPE como cuando mostró las RX400 diciendo que 2 RX480 eran superiores a la GTX 1080Ti y luego resulto que la demostración ejecutaba el juego en calidad media mientras la 1080Ti era ULTRA y ademas al venderse se demostró que estaba cerca de la 1070 las 2 RX480.

Espera que ahora llega intel con sus nuevo intento de gráficas dedicadas a ver que perla nos suelta.

Me pone de los nervios estas cosas.

![adios [bye]](/images/smilies/nuevos2/adio.gif)

Igual que con los mods del GTA V que salieron, todo brillante, reflejoso, mojado... Eso es la siguiente generacion?

Igual que con los mods del GTA V que salieron, todo brillante, reflejoso, mojado... Eso es la siguiente generacion? Igual que con los mods del GTA V que salieron, todo brillante, reflejoso, mojado... Eso es la siguiente generacion?

![demoniaco [sati]](/images/smilies/nuevos2/demonio.gif) .

.