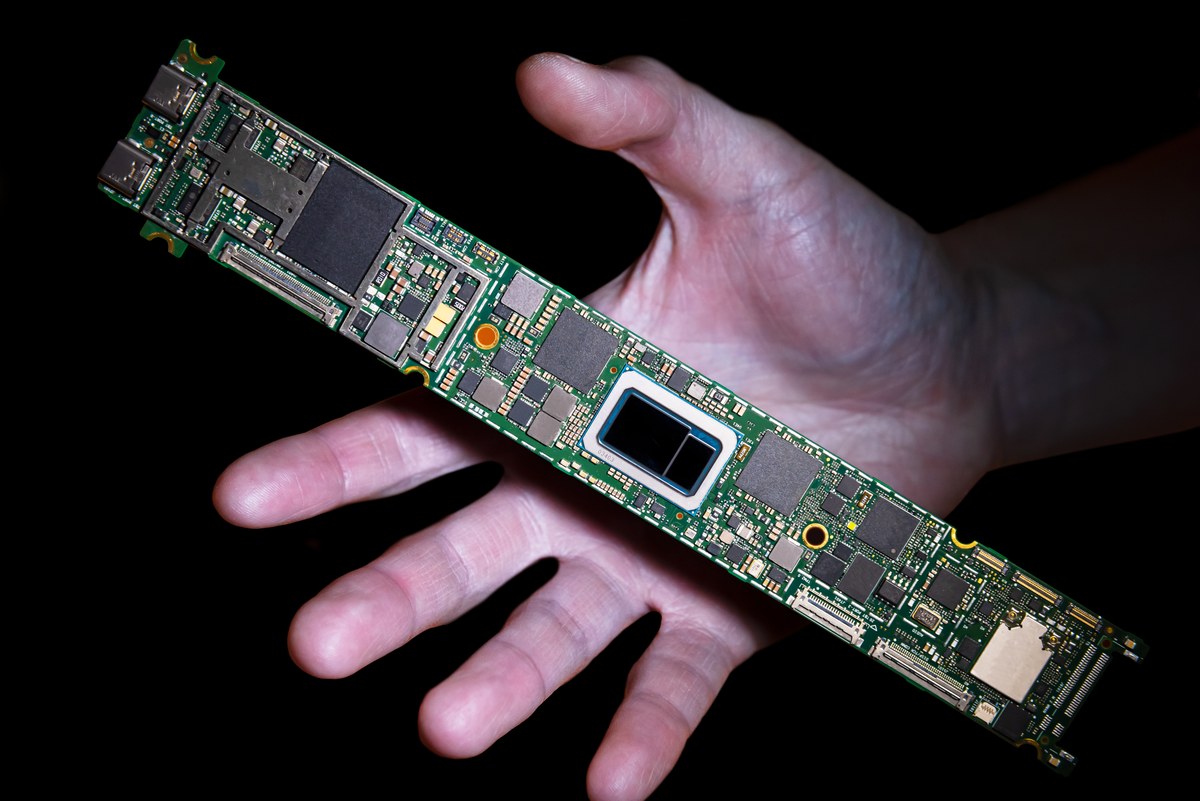

Tiger Lake (centro) integrado en una placa.

Tiger Lake (centro) integrado en una placa.ramulator escribió:De momento, esto y nada es lo mismo. El juego en movimiento es Warframe y eso funciona hasta en calculadoras. O más específicamente, las iGPU de Intel de los últimos 10 años lo pueden mover.

radastan escribió:Decir que las i740 fueron infaustas es faltar completamente a la verdad. En su día eran una opción muy económica a las de nVidia y 3DFX, por no hablar que no estaban muy lejos en rendimiento. nVidia tuvo que sacar las Riva TNT para poder marcar la diferencia, y las i740 fueron de las primeras tarjetas en usar el puerto AGP.

Aún recuerdo lo bien que tiraban los juegos, como el Need For Speed Hot Pursuit. Una puñetera maravilla.

Alejo I escribió:ramulator escribió:De momento, esto y nada es lo mismo. El juego en movimiento es Warframe y eso funciona hasta en calculadoras. O más específicamente, las iGPU de Intel de los últimos 10 años lo pueden mover.

Me preocupa que mucho power y mucha mejora de doble dígito, pero te sacan la demo con Warframe y hablan de "juego en HD".

Me veo a Nvidia sacándose la chorra y haciendo el molinillo durante todo 2020.

ramulator escribió:Alejo I escribió:ramulator escribió:De momento, esto y nada es lo mismo. El juego en movimiento es Warframe y eso funciona hasta en calculadoras. O más específicamente, las iGPU de Intel de los últimos 10 años lo pueden mover.

Me preocupa que mucho power y mucha mejora de doble dígito, pero te sacan la demo con Warframe y hablan de "juego en HD".

Me veo a Nvidia sacándose la chorra y haciendo el molinillo durante todo 2020.

Me espero cualquier cosa. Nvidia puede llevarse el gato al agua con el paso a 7nm+ de su serie 3000, pero también AMD tiene que estrenar sus tarjetas "Full RDNA" (porque las actuales todavía usan cosas de GCN) y habrá que ver qué tal funciona su hardware para raytracing. Y el DG1 suena a poca cosa pero pinta a que se merendará la gama baja de dedicadas para ultrabooks (las Nvidia MX).

radastan escribió:Decir que las i740 fueron infaustas es faltar completamente a la verdad. En su día eran una opción muy económica a las de nVidia y 3DFX, por no hablar que no estaban muy lejos en rendimiento. nVidia tuvo que sacar las Riva TNT para poder marcar la diferencia, y las i740 fueron de las primeras tarjetas en usar el puerto AGP.

Aún recuerdo lo bien que tiraban los juegos, como el Need For Speed Hot Pursuit. Una puñetera maravilla.

PilaDePetaca escribió:ramulator escribió:Alejo I escribió:Me preocupa que mucho power y mucha mejora de doble dígito, pero te sacan la demo con Warframe y hablan de "juego en HD".

Me veo a Nvidia sacándose la chorra y haciendo el molinillo durante todo 2020.

Me espero cualquier cosa. Nvidia puede llevarse el gato al agua con el paso a 7nm+ de su serie 3000, pero también AMD tiene que estrenar sus tarjetas "Full RDNA" (porque las actuales todavía usan cosas de GCN) y habrá que ver qué tal funciona su hardware para raytracing. Y el DG1 suena a poca cosa pero pinta a que se merendará la gama baja de dedicadas para ultrabooks (las Nvidia MX).

El problema es que en cuanto AMD saque las full RDNA tiene que sacar drivers nuevos si o si (o sea, desde 0, y lo que ha hecho con todos los anteriores no les sirve de nada) y después de el trabajazo que se han dado para poder sacarle chicha a todo lo anterior, de que quieran sacar otra vez drivers pulidos nVidia se habra sacado la chorra ya varias veces y seguiran en las mismas.

ramulator escribió:PilaDePetaca escribió:El problema es que en cuanto AMD saque las full RDNA tiene que sacar drivers nuevos si o si (o sea, desde 0, y lo que ha hecho con todos los anteriores no les sirve de nada) y después de el trabajazo que se han dado para poder sacarle chicha a todo lo anterior, de que quieran sacar otra vez drivers pulidos nVidia se habra sacado la chorra ya varias veces y seguiran en las mismas.

Realmente, al haber hecho un medio paso a RDNA con la serie 5000 ya tienen la mayor parte del trabajo en drivers hecho, que además de lanzamiento tuvieron pegas pero no tardaron en solucionarlo. Y seguramente sigan sin hacer frente a Nvidia en consumo, pero si no competían en gamas altas era por limitaciones de la arquitectura, pero con las Full RDNA ya pueden sacar tarjetas de esas gamas.

PilaDePetaca escribió:ramulator escribió:PilaDePetaca escribió:El problema es que en cuanto AMD saque las full RDNA tiene que sacar drivers nuevos si o si (o sea, desde 0, y lo que ha hecho con todos los anteriores no les sirve de nada) y después de el trabajazo que se han dado para poder sacarle chicha a todo lo anterior, de que quieran sacar otra vez drivers pulidos nVidia se habra sacado la chorra ya varias veces y seguiran en las mismas.

Realmente, al haber hecho un medio paso a RDNA con la serie 5000 ya tienen la mayor parte del trabajo en drivers hecho, que además de lanzamiento tuvieron pegas pero no tardaron en solucionarlo. Y seguramente sigan sin hacer frente a Nvidia en consumo, pero si no competían en gamas altas era por limitaciones de la arquitectura, pero con las Full RDNA ya pueden sacar tarjetas de esas gamas.

No, de hecho, han lanzado las RDNA todavía con partes GCN por aprovechar los drivers que tenian antes, pero el cambio a RDNA2 es directamente un cambio de paradigma en la arquitectura, y los drivers los tienen que hacer desde 0. Y el problema que tienen de competencia en gamas altas es precisamente porque la arquitectura RDNA hace que se disparen los consumos (sólo hace falta ver que aunque haya habido un aumento de rendimiento con el cambio de nodo, los consumos siguen siendo una barbaridad). No habrá competencia de AMD en gamas altas hasta que no hagan el cambio de arquitectura total para poder tener mas CU's con unas velocidades contenidas (el "sweet spot" de las series 5000 está entre 1600-1700MHz) y que los consumos no se disparen.

ramulator escribió:PilaDePetaca escribió:ramulator escribió:Realmente, al haber hecho un medio paso a RDNA con la serie 5000 ya tienen la mayor parte del trabajo en drivers hecho, que además de lanzamiento tuvieron pegas pero no tardaron en solucionarlo. Y seguramente sigan sin hacer frente a Nvidia en consumo, pero si no competían en gamas altas era por limitaciones de la arquitectura, pero con las Full RDNA ya pueden sacar tarjetas de esas gamas.

No, de hecho, han lanzado las RDNA todavía con partes GCN por aprovechar los drivers que tenian antes, pero el cambio a RDNA2 es directamente un cambio de paradigma en la arquitectura, y los drivers los tienen que hacer desde 0. Y el problema que tienen de competencia en gamas altas es precisamente porque la arquitectura RDNA hace que se disparen los consumos (sólo hace falta ver que aunque haya habido un aumento de rendimiento con el cambio de nodo, los consumos siguen siendo una barbaridad). No habrá competencia de AMD en gamas altas hasta que no hagan el cambio de arquitectura total para poder tener mas CU's con unas velocidades contenidas (el "sweet spot" de las series 5000 está entre 1600-1700MHz) y que los consumos no se disparen.

¿De dónde sacas eso de los drivers? Lo de las gamas altas ya he explicado que era por limitaciones de la distribución del hardware de la arquitectura GCN, ¿de dónde leches sacas lo de los consumos? La Vega 64 está entre 285 y 295W en carga mientras que la 5700XT (que ya he dicho que consigue el mismo rendimiento) se sitúa en 215-220W. La 2080Ti está en esos 280W y de cualquier modo históricamente las AMD siempre han consumido más para ofrecer el mismo resultado a cambio de otros puntos a favor. Es más... La rival directa de la 5700XT es la 2070 Super, que tiene un rendimiento idéntico, y esta consume 210-215W. ¿Qué "barbaridad" es entonces si es la primera vez en diez o quince años que AMD está pareja en consumos por rendimiento con AMD?

Hablar por hablar.

PilaDePetaca escribió:ramulator escribió:PilaDePetaca escribió:No, de hecho, han lanzado las RDNA todavía con partes GCN por aprovechar los drivers que tenian antes, pero el cambio a RDNA2 es directamente un cambio de paradigma en la arquitectura, y los drivers los tienen que hacer desde 0. Y el problema que tienen de competencia en gamas altas es precisamente porque la arquitectura RDNA hace que se disparen los consumos (sólo hace falta ver que aunque haya habido un aumento de rendimiento con el cambio de nodo, los consumos siguen siendo una barbaridad). No habrá competencia de AMD en gamas altas hasta que no hagan el cambio de arquitectura total para poder tener mas CU's con unas velocidades contenidas (el "sweet spot" de las series 5000 está entre 1600-1700MHz) y que los consumos no se disparen.

¿De dónde sacas eso de los drivers? Lo de las gamas altas ya he explicado que era por limitaciones de la distribución del hardware de la arquitectura GCN, ¿de dónde leches sacas lo de los consumos? La Vega 64 está entre 285 y 295W en carga mientras que la 5700XT (que ya he dicho que consigue el mismo rendimiento) se sitúa en 215-220W. La 2080Ti está en esos 280W y de cualquier modo históricamente las AMD siempre han consumido más para ofrecer el mismo resultado a cambio de otros puntos a favor. Es más... La rival directa de la 5700XT es la 2070 Super, que tiene un rendimiento idéntico, y esta consume 210-215W. ¿Qué "barbaridad" es entonces si es la primera vez en diez o quince años que AMD está pareja en consumos por rendimiento con AMD?

Hablar por hablar.

Pues todo eso se saca de haber leído el porque de los problemas de arquitectura con GCN y Vega, el porque del aumento de IPC con RDNA, el porque del consumo y las velocidades y el porque los drivers tienen que ser de 0. Se llama informarse (que el google está para todos y hay una tonelada de información y de gente que ha hablado del cambio de arquitectura y de que supone full RDNA), el resto, como tu lo dices (y haces) es hablar por hablar.