Como ya he comentado alguna vez, en mi universidad me encontré con el problema de entrar a un máster y realizar un doctorado en el que se exige mucha investigación, pero apenas dan formación. Además, preguntando me he dado cuenta que es (o era hasta hace 10 años) la tónica general en España independientemente de la facultad.

Supongo que en otras carreras no pasará esto, pero por si le sirve de ayuda a alguien y aprovechando que me he creado un Word de consulta para no tener que redescubrir ciertos conceptos cuando preparo mis clases, lo cuelgo aquí también. Lo hago porque en este foro suele haber interés en los estudios, pero es frecuente encontrar errores de bulto al interpretarlos y con esto se puede limitar algo.

Por deformación profesional me voy a centrar en medicina, pero en general se puede aplicar a prácticamente todo. Empezamos.

El método científicoEl método científico, o los métodos científicos, como se ha puesto de moda llamarlos ahora por algunos divulgadores (aunque nadie me ha conseguido decir un método científico diferente a otro) consiste dicho muy pronto y mal, en plantear una hipótesis y probar si es cierta o no, básicamente probar lo que dices. Algo tan básico supone el corazón de cualquier artículo científico y lo que nos permitirá obtener conocimiento cierto sobre un tema. En ello se basa el contraste de hipótesis -debido a la imposibilidad de comprobar todos los casos posibles del universo o la población, la ciencia se basa en encontrar la anomalía, pues cuando la encuentras no es necesario ya comprobar todos los casos del universo. Por ello decimos que la ciencia niega, más que afirmar.

Pero claro, a nosotros normalmente nos interesa afirmar, por lo tanto ¿qué hacemos? Utilizar la hipótesis nula, que vendría a ser “no existen diferencias entre los grupos por el hecho de administrar tal medicamento”. Si la negamos, no quiere decir que el medicamento o tratamiento realmente funcione, pero si hemos controlado el resto de factores, sí lo es de facto. Por ello los estudios deben orientarse a negar la hipótesis nula, los que intentan afirmarla suelen ser de calidad metodológica bastante peor.

Ejemplo, si quiero probar que mi nuevo tratamiento Panaceum es efectivo, mi hipótesis nula sería: "En el grupo de pacientes X (diabéticos, hipertensos...), el uso del medicamento Panaceum no muestra diferencias significativas respecto al grupo control (placebo o el mejor tratamiento existente hasta la fecha) en cuanto a índice glicémico/tensión arterial...".

Si la conseguimos negar, supone la aceptación de la hipótesis alternativa, que es que sí existen diferencias por la administración del tratamiento.

Diseños de estudioTodos hemos oído hablar del ensayo clínico y sabemos que es la mejor forma de probar la efectividad de un tratamiento, ¿pero por qué es así? Vamos a ver los distintos tipos de diseños principales:

- Ensayo clínico controlado aleatorizado: es junto al estudio de cohortes, el único diseño que permite establecer relaciones de causalidad. El motivo es porque son los únicos con período de seguimiento. Es el de mayor calidad metodológica porque utiliza un grupo control. El grupo control nos permite evitar situaciones como “el agua es mala porque el 100% de las personas que la beben se mueren”, al tener algo con lo que comparar. Otra ventaja de este diseño es que se aleatoriza el tratamiento. Esto es lo que le convierte en el mejor diseño de estudio, ya que aleatorizar, si la muestra es lo suficientemente grande, nos asegura controlar todas las variables que puedan modificar la respuesta al tratamiento (incluidas las que desconocemos). Por último, se realiza siempre en humanos enfermos, a los que se les administra un tratamiento. Ejemplo: cogemos a enfermos de cáncer y establecemos dos grupos, uno al que se le aplicará la intervención y otro de control y serán asignados a uno u otro de forma aleatoria.

- Estudio de cohortes: se parte de dos o más grupos (cohortes) de pacientes sanos. Los grupos se crean según la exposición a un factor (fumadores y no fumadores por ejemplo) que queremos estudiar y se les sigue durante un tiempo largo. Como tenemos que esperar a que enfermen, normalmente necesitaremos muestras mucho más grandes para que aparezca algún caso y seguimientos largos. Son los estudios de elección para buscar las causas de las enfermedades, así como el ensayo clínico era el mejor para establecer relaciones de causa-efecto entre tratamiento y sanación. Ejemplo: cogemos a un grupo de miles de personas sanas representativo de la sociedad y los dividimos en según si fuman o no. Los controlamos en el tiempo y vemos cuantos enferman tanto en el grupo de fumadores como en los que no, y comparamos.

- Estudio de casos y controles: como el anterior necesita de mucha muestra y tiempo de seguimiento, es mucho más barato y rápido agrupar todos los enfermos que tengas en un grupo (en lugar de esperar a que los sanos enfermen) de casos y buscar otro control con características similares. Por desgracia este diseño ya no permite establecer relaciones de causalidad, si no sólo factores de riesgo. Ejemplo: aquí el grupo de casos serán pacientes que ya han enfermado, por ejemplo de cáncer y el control personas sanas con características similares. Se investiga cuantos fumaban y cuantos no en cada uno de los grupos y se compara.

- Estudio transversal: similar al anterior pero en vez de organizar por aparición de enfermedad, organizas por exposición. Ejemplo: coges las historias clínicas de los pacientes que has tenido en el pasado y buscas la situación que había en ese momento, tanto de enfermos como de factores de riesgo.

- Series de casos: aquí ya no hay grupo control, por lo tanto sólo sirven para informar de la aparición de enfermedades nuevas que no existían (o no se conocían) y describir un poco la enfermedad y los síntomas. O contestando a Gurlukovich, también sirve para indicar nuevas alternativas de tratamiento. Ejemplo: el que pone Gurlu, infectar a un niño y ver como evoluciona

.

- Estudios en animales: guste o no guste, los comités de ética exigen un mínimo de evidencia antes de poder probar un medicamento en humanos. Para ello se eligen ciertas especies según lo que se vaya a administrar, pues cada una es más similar al humano en algún aspecto. Están muy controlados pues cómo normalmente acaban con la vida del animal, no se permiten muestras grandes y se debe contratar a una persona adrede para asegurar el bienestar de los animales mientras dure el estudio. Ejemplo: prácticamente idéntico al ensayo clínico, pero con animales en vez de humanos.

- Estudios in vitro: los famosos estudios in vitro no incluyen humanos, por lo tanto la relevancia de los resultados es muy limitada. El motivo, mejor que lo explique xkcd:

Traducción para quien no sepa inglés: cada vez que veas una noticia de que algo mata células cancerígenas en un estudio in vitro, ten en cuenta que también lo hace una pistola.

Los comités de ética Es evidente que no podemos exigir un ensayo clínico para cualquier cosa, pues iría contra la salud de los participantes en el estudio. Los comités de ética se aseguran que el diseño del estudio se adhiere a las declaraciones de derechos de los participantes en los estudios, normalmente la de

Helsinki. Hoy en día no te permiten publicar en ninguna revista si no ha pasado por el comité de ética y ha recibido su aprobación.

Por lo tanto no hay que ser talibanes de los ensayos clínicos, a veces un estudio de cohortes o incluso varios de caso-control nos puede aportar información suficiente.

Esto fue parodiado por un artículo de revisión que decía que no tenemos evidencia médica de que saltar con paracaídas sea más sano que hacerlo sin paracaídas e invitaban a los talibanes de los ensayos clínicos a participar en un ensayo clínico controlado por placebo (sin paracaídas), aleatorizado, a doble ciego (sin saber si te va a tocar paracaídas) y cruzado (es decir, primero te administran un tratamiento y luego el otro... si sobreviviste).

https://www.ncbi.nlm.nih.gov/pubmed/14684649Por supuesto siempre hay quien quiere continuar la broma y publicaron una contestación diciendo que habían hecho un "ensayo clínico" para zanjar el tema. Lo pongo entre comillas porque como dije, el ensayo clínico siempre es en humanos, y este estudio es con muñecos por cuestiones del comité de ética, por lo tanto este estudio realmente no es un ensayo clínico y la cuestión sigue abierta

:

https://www.ncbi.nlm.nih.gov/pubmed/26769034Validez interna y externaSi nos gustan tanto los ensayos clínicos es porque tienen mucha validez interna. Esto es que la calidad metodológica es muy buena, por lo tanto, los resultados tienen muchas probabilidades de ser ciertos. Ejemplo: si yo controlo muy bien la gente que entra al estudio de forma que no entre nadie con problemas independientes a lo que estoy estudiando, será más difícil que me alteren los datos.

El problema es que la mayor parte suelen tener unos criterios de inclusión demasiado estrictos, buscando controlar el mayor número de variables. Esto puede aumentar la validez interna, pero reduce la externa, que es la posibilidad de generalizar los resultados a toda la población. La población general suele tener varios problemas, no son pacientes ideales, por lo tanto si eres muy estricto seleccionando, tu muestra no se parecerá a la población general.

Por ello en los últimos tiempos se han puesto de moda los ensayos clínicos llamados “pragmáticos”, con criterios de inclusión laxos, donde es más difícil encontrar diferencias entre grupos, pero sus conclusiones son mucho más generalizables.

Contraste de hipótesisDecíamos que una gran parte del método científico se basaba en el contraste de hipótesis. Por desgracia somos incapaces de verificar todos los casos de la población, pero un teorema matemático conocido como Teorema del límite central nos dice que, en presencia de muchas variables independientes aleatoriamente distribuidas, los datos tienden a asemejarse a una distribución normal (o campana de Gauss) cuando la muestra es lo bastante grande. Esto quiere decir que cuando llegamos a un determinado tamaño de muestra, aumentarlo no nos va a aportar apenas beneficios y por ello con datos de miles o unos cientos de personas se pueden extrapolar a toda la población.

El problema es que trabajar sobre esto supone saber de estadística, pues cada test tiene sus condiciones de aplicación. En general se dividen en dos grandes grupos: paramétricos o no paramétricos. Los primeros son mucho más potentes, pero exigen que la distribución de datos siga una normal (u otra forma). Si en un estudio con menos de 100 personas veis que utilizan un test paramétrico sin realizar primero tests de normalidad (como Kolmogorov-Smirnov o Shapiro-Wilk), casi con seguridad lo está aplicando cuando no debe. Un ejemplo sería la media, y por ello no es correcto aplicarla por ejemplo a la distribución de salarios, pues no sigue una normal. Los no paramétricos son menos potentes pero se pueden aplicar a cualquier situación.

La famosa pEstos test lo que nos suelen arrojar es un valor de probabilidad entre 0 y 1 que llamamos p. Básicamente consiste en la probabilidad de que las diferencias entre grupos se deban a puro azar. Por convenio, por el tamaño de muestra que se utiliza en medicina, se establece que si es inferior a 0.05 las diferencias son estadísticamente significativas. Es decir, que si nos dicen que las diferencias entre grupos son significativas, quiere decir que la probabilidad de que se deban a puro azar son inferiores al 5%.

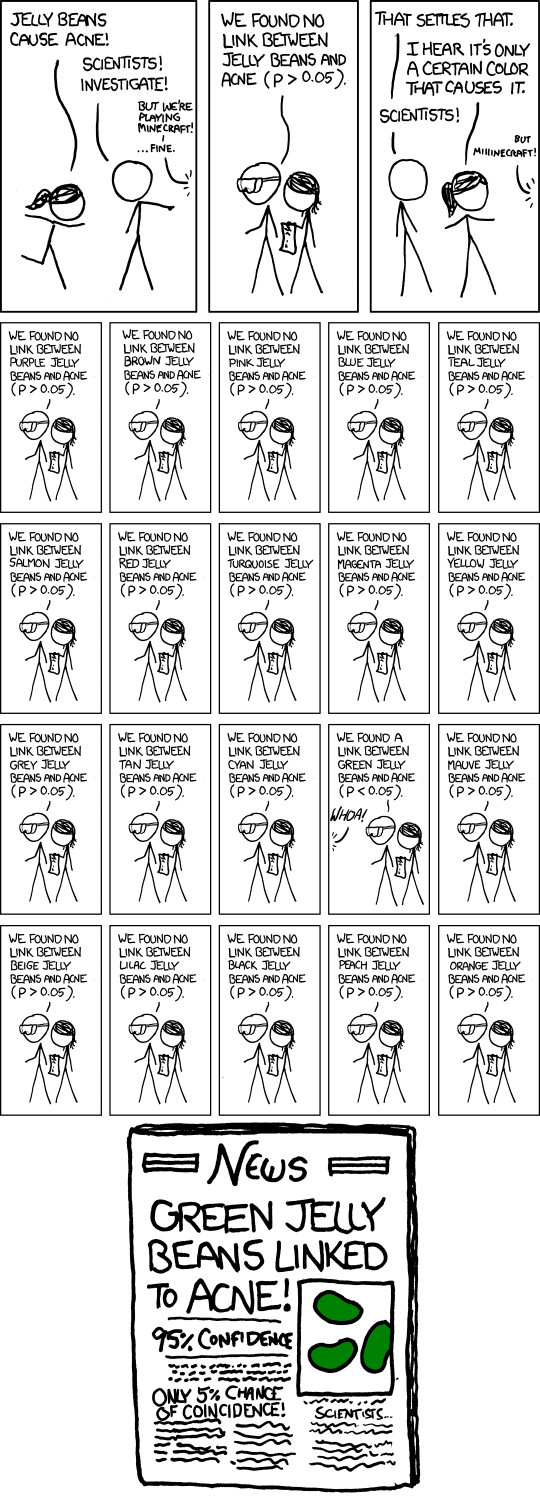

Un problema frecuente parodiado por xkcd en esta viñeta es que, si hacemos test repetidos de una misma variable, obviamente esa probabilidad aumentará, por lo que habrá que ser más estrictos y aplicar una corrección. La corrección más típica es la de Bonferroni, pero hay muchísimas más.

Traducción para quien no sepa inglés:

- He oído que las gominolas (no son gominolas, pero parecido) producen acné.

- Científicos ¡investigad!

- Pero estamos jugando al Minecraft... bueno vale.

- No encontramos relación entre las gominolas y el acné.

- ¡He oído que sólo lo provocan las de un determinado color!

- Científicos, investigad.

- Pero el Minecraft...

- No hay relación con 19 de los colores, pero se encuentra una relación en el verde.

- En las noticias: las gominolas verdes provocan acné con un 95% de confianza. Sólo un 5% de probabilidades de estar equivocado.

Otra cosa que debemos tener en cuenta es que aumentar la muestra nos reduce las probabilidades de apoyar la hipótesis nula cuando realmente es falsa, pero nos aumenta la probabilidad de negarla cuando es verdadera. En otras palabras, una muestra grande aumenta las posibilidades de encontrar diferencias cuando realmente no existen. Por lo tanto, hay que desconfiar de efectos pequeños, aunque sean estadísticamente significativos, si la muestra es enorme.

Significatividad vs relevancia clínicaQue las diferencias sean significativas simplemente quiere decir que existen. Pero muchas veces son tan pequeñas no merecen ni ser tenidas en cuenta, por ello no sólo hay que mirar por la significancia, si no también por la relevancia clínica. Ejemplo, sin un medicamento me reduce la tensión arterial en un punto de forma consistente, será estadísticamente significativo, pero no tendrá relevancia clínica alguna, pues no valdrá la pena el gasto para un resultado tan pobre, aunque exista.

Para ello hay algo mucho más potente que la p, que es lo que llamamos intervalos de confianza. El intervalo de confianza nos indica con un 95% de confianza donde se encontrará la media real de la población, no sólo la de nuestro estudio, ofreciéndonos un valor superior e inferior tope que conforman el intervalo. Por un lado, también nos indican sin las diferencias son significativas o no, si no incluyen el 0 al comparar medias o no incluyen el 1 al utilizar variables de asociación como la odds ratio, quiere decir que las diferencias son estadísticamente significativas.

Por otro lado, el valor superior nos indica cómo de grande es ese efecto, cuanto más grande, más efecto. Además, si el valor inferior supera el valor que se considera como clínicamente relevante, el efecto medido también será clínicamente relevante.

Por último, si el intervalo es estrecho, será mucho más preciso que si es más amplio.

Ejemplo con valores inventados: digamos que estamos estudiando un medicamento que analiza la hemoglobina glicosilada, que es lo que se utiliza para medir los niveles de azúcar a largo plazo. Imaginemos que nuestro estudio nos da un intervalo de confianza de [-3, -2.1] de diferencia para las medias. Esto quiere decir que:

- Con una confianza del 95%, la media en la población real se encuentra entre 3 y 2,1 puntos por debajo del control al utilizar mi medicamento.

- Las diferencias entre grupos son significativas, porque no se incluye el 0, que sería la ausencia de diferencias.

- El efecto es tirando a grande, porque el valor inferior (en este caso utilizamos el valor inferior, porque cuanto más bajo, más efecto en cuanto a control de diabetes) está bastante por debajo del control.

- Además no hay mucha discrepancia en los resultados porque el intervalo es medianamente estrecho.

- Si en vez de la diferencia de medias vemos simplemente el intervalo del grupo test, que es [4.1, 5] diríamos que es clínicamente relevante, porque el umbral para la diabetes es 6,5 y el intervalo no lo incluye.

Como véis, mucha más información que la p, pero también podemos obtener intervalos sobre el riesgo relativo. Pongamos un ejemplo con riesgo de cáncer y tabaco y supongamos que obtenemos como intervalo del riesgo relativo [3, 3.5]. Esto se leería:

- Con un 95% de confianza, el tabaco aumenta entre 3 y 3,5 veces la probabilidad de cáncer respecto a los no fumadores.

- Esto es estadísticamente significativo, porque el intervalo no incluye el 1. Aquí como utilizamos una proporción (dividir riesgo en expuestos vs riesgo en no expuestos) el valor nulo ya no es el 0, es el 1.

- No se si hay un límite que se considere clínicamente relevante en este caso pero como utilizamos valores inventados, pongamos que lo es a partir de un 10%, que traducido a tanto por 1 sería 1,1. Como el valor inferior es 3 y no incluye al 1,1, concluímos que aparte de estadísticamente significativo es clínicamente relevante.

- Como el intervalo es estrecho, el efecto es bastante uniforme, no hay grandes diferencias entre sujetos.

El problema de la odds ratioEn algunos estudios de utiliza de forma incorrecta el estadístico conocido como odds ratio para analizar el riesgo en lugar de utilizar el riesgo relativo. Esto es correcto si la incidencia del suceso a estudiar es inferior al 10%, pues ahí la odds coincide bastante bien con el riesgo. Pero a partir de ahí, la odds aumenta muchísimo más rápido, por lo tanto sólo tiene sentido utilizarla si el estudio no tiene seguimiento (pues en ese caso no es posible calcular el riesgo).

En un artículo de uno de los grupos más potentes de investigación del mundo en mi profesión cometieron este error, diciendo que la odds ratio de 4 indica que hay 4 veces más riesgo de efectos no deseados que en el grupo control. Sin embargo, si calculabas el riesgo ya no era 4, era 1,4, es decir, sólo un 40% más de riesgo.

El problema del riesgo relativoHabíamos visto en el punto anterior que utilizar Riesgos Relativos es mucho más fiable que utilizar odds ratio, pues estas son bastante complicadas de interpretar y el riesgo relativo se acerca mucho más a lo que entendemos por riesgo. Pero este también tiene limitaciones, pues cuando pensamos en riesgos, normalmente no pensamos en cuanto riesgo tenemos por haber sido expuesto vs no haber sido expuesto, sino al riesgo total. Un ejemplo que desarrollo mucho más en la parte de estadística bayesiana son los test.

Un ejemplo: si miras cuanta gente ha muerto por violencia de género según los reportes oficiales, el riesgo relativo es de 5, es decir, los muertos por violencia de género tienen una probabilidad de ser mujer 5 veces superior a ser hombre. Pero estando muerto, ya no te importa el sexo, tu lo que quieres saber realmente es, estando vivo, qué probabilidad tienes de morir por violencia de género. Y ahí la diferencia entre sexos es inferior a 0,001%, el motivo es que hay muy pocas muertes por violencia de género en comparación con la población total, más del 99,99% de la gente no va a morir por violencia de género. Esto es lo que llamamos "riesgo absoluto".

El cálculo del tamaño muestral y la potenciaDecíamos que el tamaño de la muestra es importante, tanto por si nos quedamos cortos como por si nos pasamos, pero ¿cómo calcularlo? Cohen en su día creó unas fórmulas que nos permiten a partir de unos datos conocidos, sacados de artículos científicos previos o si no los hay porque estamos investigando algo nuevo, sacados de un estudio pequeño previo que hagamos; poder calcular el tamaño muestral.

Como necesitamos esos datos previos para hacer el cálculo, todo estudio debe tener una variable principal, que será sobre la que se hará el cálculo. Por ello se intenta que los estudio tengan el menor número de variables respuesta posible (idealmente una), porque para el resto de variables el tamaño muestral puede ser insuficiente. La variable principal debe ser una muy importante (normalmente mortalidad), no vale coger una totalmente secundaria, pero con la que sepas que apenas vas a necesitar personas para realizar el estudio. Si no hay cálculo del tamaño muestral o utilizan una variable extraña en vez de una mucho más importante, desconfiad.

Para calcularlo necesitamos:

- Tamaño del efecto: es decir, media y desviación estándar de test y control

- Error alfa: en medicina por defecto 0.05. En física de partículas por ejemplo es muy inferior.

- Error beta: el cual lo elegimos nosotros. Se calcula restando a 1 la potencia en tanto por 1. El mínimo aceptable es 0.2, de ahí para abajo podemos elegir el valor que queramos, teniendo en cuenta que cuanto menos error, más pacientes necesitaremos.

Yo utilizo el programa G*Power para calcularlo, que es gratis pero hay un montón. Para ello primero seleccionas el tipo de test que utilizarás y seleccionas que vas a calcular "a priori". Si en vez del tamaño muestral quieres calcular la potencia, seleccionarás "power" en vez de a priori.

La potencia es básicamente la capacidad de encontrar diferencias significativas del estudio, y se puede calcular una vez ya lo has terminado. Normalmente deberá tener una potencia superior al 80% para ser aceptable.

SesgosLos sesgos son errores metodológicos que nos pueden llevar a conclusiones erróneas y que hay que evitar. Los más típicos son:

- No realizar aleatorización o realizarla con métodos inadecuados, como por ejemplo por orden de llegada, día de la semana…

- Mala ocultación de la asignación: no se ha utilizado un placebo en el grupo control que impida conocer qué tratamiento se ha realizado al paciente.

- Sesgo de desgaste: perder pacientes durante el estudio disminuye la potencia y puede romper la aleatorización. Por ello se suele incluir un 20% extra sobre lo que te dijo el cálculo muestral para evitarlo.

- Ofrecer datos incompletos: a veces se callan los resultados de alguna variable por conveniencia.

- Otros tipos de sesgo

Cegamiento Hemos visto que uno de los sesgos más frecuentes es el hecho de conocer qué tratamiento ha recibido el paciente. Para evitarlo podemos enmascararlo, por ejemplo utilizando un placebo, es decir, algo que es indistinguible del tratamiento a realizar, pero que realmente no hace nada.

Si el paciente es el único que no conoce el tratamiento que le van a realizar, se denomina cegamiento-simple.

Pero claro, aunque es cierto que el efecto placebo hace que el paciente mejore, al menos en los síntomas, la mayor parte del error suele venir por parte del profesional que hace las mediciones. Las mediciones clínicas no son tan precisas como las que las metes en la maquinita y te da un valor, y el médico, con sus ganas de encontrar un nuevo tratamiento que funciona, puede sobreestimar el éxito. Cuando el médico que hace las mediciones tampoco sabe qué tratamiento se ha realizado se llama doble ciego.

Pero aquí no termina la cosa, normalmente el estadístico que calcula los datos o va a cobrar por el trabajo hecho o va a ser el propio investigador, por lo que también va a estar sesgado a sobreestimar el efecto, pues como hemos visto, hay formas para "torturar los datos" hasta que te digan lo que quieres oír. Si desconoce qué tratamiento recibió cada grupo, se denomina triple-ciego.

Por último, a la hora de escribir el artículo, el investigador puede elegir quedarse con unas variables y desechar otras o utilizar los modelos que más le convengan a lo que quiere decir. Por ello, a veces (casi nunca) no se le desvela qué grupo es cual hasta que está escrito casi por completo el artículo (la discusión a veces es imposible hacerla desconociendo los grupos). Esto se denomina cuádruple-ciego y creo que ya no hay más a partir de aquí.

Metanálisis y la colaboración CochraneLa colaboración cochrane es una de las organizaciones que más ha insistido en la necesidad de la medicina basada en la evidencia, influida por el desastre de la Talidomida y la falta de ensayos clínicos en la época. Este es su logo:

El logo simboliza un diagrama de bosque, muy utilizado como resumen de los metanálisis. Básicamente, la línea vertical simboliza la falta de efecto, y cada una de las barras horizontales son los resultados de un estudio. Si midieramos los resultados al peso, concluiríamos que de 7 artículos, sólo 2 muestran efectividad del tratamiento (no tocan la línea), por lo que deberíamos concluir que el tratamiento no es efectivo.

Pero el metanálisis va mucho más allá, creando como un estudio nuevo con la suma de las muestras de cada estudio. Los resultados del metanálisis son el rombo, que claramente se aleja de la línea vertical e indica un efecto fuerte. Pues bien, este metanálisis trataba sobre la administración de corticoides a niños prematuros y medía la supervivencia. La conclusión final es que sin realizar ningun ensayo clínico extra, simplemente con trabajo de despacho, se pudo concluir fuera de toda duda que la esperanza de vida aumentaba un 30% con la administración de corticoides y que decenas de miles de niños prematuros habían muerto sin motivo.

Con esto queda claro por qué un metanálisis bien hecho es el top del conocimiento científico, al compensar los sesgos de cada uno de los estudios. La clave está en lo de bien hecho, no son nada fáciles de hacer.

Aparte de los en diagramas de bosque nos podemos fijar en la heterogeneidad, normalmente medida con la I2. Si supera el 25% quiere decir que los estudios realmente están midiendo cosas distintas y las conclusiones del metanálisis no son fiables. Normalmente ocurre cuando los controles no son los mismos en cada uno de los estudios analizados.

Hay muchas más cosas que analizar metodológicamente en un metanálisis, pero eso no cabe en un post (de hecho son más de

600 páginasXD)

Teoría bayesianaHe repasado mis apuntes sobre teoría bayesiana, así que vamos a analizar un test. Supongamos que tenemos un test con una sensibilidad del 99% y una especificidad del 99%. Normalmente no son tan buenos, pero pongámonos en un caso extremo. ¿Cuál es la probabilidad de que si sale positivo el test realmente estemos enfermos? 99% o algo cercano ¿no? Vamos a calcularlo.

Según descubrió Bayes hace ya casi dos siglos, esta probabilidad viene determinada por P(H|E) = P(H) * P(E|H) / P(E), donde P significa probabilidad, H la hipótesis (en este caso estar enfermo), y la E sería la evidencia, es decir, nuestra prueba. P(H|E) sería la probabilidad de estar enfermo cuando la evidencia da positivo, P(H) la probabilidad de que nuestra hipótesis sea cierta independientemente de que realicemos o no la prueba (en otras palabras, la prevalencia de la enfermedad en la población), P(E|H) la probabilidad de que la prueba de positivo cuando realmente estemos enfermos y P(E) la probabilidad de que el test de positivo independientemente de que tengas o no cáncer.

Pues bien, calculemos. Lo que queremos obtener es P(H|E), que es la probabilidad de realmente estar enfermos cuando de positivo. Pues bien, lo primero sería sustituir P(H), que sería la prevalencia de la enfermedad. Pongamos 1%, o lo que es lo mismo, 0.01 (estoy siendo muy generoso, pues esa es la prevalencia del cáncer más frecuente, la media es mucho más baja). P(E|H) sería 0.99, pues es la eficacia del test. Por lo tanto en el numerador tenemos 0.01*0.99 = 0.0099. Estos son los verdaderos positivos.

Vamos al denomidador: P(E) es la probabilidad de dar positivo estés enfermo o no, o lo que es lo mismo, el porcentaje de verdaderos positivos (0.0099) + los falsos positivos. Pues bien, los falsos positivos se calculan multiplicando la probabilidad de falsos positivos (0.01, pues el test tiene una eficacia de 0.99) por el porcentaje de gente que no tiene cáncer (0.99, porque la prevalencia es del 1%). ¿Resultado? 0.0099. Vaya, resulta que tenemos el mismo porcentaje de verdaderos positivos que de falsos positivos, pese a que el test tiene una eficacia del 99%. Pero terminemos de calcular el denominador, decíamos que se componía de la suma de verdaderos positivos (0.0099) + falsos positivos (0.0099) = 0.198.

Por lo tanto, verdaderos positivos (0.0099) / probabilidad de dar positivo (0.198) = 0.5. Vaya, al final resulta que la probabilidad de estar realmente enfermo tras dar positivo en el test con 99% de eficacia es del 50%. Pero bueno, esto tiene solución fácil, aplicar un segundo test con otro 99% de eficacia, en cuyo caso ya sí que tendríamos una probabilidad del 99% de estar enfermos tras dar positivo en los dos.

Pero queda un problema, los test no son tan buenos ni de lejos, y la cosa es peor en las enfermedades más raras. Por ejemplo, los test para el cáncer de próstata tienen una eficacia del 60% como mucho. Una eficacia tan baja hace que incluso tras dar positivo en 4 test diferentes, la probabilidad de estar enfermo seguiría estando por debajo del 50%. Incluso las biopsias fallan, como muestra esta imagen:

El screening ha aumentado exponencialmente los diagnósticos por cáncer de mama, sin embargo la mortalidad se mantiene constante.

Por eso las pruebas son necesarias, pero sólo en los grupos de riesgo, porque de lo contrario estás sobretratando a montones de personas, ya que la probabilidad de dar positivo puede ser muy superior a la de estar enfermo, si analizas a gente de forma indiscriminada.

Amada y odiada pYa hemos comentado el uso de la p como umbral para las diferencias estadísticamente significativas. El problema es el valor de ese umbral. Ese umbral fue establecido por Ronald Fisher (quién la creó) en 0,05, un valor arbitrario que consideraba adecuado. El problema es que los requisitos y la forma de interpretarlo que estableció se han diluido y se ha pasado a utilizar de forma maniquea, sólo existe lo significativo y lo que no.

Uno de estos requisitos es que el estudio tenga potencia estadística suficiente, es decir, suficiente muestra. Gran parte de los estudios no la tienen, por razones de recursos económicos o humanos. Si se combina con un valor de p de 0,05, el resultado es un aumento grande de los falsos positivos. Por este motivo han surgido varias voces para cambiar este umbral a un valor más conservador, como 0,005. Por ejemplo en este artículo de Nature del año pasado:

https://www.nature.com/articles/s41562%20017%200189%20zYo le veo varios problemas. Primero, veo más sencillo que la gente adopte cosas nuevas (intervalos de confianza) que cambiarle un hábito con el que lleva trabajando toda su vida. Segundo y principal, como comenté con los intervalos de confianza, un nuevo umbral sigue sin aportarte información del tamaño del efecto, su precisión y su relevancia clínica, cosa que puedes tener con los intervalos de confianza y el valor de p antiguo. El tercero es que disminuir el valor de p, disminuye el error de tipo I (falso positivo), pero aumenta el tipo II (falso negativo). En medicina se considera preferible invertir en un campo que después se muestre como callejón sin salida, que dejar de explorarlo por un resultado negativo inicial.

Resumiendo, aún con lo que dice Nature, considero preferible utilizar intervalos de confianza y cálculo del tamaño muestral, que variar el valor de p.

Perdón por el tochaco. tl;dr, ni con tus ojos a partir de esta línea.

.

.

:

:

. Además, es la única forma de tener conocimiento con base sobre algo y con la tontería de modas que han llegado últimamente pues...

. Además, es la única forma de tener conocimiento con base sobre algo y con la tontería de modas que han llegado últimamente pues.... Además, es la única forma de tener conocimiento con base sobre algo y con la tontería de modas que han llegado últimamente pues...

No acabo de entender muy bien lo de la p.![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

![calabaza [hallow]](/images/smilies/nuevos/hallowen.gif)

![demoniaco [sati]](/images/smilies/nuevos2/demonio.gif)

![calabaza [hallow]](/images/smilies/nuevos/hallowen.gif)

![brindis [beer]](/images/smilies/nuevos2/brindando.gif) . ¡Y gracias por el currele!

. ¡Y gracias por el currele! ![brindis [beer]](/images/smilies/nuevos2/brindando.gif) me viene bien para estudiar Epidemiología y repasar, que a mi esto sí me toca estudiarlo.

me viene bien para estudiar Epidemiología y repasar, que a mi esto sí me toca estudiarlo.

![calabaza [hallow]](/images/smilies/nuevos/hallowen.gif)

![calabaza [hallow]](/images/smilies/nuevos/hallowen.gif)

![demoniaco [sati]](/images/smilies/nuevos2/demonio.gif)

![demoniaco [sati]](/images/smilies/nuevos2/demonio.gif) Sobre las ciencias sociales, no he dicho que no apliquen el método científico, pero en ocasiones sí es cierto que no lo hacen.

Sobre las ciencias sociales, no he dicho que no apliquen el método científico, pero en ocasiones sí es cierto que no lo hacen. podrías hasta empeorar la situación. Tampoco es que esté en contra pero se debería indicar que se desconoce si funciona. Pero claro, no venderían tanto...

podrías hasta empeorar la situación. Tampoco es que esté en contra pero se debería indicar que se desconoce si funciona. Pero claro, no venderían tanto... ![demoniaco [sati]](/images/smilies/nuevos2/demonio.gif) Sobre las ciencias sociales, no he dicho que no apliquen el método científico, pero en ocasiones sí es cierto que no lo hacen.

Sobre las ciencias sociales, no he dicho que no apliquen el método científico, pero en ocasiones sí es cierto que no lo hacen.podrías hasta empeorar la situación. Tampoco es que esté en contra pero se debería indicar que se desconoce si funciona. Pero claro, no venderían tanto...

![demoniaco [sati]](/images/smilies/nuevos2/demonio.gif)

podrías hasta empeorar la situación. Tampoco es que esté en contra pero se debería indicar que se desconoce si funciona. Pero claro, no venderían tanto...