Elelegido escribió:@dark_hunter Gracias por el análisis!

Creo que el estudio está publicado precisamente por ser de psicología social, y no de medicina. Dejando al margen otros posibles fallos del estudio, en los que no me meto, entiendo que sea normal que los parámetros estadísticos se interpreten de diferentes maneras en diferentes disciplinas.

En verdad no, cuando se estudia metodología, dentro de un mismo diseño de estudio, se aplican los mismos análisis en cualquier disciplina, esa es la gracia. El motivo es que la metodología la diseñaron por un lado psicólogos (sí, la mayor parte de diseños de estudio utilizados en medicina se inventaron para psicología, incluido el metanálisis) pero principalmente estadistas, y a los estadistas les da igual con lo que estés trabajando.

Lo que cambia entre disciplinas son las variables (en este caso psicopatía y liderazgo). De hecho si no fuera así no habría podido leer el artículo porque no lo habría entendido, pero los test que utilizan son los mismos que con los que estoy familiarizado.

Sin ser un entendido en ambas materias, me da a mi que la medicina es una ciencia bastante más exacta que la psicología social. Curiosamente, he encontrado

noticias de una revista de psicología social aplicada que ha baneado estudios en base a 'p' por ser demasiado maleables.

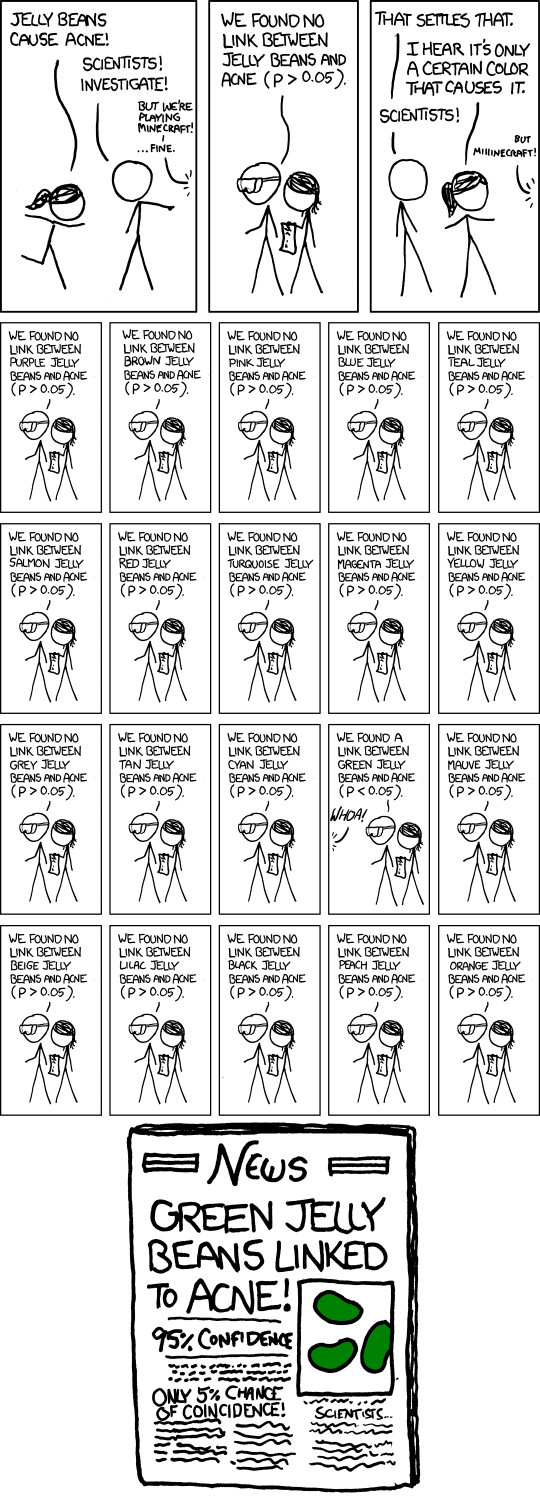

Exacto, por eso la crítica que hacía de xkcd y el comentario a las correcciones de la p y los intervalos de confianza, que son mucho más robustos que la p.

EDIT: por cierto, lo de esa revista es como decir "los antrirretrovirales no curan el VIH, eliminemos los antiretrovirales". El contraste de hipótesis funciona, lo que pasa es que hacer ciencia de forma correcta no es fácil y durante décadas se ha metido gente a investigar sin tener ni idea. Los primeros catedráticos que vivieron la MBE se metieron a investigar sin apenas formación sobre el tema, era jugar a ser científicos. Que las cátedras se hereden y que haya que recurrir a cursos privados para recibir una formación correcta sobre el tema, no ayuda.

Pero para eso están los revisores, para comprobar que el análisis estadístico utilizado es correcto. Otra cosa es que los revisores tampoco tuvieran ni idea, que vista la exposición de motivos para retirar la p por completo, parece que así sea.

Con esto no digo estar invalidando tu argumento. Pero mantengo cierto escepticismo que parte de la forma en la que sacas conclusiones bastante categóricas de esos datos, y por el hecho de que he visto ciertos investigadores verificados comentando este estudio en reddit/r/science desde una perspectiva bastante menos crítica. También reconozco, que yo tengo el sesgo de que siempre he pensado que el enlace entre la psicopatía y la alta jerarquía existe. Y tampoco me extraña que haya asimetría entre géneros.

Yo también pienso que ese enlace existe, si utilizas el buscador verás que lo he comentado varias veces por este foro. Pero si somos objetivos, este estudio no vale para confirmarlo, en ciertos apartados incluso valdría para desmentirlo.

Sobre lo otro, por desgracia la formación en metodología es un bien escaso, también entre gente investigadora, pues no te piden en ningún lado que sepas de metodología para investigar, mientras cuele el artículo...

Igual he sido demasiado lacónico, te explico a qué me refiero e igual así coincidimos en que es importante estudiarlo:

- Análisis del sesgo: es una de las partes más importantes de una revisión junto con la recomendación de la evidencia. Verás que cada conclusión en una revisión decente comienza por: "existe evidencia de alto/bajo riesgo de sesgo que ofrece una recomendación de la evidencia alta/moderada/baja" precisamente para contrarrestar lo de que siempre vas a encontrar que un estudio dice lo contrario o que los estudios sean de muy mala metodología. Aquí tienes las dos herramientas más desarrolladas que existen, RoB para ensayos clínicos, ROBINS-I para todos los demás excepto revisiones y metanálisis:

https://sites.google.com/site/riskofbiastool/Se analiza si la aleatorización fue correcta, si se ocultó la asignación, si los pacientes o los que realizaron las mediciones eran conscientes del tratamiento recibido (cegamiento), si las variables que se midieron se correspondían con lo que se está analizando, si se perdieron pacientes y se hizo algún análisis para contrarrestarlo, si se realizó cherry picking entre los análisis o forma de medir los datos... cosas que por sí solas pueden explicar las diferencias encontradas en el estudio.

Para el caso de los metanálisis existe este otro:

https://amstar.ca/index.phpQue es el que utilicé más arriba.

- Hablaba también de la heterogeneidad: la heterogeneidad se mide con el I2 (hay muchos otros estadísticos, pero este es el más efectivo). Básicamente consiste en analizar si los datos entre distintos estudios son consistentes entre sí, porque de lo contrario, lo que indica es que se estaban midiendo cosas diferentes, por lo tanto no deberías haber realizado un metanálisis. Se considera que existe heterogeneidad a partir de un valor del 25% de I2, pero es que en este metanálisis simplemente no analizaron la heterogeneidad, por lo tanto cualquier estudio díscolo les pudo alterar los datos, especialmente cuando las diferencias eran tan pequeñas.

https://www.cienciasinseso.com/tag/i2/En cualquier caso, espero que salgan más estudios sobre este área

Yo también y ojo, no estoy diciendo que lo que dice este estudio no sea verdad, sólo digo que es una patata, por lo tanto estamos casi igual que antes de que existiera (incluso peor, por el alto riesgo de sesgo). Pero por poder, podría haber acertado de chiripa.