.

Información

Ampere es el nombre en clave de una microarquitectura de unidad de procesamiento de gráficos (GPU) desarrollada por Nvidia como sucesora de la arquitectura Turing, anunciada oficialmente el 20 de Septiembre de 2018. Así mismo en la gama profesional (Tesla) sustituye a la serie Volta, presentada el 14 de mayo de 2020. Lleva el nombre del matemático y físico francés André-Marie Ampère. Nvidia ha programado el anuncio de las GPU de consumo de la serie GeForce 3000 de próxima generación en un evento especial que se retransmitió por streaming de manera global el 1 de septiembre de 2020 por el canal oficial de Twitch y Youtube (ver vídeo de presentación en el apartado Vídeos).

Nvidia Ampere RTX 3090

| Diseño | Información | Especificaciones Básicas |

| |

|

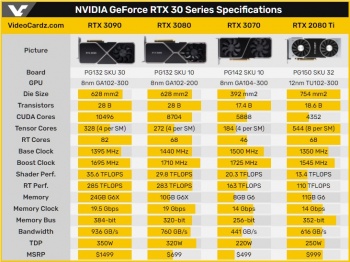

GPU Architecture GA102-300 Cuda Cores 10496 Boost Clock 1,70 Frame Buffer 384 bit Memoria 24GB GDDR6X Potencia de la tarjeta gráfica (W) 350 Potencia recomendada para el sistema (W) 750 Conectores de alimentación 2x 8pin Dimensiones (313x138)mm 3 Slots |

Nvidia Ampere RTX 3080

| Diseño | Información | Especificaciones Básicas |

| |

|

GPU Architecture GA102-200 Cuda Cores 8704 Boost Clock 1,71 Frame Buffer 320 bit Memoria 10GB GDDR6X Potencia de la tarjeta gráfica (W) 320 Potencia recomendada para el sistema (W) 750 Conectores de alimentación 2x 8pin Dimensiones (285x112)mm 2 Slots |

Nvidia Ampere RTX 3070

| Diseño | Información | Especificaciones Básicas |

| |

|

GPU Architecture GA104-300 Cuda Cores 5888 Boost Clock 1,73 Frame Buffer 256 bit Memoria 8GB GDDR6 Potencia de la tarjeta gráfica (W) 220 Potencia recomendada para el sistema (W) 650 Conectores de alimentación 1x 8pin Dimensiones (242x112)mm 2 Slots |

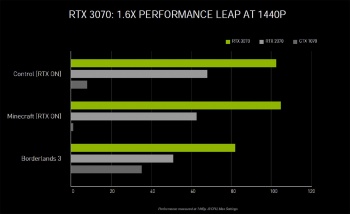

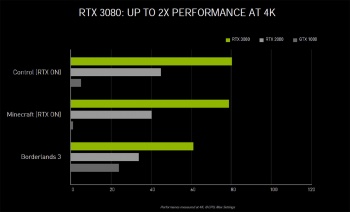

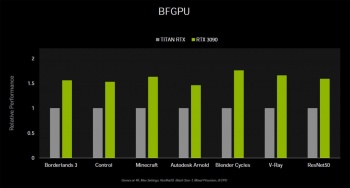

- NVIDIA ha confirmado las cifras de rendimiento esperadas para sus nuevos modelos RTX Ampere. Estas son cifras oficiales basadas en pruebas internas de NVIDIA, que probablemente hay que tomarse con cautela. Sin embargo, las diapositivas muestran lo que la compañía espera de las próximas GeForce Serie 3000 y dónde debería ubicarse cada una en las tablas de comparación.

|

|

|

Rendimiento oficial de NVIDIA RTX 3000 (según NVIDIA)

|

|

|

Características

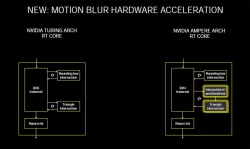

RT Cores

- La serie NVIDIA GeForce RTX 3000 presenta núcleos RT de segunda generación, lo que mejora aún más la aceleración del trazado de rayos. Los núcleos NVIDIA RT tienen una jerarquía de volumen delimitadora pura basada en hardware (BVH) que mejora en gran medida el rendimiento en comparación con el enfoque tradicional y minimalista con los procesadores de flujo SIMD.

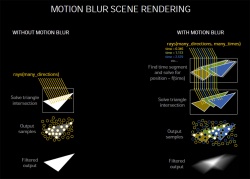

- El núcleo Ampere RT de segunda generación agrega un componente de interpolación triangular a lo largo de una escala de tiempo, en coordinación con la unidad de intersección del triángulo a la arquitectura del núcleo RT. Según NVIDIA, esto debería ser útil durante los efectos de desenfoque de movimiento en el trazado de rayos en tiempo real.

- https://www.nvidia.com/es-es/geforce/graphics-cards/30-series/?nvid=nv-int-cwmfg-60822#cid=gf73_nv-int-cwmfg_es-es

|

|

|

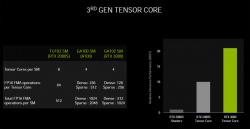

Tensor Cores

- Un núcleo Tensor de tercera generación copia en gran medida el diseño del (antes conocido como Tesla) A100 Accelerator. Este núcleo aumentará el rendimiento durante el aumento de escala de súper resolución DLSS AI en juegos.

- Los tensores de Ampere están diseñados para aprovechar la escasez de redes neuronales de aprendizaje profundo. Este es un proceso de reducción de matrices sin afectar su precisión. Este proceso puede mejorar el rendimiento de la IA en un orden de magnitud.

|

|

PCB NVIDIA GA102

| PCB de la serie 3000 | |||||

|---|---|---|---|---|---|

| |||||

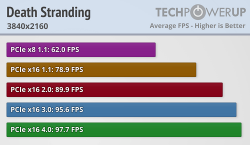

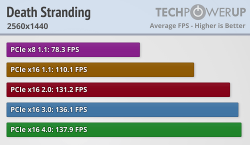

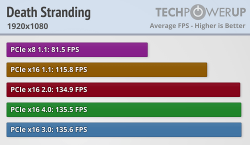

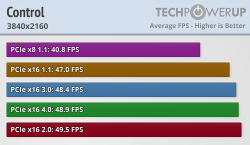

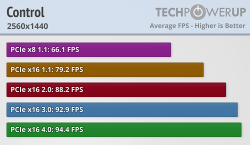

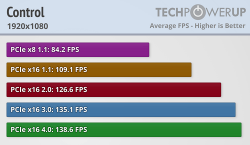

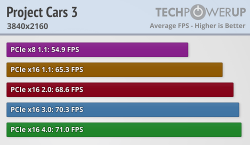

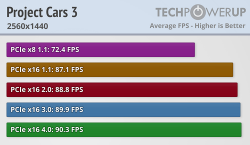

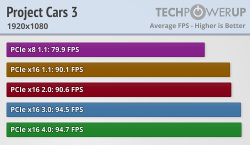

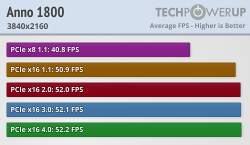

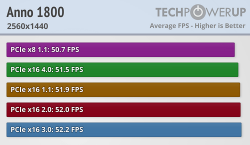

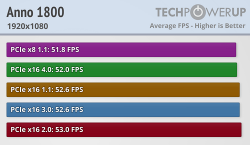

Impacto de la RTX 3080 en versiones PCIE a diferentes resoluciones

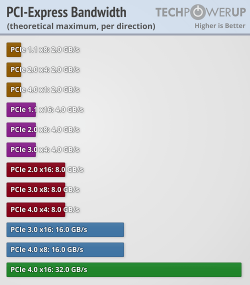

- Desde techpowerup tenemos este estudio que analiza como impacta al rendimiento de la nueva RTX 3080 sobre diferentes versiones del bus PCIE y a diferentes resoluciones. Para ello usaron diferentes anchos de banda; segun la version de PCIE, y diferentes motores graficos, desde los que son mas CPU dependientes, hasta lo que estan mas optimizados al GPU, motores de hace algunos años a motores mas recientes.

- Las velocidades que se alcanzan en cada version de PCIE [ 1.1, 2, 3 y 4], junto con el numero de LANES [16lanes, 8lanes y 4lanes]

https://www.techpowerup.com/review/nvidia-geforce-rtx-3080-pci-express-scaling

|

|

|

|

|

|

|

|

|

|

|

|

|

FAQ (Respuestas por parte de Técnicos nVidia)

- Especificaciones de HDMI 2.1

GhostMotley – ¿Ampere admite HDMI 2.1 con el ancho de banda completo de 48 Gbps?

[Qi Lin]: Sí. La arquitectura NVIDIA Ampere admite la velocidad de enlace HDMI 2.1 más alta de 12 Gbs / carril en los 4 carriles, y también admite Display Stream Compression (DSC) para poder alimentar hasta 8K, 60Hz en HDR.

- Requisito de SSD para Ampere

Pengwin17523 – ¿Habrá un cierto requisito de velocidad de SSD para RTX I / O?

[Tony Tamasi]: No hay un requisito de velocidad SSD para RTX IO, pero obviamente, los SSD más rápidos, como la última generación de SSD Gen4 NVMe, producirán mejores resultados, lo que significa tiempos de carga más rápidos y la capacidad de los juegos para transmitir más datos al mundo. dinámicamente. Algunos juegos pueden tener requisitos mínimos para el rendimiento de SSD en el futuro, pero los desarrolladores de juegos los determinarán. RTX IO acelerará el rendimiento de SSD independientemente de lo rápido que sea, al reducir la carga de CPU requerida para E/S y al habilitar la descompresión basada en GPU, permitiendo que los activos del juego se almacenen en un formato comprimido y descargando potencialmente docenas de núcleos de CPU de haciendo ese trabajo. Las relaciones de compresión suelen ser de 2: 1, por lo que amplificarían de manera efectiva el rendimiento de lectura de cualquier SSD en 2x.

- RTX IO

SBMS-A-Man108 – ¿RTX IO permite el uso de espacio SSD como VRAM? ¿O lo estoy entendiendo completamente mal?

[Tony Tamasi]: RTX IO permite leer datos de SSD a una velocidad mucho mayor que los métodos tradicionales, y permite que la GPU almacene y lea los datos en un formato comprimido, para su descompresión y uso por parte de la GPU. No permite que el SSD reemplace la memoria del búfer de cuadros, pero permite que los datos del SSD lleguen a la GPU y a la memoria de la GPU mucho más rápido, con mucha menos sobrecarga de CPU.

Aztec47 – ¿Podríamos ver que RTX IO llegará a bibliotecas de aprendizaje automático como Pytorch? Esto sería excelente para el rendimiento en aplicaciones en tiempo real.

[Tony Tamasi]: NVIDIA entregó soluciones de E/S de alta velocidad para una variedad de plataformas de análisis de datos hace aproximadamente un año con NVIDIA GPU DirectStorage. Proporciona E / S de alta velocidad entre la GPU y el almacenamiento, específicamente para cargas de trabajo y aplicaciones de tipo AI y HPC. Para obtener más información, consulte: https://developer.nvidia.com/blog/gpudirect-storage/

Qrios1ty – Estoy emocionado por la función de I/O RTX, pero parcialmente no entiendo cómo funciona exactamente.

[Tony Tamasi]: RTX IO y DirectStorage requerirán aplicaciones que admitan esas características mediante la incorporación de las nuevas API. Microsoft tiene como objetivo una vista previa de DirectStorage para Windows para desarrolladores de juegos el próximo año, y los jugadores de NVIDIA RTX podrán aprovechar los juegos mejorados RTX IO tan pronto como estén disponibles.

- PCI-Express 3.0 frente a 4.0

Invitado – ¿PCIe 3.0 producirá un cuello de botella en el RTX 3090? Estoy preocupado ya que mi sistema Intel no es compatible con 4.0.

[Tony Tamasi]: el rendimiento del sistema se ve afectado por muchos factores y el impacto varía entre aplicaciones. El impacto suele ser inferior a un pequeño porcentaje al pasar de un PCIE 4.0 x16 a un PCIE 3.0 x16. La selección de CPU a menudo tiene un mayor impacto en el rendimiento. Esperamos nuevas plataformas que puedan aprovechar al máximo las capacidades de Gen4 para posibles aumentos de rendimiento.

- GeForce RTX 3070

tldrdoto – ¿Podrías aclarar si la diapositiva que dice que RTX 3070 es igual o más rápido que 2080 Ti se refiere a la rasterización tradicional o cargas de trabajo DLSS/RT? Ya que no se mostraron puntos de referencia de rasterización tradicionales, solo juegos compatibles con RT/DLSS.

[Justin Walker]: Estamos hablando de ambos. Juegos que solo admiten la rasterización tradicional y juegos que admiten RTX (RT + DLSS). Puede ver esto en nuestro artículo de lanzamiento aquí https://www.nvidia.com/en-us/geforce/news/introducing-rtx-30-series-graphics-cards/

- DLSS 2.1

EeK09 – ¿Qué tipo de avances podemos esperar de DLSS? La mayoría de la gente esperaba un DLSS 3.0 o, al menos, algo como DLSS 2.1. ¿Seguirá mejorando DLSS y ofrecerá soporte para más juegos mientras mantiene la misma versión?

[NV-Randy]: DLSS SDK 2.1 está disponible e incluye tres actualizaciones: – Nuevo modo de ultra rendimiento para juegos de 8K. Ofrece juegos de 8K en GeForce RTX 3090 con una nueva opción de escala de 9x. – Soporte de realidad virtual. DLSS ahora es compatible con títulos de realidad virtual. – Soporte de resolución dinámica. El búfer de entrada puede cambiar las dimensiones de un marco a otro mientras el tamaño de salida permanece fijo. Si el motor de renderizado admite la resolución dinámica, DLSS se puede utilizar para realizar la ampliación requerida a la resolución de pantalla.

- Conectores PCIe

Halógeno19 – ¿Qué tan malo sería usar una RTX 3080 con un conector PCIe dividido en lugar de dos cables separados. ¿Sería potencialmente peligroso para el sistema si no hago overclocking?

[NV_Tim]: La recomendación es ejecutar dos cables individuales. Aquí hay un diagrama. https://www.nvidia.com/en-us/geforce/graphics-cards/30-series/rtx-3080/?nvmid=systemcomp

- Codificador RTX

Carmen813 – ¿Habrá alguna mejora en el codificador RTX en las tarjetas de la serie Ampere, similar a lo que vimos para el lanzamiento de Turing? Vi información sobre el software Broadcast, pero estoy pensando más en mejorar la calidad general de la imagen con la misma tasa de bits.

[Jason Paul]: Para la Serie RTX 30, decidimos enfocar las mejoras en el lado de la decodificación de vídeo y agregamos soporte para decodificación AV1. En el lado de la codificación, la serie RTX 30 tiene el mismo gran codificador que nuestra GPU de la serie RTX 20. También hemos actualizado recientemente nuestro NVIDIA Encoder SDK. En los próximos meses, las aplicaciones de transmisión en vivo se actualizarán a esta nueva versión del SDK, lo que desbloqueará nuevas opciones de rendimiento para los transmisores.

- NVIDIA Reflex

Akanash94 - ¿Nvidia reflex funcionará con GPU pascal o es solo una función de Turing / Ampere?

[NV_Tim]: Funcionará con la serie 900+ GPU, incluida la serie RTX 20.

- Diseño del cooler y flujo de aire

iCinn – ¿Alguna idea de si el diseño de flujo de aire dual se estropeará para los chasis invertidos? ¿Más que diseños anteriores? Parece que tirará aire al CPU, pero el cooler del CPU aún lo sacaría del chasis. Quizás no sea tan malo. Otra pregunta sería... Dicen que es 10 veces más silenciosa la 3090 que la Titan ¿es más o menos más silencioso que un 2080 Super (Evga Ultra FX, por ejemplo)?

[Qi Lin]: u / iCinn El nuevo diseño de flujo a través de refrigeración funcionará muy bien siempre que los ventiladores del chasis estén configurados para llevar aire fresco a la GPU y luego muevan el aire que fluye a través de la GPU fuera del chasis. No importa si el chasis está invertido. La Founders Edition RTX 3090 es más silenciosa que la Titan RTX y la RTX 2080 Super Founders Edition. No lo hemos probado con diseños de partners específicos, pero creo que quedará impresionado con lo que escuchas … o mejor dicho, lo que no escuchas. 🙂

Modelos Custom Nvidia 3000

Drivers para Nvidia 3000

- Próximamente*

Imágenes

- Próximamente*

Noticias

- https://videocardz.com/newz/nvidia-details-geforce-rtx-30-ampere-architecture

- https://www.pcmrace.com/2020/09/03/nvidia-brinda-mas-detalles-sobre-dlss-2-1-rtx-io-y-requerimiento-de-ssd-hdmi-2-1-pcie-4-0-reflex-y-mas/

Vídeos

- nVidia : Presentación RTX 3000 Ampere https://www.youtube.com/watch?v=E98hC9e__Xs

- nVidia : 4K Doom Eternal RTX 2080 Ti Vs RTX 3080 https://www.youtube.com/watch?v=A7nYy7ZucxM

- nVidia : Como se hizo la demo técnica Marble https://www.youtube.com/watch?v=hsRcahyojtA

- HW 360 : Explicación significados datos presentación Ampere https://www.youtube.com/watch?v=oht4SmzUQ84

Historia de los últimos 8 años hasta llegar a la serie 3000

| ABRIR PARA LEER | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

Si hacemos un rápido repaso a como hemos llegado hasta aquí, podemos hablar de como la rivalidad nVidia Vs AMD ha hecho que hoy en día el mercado de GPU's se haya convertido en una constante evolución que parece no tener fin (al menos hasta que la ley de Moore llegue a su fin). Mediante tablas y gráficas intentaré transmitir desde mi punto de vista personal (es muy subjetivo, puede contener errores y/o puntos de vista muy subjetivos) como han evolucionado precios y rendimiento de la manera más visual posible. Vamos a ponernos en situación. Año 2012. Nvidia viene un poco regular con la serie 6. Sus 680 dan algunos problemillas de temperatura y AMD aprovecha la tirada de las Radeon HD hasta lo más último con dobles núcleos inclusive.

Entonces nVidia decide sacar la serie 700 junto a la Titan y consigue (esta vez sí) dejar atrás a AMD.

Pero claro, AMD reacciona y saca las series RX 200 y vuelve a ponerse algo por encima

Y como no... nVidia reacciona y saca la 780ti, pero para ese entonces AMD empieza a tener problemas de temperatura con las R9 290 y reacciona bajando precio y sacando revisiones de esta algo más potentes (exprimidas) que lo único que provocan es calentarse más aún.

A partir de aquí AMD toca techo y los problemas de calor le pasan factura. Se queda estancada y nVidia decide sacar la serie 900 Maxwell (que a la postre serían las que mejor calidad-precio-rendimiento traerían al mercado)

AMD solo le queda bajar sus precios mientras va puliendo los problemas de calentamiento limitando sus potencias y mejorando drivers.

Finalmente nvidia exprime la serie Maxwell con la 980ti y una nueva Titan X que dejan muy atrás a AMD que parece no tiene nada más que ofrecer, pues tardó algo más de lo deseable en presentar unas Rx 300 que defraudaron mucho (pues eran refritos de la serie RX 200 pero con menos problemas).

A partir de aquí AMD ya no reacciona y sigue en caída mientras nVidia se crece y saca la serie Pascal 1000

A lo que AMD apenas consigue hacer ruido con sus RX 400

Después de esto... AMD lo que hizo fue lanzar un refrito con las series RX 500 (que permitían como en series antiguas, modificar la bios de las gamas inferiores para que se transformasen en su nueva hermana mayor, una RX 480 podía pasar a ser una RX 580 con solo modificar la bios).

y AMD solo podía hacer algo con sus precios bajos, donde sus gráficas ofrecían los FPS más baratos.

Y un rendimiento decente por un bajo coste (eso sí, en gama alta nada de nada)

Con todo esto, nvidia solo debía preocuparse de sus gamas bajas, la 1050 y 1050 ti, junto con la 1060 eran las únicas que se veían afectadas por la competencia de AMD. Y con estas guisas, se plantaron al mundo con la serie Turing y unos precios de infarto (justificándolo con lo del Raytracing y ... mucho ojo a la subida de 300$ de la 2080ti desde su lanzamiento a solo unos meses después)

AMD contraatacó por fin con algo decente y su RDNA1 pasó a plantar cara a nvidia en su gama baja, media y casi alta, posteriormente sacó las revisiones XT que todavía ponían más carne en el asador

Por lo que nVidia le tocó reaccionar y sacar las versiones SUPER, bajando el precio de las originales normales

Y los rendimientos de todas estas tarjetas resultaron poner de manifiesto que AMD había vuelto, gracias a los 7nm y su bajo consumo, junto con un rendimiento / eficiencia decente, las temperaturas/rendiiento por Watt de AMD (rojo) por primera vez en siglos estaban empezando a recuperar terreno a nVidia (verde) que aún seguía por delante:

Empezó a levantar cabeza de manera oficial y las ventas en gama baja y media así lo demostraron, incluso la 5700XT que estaba entre una RTX 2070 / 2080 también vendió muy bien.

| ||||||||||||

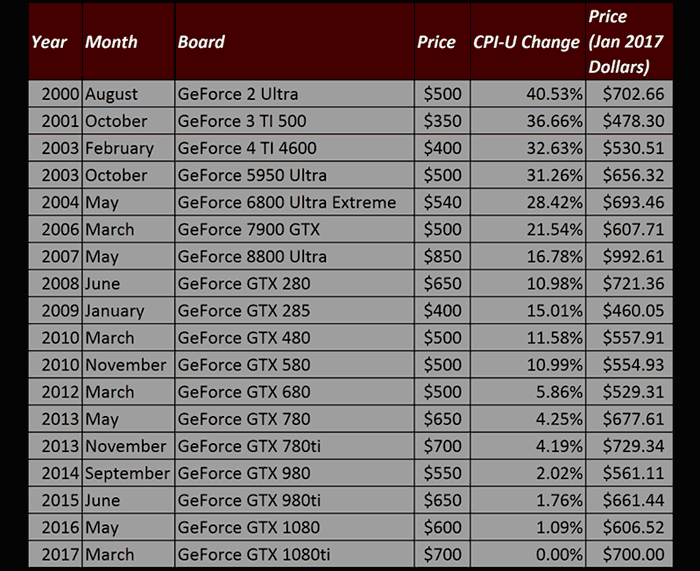

Análisis evolutivo de los precios de las GPU's

Voy a tratar de explicar de manera subjetiva (bajo mi prisma y de manera muy rápida, si hay algún error por favor notificar) como han ido evolucionando los precios de nVidia en los últimos 21 años.

| ABRIR PARA LEER | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

Nvidia empezó con la serie 1ª de Geforce 256 allá por 1999 con un precio recomendado de 300$ y en ese momento era la tarjeta TOP. Al poco empezó a inventar las "versiones" ti o super actuales, con las denominadas ultra (infladas de precio que llegaron a subir a los 800$) pero se comieron un mojón, por lo que gracias a ATI y que no cuajó esa estrategia (que por ese entonces a nVidia ya se le veía qué quería $$$) los precios se mantuvieron contenidos en la gama TOP de GPU's sobre los 400-600$ en los siguientes 10 años, Esto fue así hasta 2013 cuando nVidia como hemos dicho anteriormente empezó a cambiar de rumbo y a tomar el mando por completo de esta industria en lo que a gama alta / entusiasta se refiere. En 2010, nVidia presentaba las series Fermi, con la GTX 580 como la más top de por entonces que salió a 500$. En esa época AMD tenía las HD 6970 a 300$ que tenían un rendimiento algo inferior a la GTX580 en juegos pero casi a mitad de precio. La guinda de AMD y la mejor época para mí, vino a a partir de aquí. AMD presentó la HD 7970 al año siguiente y superaba la GTX 580 con un precio de salida de 550$. Nvidia sacó un refrito con las kepler GTX 680 que apenas conseguía superarla a 500$, pero AMD entonces rebajó su pepino a 420 con una revisión algo más rápida (ghz edition) que ponía en jaque a Nvidia porque en rendimiento de juegos iban a la par, en benchmarks casi que mejor la AMD (algunos igual, otros algo por debajo, pero otros muy por encima AMD)... pero todo eso con un precio inferior. Resalto este momento porque para mí fue el mejor de AMD (y trajo buenos calidad/precio tanto por parte de AMD como de Nvidia). Estamos hablando de gráficas mononúcleo por cierto. Hasta aquí habían sido 13 años de gráficas con subidas de rendimiento del doble y constante aumento en memoria... manteniendo precios entre los 400-500 dolares en casi todo momento (AMD sobre los 400 y Nvidia sobre los 500 mayormente). A partir de aquí entramos ya en un progreso hacia lo que es hoy día. Nvidia sacó la verdadera serie Kepler (en mi opinión, porque la 680 fue un refrito de Fermi) con la GTX780 a 650$ siendo solo un 20% más rápida que la 680... y presentó la GTX Titan por 1000$ que debería haber sido (para mi) la verdadera 780, pero así podía justificar su precio y desmarcarse más. La Titan era preciosa, un 33% más potente que la 680 y 6GB de RAM (Vs 2GB de la 680)... pero Nvidia se columpió en precio... 1000$!!! su excusa fue decir que era enfocada a serie gaming profesional, pero fue el principio de lo que hoy mucha gente acepta como normal, pero para mí... NUNCA lo será. 13 años de desarrollo a precios contenidos y de repente se duplica el precio por algo que venía siendo lo habitual... un 33% de rendimiento superior REAL (pues Nvidia alardeaba de ser un 75% superior por el número de Cores), pero un salto de 30% en rendimiento al mismo coste no era raro de ver entre generaciones, y solo los 6GB y la coletilla profesional trataban de justificar semejante navajazo. Se creó la idea de la gráfica para elitistas pudientes, la semilla que quedaría por siempre desgraciadamente porque esta vez SI, Nvidia consiguió su propósito. AMD contraatacó con la R9 290 a 550$. En teoría era superior a GTX 780 pero... calentitas como ellas solas y drivers y ... no siempre eran algo por encima. Nvidia no tardó mucho en reaccionar sacando la 780ti por 700$ (¡que incluso superaba a la titan que no hacía ni 1 año que había salido!) pero la idea de Nvidia de colocar GPUS a precios altos solo para unos pocos había llegado para quedarse, si bien la Titan no fue el mayor de los éxitos, la 780ti SI, pero a nuevo precio también, esos 700$ para la Ti no eran los 1000$ de la Titan, pero Nvidia tenía lo que quería. Hasta ahora las Ti solo se habían visto en gamas inferiores, como versiones mejoradas de lo ya sacado (como las super de la presente generación 20XX), llegadas como consecuencia de la necesidad impuesta por el mercado (la competencia de AMD mayormente). A partir de aquí ya la cosa se torció más y más... AMD apretó el acelerador con la R9 290X a 550$ bajando la R9 290 a 400$. Era un GPU aún más caliente y el desastre ya fue mayúsculo, recuerdo que habían RMA's a saco. El rendimiento estaba por encima de la 780, pero a pesar que prometían que iban a igualar la Titan... apenas superó la 780 y la R9 290, la realidad es que las R9 290 hubo que limitarlas por los problemas de temperaturas y el rendimiento se vio afectado. El precio lo dice todo, ellos bajaron precios, pero Nvidia no tuvo que retocar demasiado sus precios a partir de aquí. AMD había tocado techo y ya no podía crecer más en su camino por culpa de las limitaciones de calor. Lo que vino a partir de aquí fue la puntilla, Nvidia sacó las Maxwell y dejó a todos con la boca abierta, si la 780ti había sido una maravilla... que decir de casi todas las 9XX... la GTX 980 se presentó por 550$ siendo un 30% superior a la 780. Quizás Nvidia pensaba que AMD podría contraatacar... pero no lo hizo. Tardó casi 1 año en sacar la R9 390 por 330$ y 8GB de VRAM (Vs los 4GB de la 980) pero su rendimiento era... PLOF! era una especie de 290 pero menos caliente... SOLO un 8% mejor que la 290. Una caída dolorosa. Nvidia vio la caída y aprovechó el momento. Sacó en ese mismo momento una super máquina llamada RTX 980ti a 650$, dejó la GTX 970 a 400$ como rival de la 390 (a la que encima superaba, los de AMD solo podían argumentar los 8GB vs los 3,5 de la 970). Además volvió a sacar una Titan, la X por 1.000$ que solo superaba la 980ti por los 12GB de VRAM. Un sin sentido pagar 350$ más por una GPU que rinde igual solo por tener más VRAM, pero como no había competencia... A partir de aquí creo que ya todo el mundo conoce lo que ha pasado porque es lo reciente. Nvidia infló precios con una 1080 a 700$ y la Titan X Pascal a 1200$. AMD mientras con una vega que ni fu ni fa. Nvidia sacó la 1080ti a 800$, pero al final las 1080ti acabaron subiendo hasta los casi 1.000 porque no existía competencia alguna (el SLI se empezó a "quitar" de en medio para evitar que 2 gráficas baratas pudieran tumbar una de 1.000 como le pasó a Titan X superada por 2 GTX 970). Con estas guisas llegaron la RTX 2080 a 700$, la 2080 ti a 1200$ y la RTX Titan a 2.500$... Pero es que lo peor es que las gamas baja y media también subieron. Si la 1070 había salido a 400$ como su antecesora, la RTX 2070 se fue hasta los 600$, mientras la serie x60 evolucionó de los 200$ de la 960, a 250$ la 1060 y hasta los 350$ de la 2060. AMD forzó a Nvidia a sacar la serie Super al mismo precio de salida de las normales posteriormente (excepto la 2060 super que pasó a costar 399$) gracias a las 5500XT, 5600XT y 5700XT... que "rivalizaban" con la 2060, 2070 y 2080 respectivamente a menor coste. Con estos datos que cada uno juzgue por si mismo. Dentro de no demasiado dejaremos la rumorología y veremos que pasa, pero son muchos rumores que apuntan a que la XBox SX rondará los 550 y la ps5 los 500, por lo que no tiene demasiado sentido que una 3060 por si sola supere los 400. Casi casi la 3070 diría que tampoco tiene sentido que supere los 500 porque ya tuvo que rectificar los 600 que costó la 2070 y bajó la normal a 500 con la salida de la super, de hecho ahora mismo las 2070 super andan en los 470 y la normal los 390, lo que las sitúa de nuevo en su precio de mercado razonable, pues la GTX 970 fue la que subió el listón de la serie X70 a 400, la 1070 intentó subirlo pero tuvo que quedarse en esa franja y la 2070 de nuevo lo ha intentado y ha terminado volviendo a bajar a ese nivel. | ||||||||||||

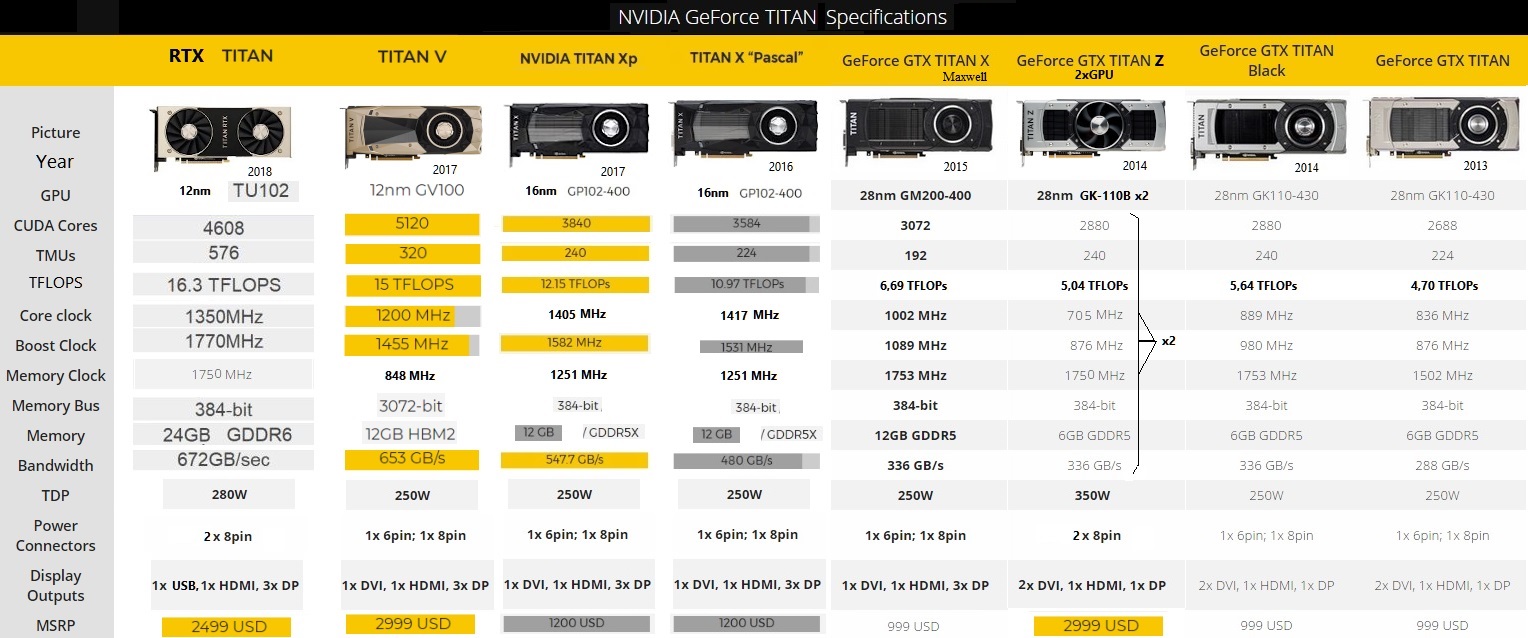

Modelos Titan, más allá de la gama entusiasta

| ABRIR PARA LEER | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

Tradicionalmente, los modelos especiales llamados Titan por nVidia, son unas tarjetas enfocadas a todo aquel que quiere tener lo más Top de lo Top y no solo enfocado a Gaming, ya que su gran cantidad de memoria VRAM la convierten en un candidato para tareas profesionales como Inteligencia Artificial o edición de imagen/video. Resumiendo se podría decir que la Titan viene a ser la "Todo en 1" orientada a gente que quiere tener en un mismo ordenador, su estación de trabajo, renders, edición de imagen, streaming y a la vez PC Gaming. Estas series Titan suelen durar unos 2 años en lo más alto a un precio solo al alcance de los más pudientes. Normalmente, al cabo de un tiempo nVidia suele sacar un modelo una Ti que la iguala en rendimiento en Gaming pero con algo menos de VRAM (y quizás inferior también en otras características). Por ejemplo el precio de una GTX 980 Ti era de 650$ e igualaba una TitanX (Maxwell) lanzada solo unos meses antes por 1000$. La GTX 980ti solo tenía 6 GB Vs los 12 de la Titan, pero al lanzar la GTX 1080ti con 11GB volvimos a tener la misma situación, incluso con una VRAM casi idéntica, la GTX 1080 ti igualaba a la TitanXP en rendimiento y casi la misma RAM, eso si, el precio eran 800 Vs los 1200 de la Titan XP. Acto seguido por supuesto nVidia volivó a sacar una titan más potente que hiciera merecer la pena no comprar la 1080ti en su lugar para los más elitistas, si querías lo top ahora tenías que ir a por una Titan V de 3000$ con sus 12GB HBM2 ultrarápidos (y caros, aunque no para tanto, AMD lo demostró lanzando gráficas con HBM2 a un precio que podría considerarse "normal" como fueron Vega64 y RadeonVII). Esas memorias no resultaron ser tan interesantes y por eso en la siguiente serie tanto Nvidia con las RTX como AMD con las 5000XT prefirieron la memoria GDDR6 en lugar de la HBM2. Después se lanzó la RTX titan a 2499 y al llegar la gama Ampere, la RTX 3090 se postuló en una candidata a ocupar el puesto de la RTX Titan, con los 24GB de VRAM (como la RTX Titan). Queda por ver si nVidia continuará o no la serie Titan con Ampere (¿una posible Titan RTX2?) con un supuesto precio más aún de infarto para el que la quiera claro. Aquí se puede ver el detalle de todos los modelos, características, fechas de lanzamiento, etc etc [1] Aquí una tabla de precios comparativos desde 2009 hasta 2017 con su respectivo cálculo de inflación del modelo más caro o de mayor rendimiento de cada año, teniendo en cuenta que la Titan fue lanzada a partir de 2013: Y aquí una tabla comparativa de TODAS las TITAN con los precios históricos de lanzamiento y demás:

| ||||||||||||