Lobeznoviejo1982 escribió:.Todas estas tecnologías son increíbles, pero como muchas otras, se quedarán olvidadas pues realmente no hay demanda, desde hace años (fuera de convenciones específicas), nos llevan hablando de tecnologías increíbles casi de ciencia ficción, y siempre se quedan en intentos, betas, demos, pruebas "controladas" y prototipos que jamás se vuelven comerciales.

La IA como tal, lo que está revolucionando NVIDIA desde hace cuatro días es algo completamente nuevo, estamos viendo su nacimiento, estamos casi como en la época cuando casi nadie tenía teléfonos móviles y los cuatro gatos que los tenían eran personas con alto poder adquisitivo y eran cacharros enormes que pesaban como una piedra.

La IA a día de hoy tiene aplicaciones prácticas, muchas empresas están implementado departamentos de deep learning para usar sus datos para entrar IAs como es el caso de arriba que puse de Guerrilla, otras empresas contratan a empresas que han desarrollado IAs para usarlas en el desarrollo de sus juegos, esto no ha hecho más que empezar, aún no hemos visto IAs que interactúen directamente en los juegos con otros jugadores salvo alguna prueba que se hizo con dota que solo tenía un objetivo de probar la competitividad frente a un humano, al principio solo se buscarán IAs que faciliten el desarrollo de los juegos, quizás alguna empresa vaya más allá de eso y nos sorprenda.

Yo no creo que seas consciente de la infinidad de herramientas que están apareciendo y que incluso van a reemplazar a los humanos que ahora trabajan como chinos en el desarrollo de videojuegos.

Lobeznoviejo1982 escribió:Tristemente, a la gente solo le interesa (más bien les obsesiona hasta el absurdo) la calidad gráfica, 4k, 8k, Ray tracing, PS5 etc, algo realmente ridículo, ya que con televisiones de 50' y full HD todo se ve perfecto, es meramente una cuestión de postureo y de la obsesión enfermiza de la calidad visual.

A mi me interesa mucho la calidad gráfica en los juegos, para mi es muy importante, yo juego en 4K en una pantalla de 55 pulgadas y te puedo asegurar que la definición que ofrece el 4K no la ofrece el 1080p, es el doble de píxeles, igual que 30 fps no son 60 fps ni de coña. Negar eso me parece un poco absurdo, sería como decir que un juego de PS3 se ve igual que uno de PS4, que son lo mismo y que no hacen falta juegos como los de PS4

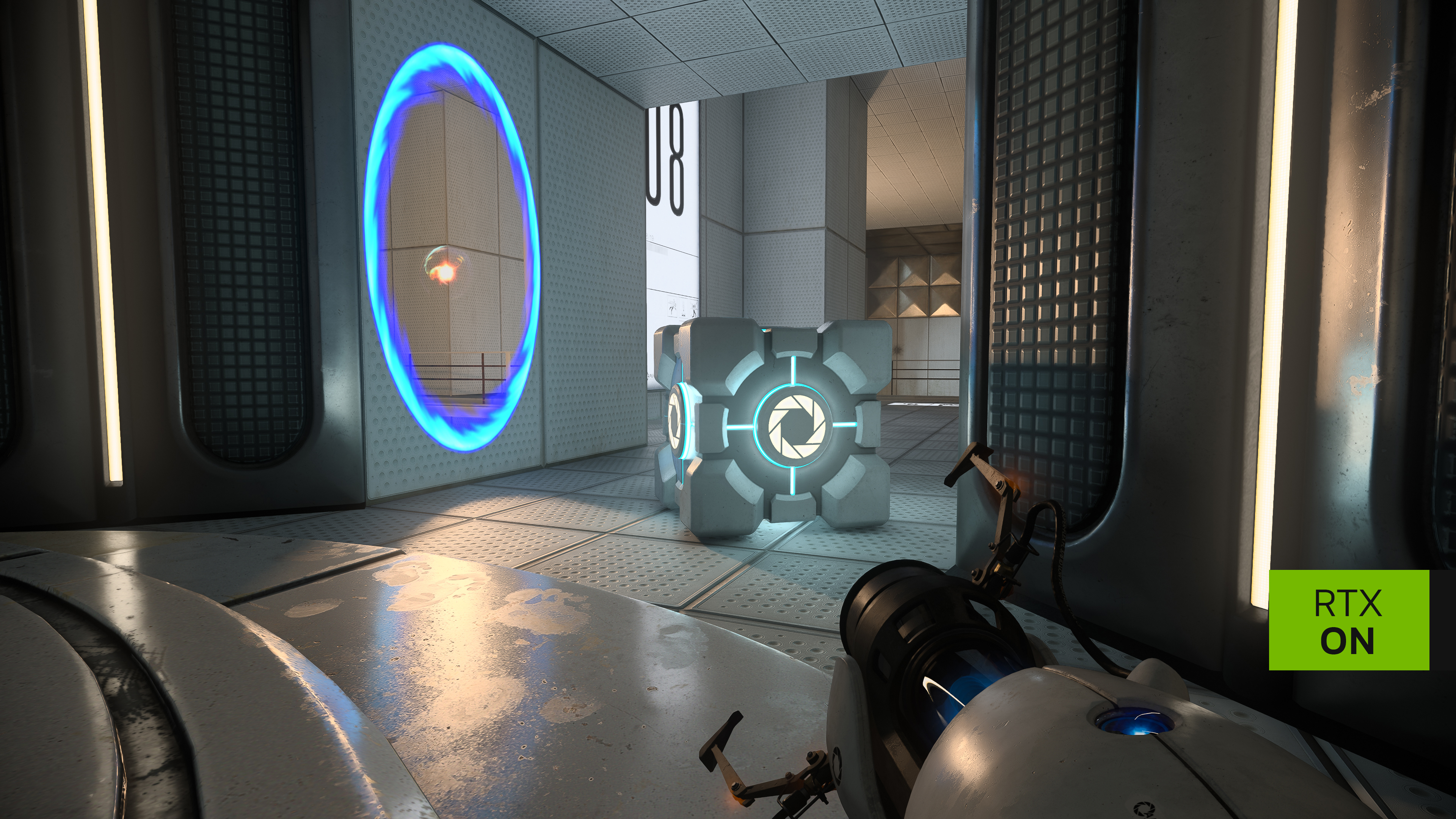

Igual que una iluminación por raytracing es muchísimo mejor, igual que un sonido tridimensional basado en la misma tecnología del raytracing podría revolucionar el sonido en los videojuegos, imagínate que hasta los materiales de cada juego tuvieran coeficientes de absorción y de refracción, montarte en un coche con un NPC y tener que subir la ventanilla para que no se escuche nada de lo que dices, ponerte en un cañón de RDR y gritar y que desde el otro lado otra persona escuche el grito.

El sonido posicional en los juegos, cuando hablas, es horrible, necesita un cambio radical ya, y más si vamos a tener una revolución de interacción con NPCs con los que podremos hablar como si fuesen personas reales.

Por otra parte, la IA traerá el realismo mediante filtros durante esta década, ya hemos visto herramientas reales DeepFaceLive que están al alcance de cualquiera que tenga una RTX.

Lobeznoviejo1982 escribió:Globalmente hablando, aunque solo fuese 1 entre 100 (por la calle, en tiendas, transportes publicos etc), ¿donde veis a personas manejar dispositivos holograficos?, ¿donde veis coches sin conductor?, ¿donde veis (fuera de japon), robots o androides serios (bipedos, estilizados y con pies, no con ruedas)?...

Yo no creo que hayan muchos dispositivos holográficos, a no ser que uses gafas de realidad aumentada/mixta, y precisamente no cuestan poco, además que es una tecnología aún bastante verde, muchísimo más que la VR que ya de por si es cara pero que ha mejorado mucho la tecnología y sus precios, aunque es cierto que cada vez está más presente y en parte el futuro de los videojuegos pasa por ahí, en un futuro la realidad mixta será un boom por el componente social, podrás jugar con amigos en la calle, en la escuela, entre otras muchas cosas como usar un ordenador a través de las gafas sin necesidad de llevar un muerto encima con pantalla, ir andando por la calle y ver proyectado en el suelo un avatar de un perrito que le habla a tu hijo.

Yo no creo que veas muchos robots en muchos sitios, hace dos días Elon Musk presentó un robot bípedo humano que ni andaba, prometió que andaría, no es algo que aún se haya cumplido, no existen esos robots bípedos estilizados que yo sepa.

Además, el tema de los robots es delicado, mucho más que el enfoque que se le da a la IA en este hilo, los robots son físicos y pueden hacer daño físico, ya sea porque se cruzan en una carretera, o porque le puede caer el bicho de metal encima de un crio, que repito, no existen los robots humanoides autónomos y estilizados, que anden sin ayuda y lo hagan de forma fluida; los que hay no tienen mucha utilidad, además que los robots humanoides no son útiles, para eso desarrollamos robots con formas precisas para desarrollar tareas concretas que no requieren de aspecto humanoide.

¿Necesitas un robot con forma humana que conduzca un coche cuando lo puede hacer una IA perfectamente sin necesidad de un piloto humanoide que ocupe espacio y gaste energía? No tienen ningún sentido, pues lo mismo con infinidad de actividades.

Los coches autónomos existen, son una jodida realidad y a día de hoy se están comercializando, te puedes encontrar uno perfectamente, el problema es que empresas como Tesla ofrecen productos que solo son accesibles para personas con alto poder adquisitivo, luego está el tema de recargarlos, de que no hay suficiente infraestructura en muchos países, lo cual no los convierte en una opción agradable para muchos usuarios, pero son el futuro porque reducirán al mínimo los accidentes de tráfico, incluso reducirán la delincuencia porque nadie se podrá dar a la fuga, por lo menos no con un coche.

Luego hay empresas como comma, el propietario de esa empresa es el que hackeó la PS3 y los primeros iphones, pues este tío ha creado un dispositivo que permite que la gran mayoría de coches puedan funcionar con autopiloto, es un paso a que el autopiloto deje de ser algo único de los teslas, que muchas otras marcas pasen a implementarlo, hoy en día puedes comprar su dispositivo e instalarlo en tu coche sin necesidad de tener que pasar por comprar un tesla eléctrico.

Aunque un problema que veo en los autopilotos es la infraestructura, los países deberían de acordar señalizar las carreteras, autopistas y autovías con sensores para garantizar aún más la seguridad de esos autopilotos, vamos, lo que viene a ser el concepto de carreteras inteligentes. Pero a nuestros políticos no les interesa salvar vidas, porque si les interesase eso todo este tema estaría sobre la mesa y el autopiloto sería un plan de futuro para ellos, y debería de serlo si tanto le importa la vida de las personas.

Pero bueno, hablando de IAs y autopilotos, se puede usar una IA para entrenar una simulación con diferentes tipos de conducción, un borracho conduciendo, un conductor novato, un piloto profesional, alguien que conduce bien. Así luego dentro del juego podrías introducir más de una simulación, por lo que a la hora de ver como conduce la gente se sentiría mucho más real, mucho más diferente, como que no todos conducen igual.

Sin embargo, ya hay empresas que están usando IAs para crear carteles publicitarios e incluso anuncios, toda esa tecnología ya está en manos de las personas y está siendo usada por gente a pie de calle, y eso que son los primeros modelos entrenados, cada vez los modelos se mejoran más a cada año que pasa, ya que se siguen entrenando y se sacan mejores versiones.

O por ejemplo CD PROJEKT con las IA que usaron para las animaciones faciales, cada vez más empresas van a usar sus IAs para desarrollar juegos, el siguiente paso a este es usar IAs para que manipulen los juegos, y el último paso será tener juegos procedurales, ya no habrán casi estudios de desarrollo porque los juegos serán a medida, las personas jugarán a lo que ellos quieran, le pedirán a la IA a que quieren jugar más o menos, estilo de juego y el juego se generará de forma procedural en tiempo real, cuando eso suceda es muy probable que los estudios de desarrollo como tal dejen de tener sentido alguno, pues cualquiera podrá tener el juego que quiera a medida al momento, obviamente esos juegos se podrán compartir con otras personas.

Lobeznoviejo1982 escribió:Volviendo al tema en si, puede que la moda reciente de las IA, de visibilidad a la tecnologia y pueda extenderse a los videojuegos, pero llegado ese caso, habria que preguntarse que limites estariamos dispuestos a cruzar.

Esto no es una moda, es una revolución tecnológica que empezó hace poco y que antes era inimaginable, una revolución que va a transformar la sociedad tal y como la conocemos de aquí a diez años, lo mismo que las telecomunicaciones han hecho lo mismo con las sociedades actuales.

¿Es la revolución tecnológica de las telecomunicaciones una moda? ¿Que puedas videollamar a un familiar que vive en otro país es una moda? Una moda igual es un reto de instagram que se vuelve viral o de tik tok, quizás una red social muy activa, pero no creo que lo sea una tecnología en si como lo es la IA en su conjunto o las telecomunicaciones.

Lobeznoviejo1982 escribió:Ya sea que nos lo tomemos con humor como la pelicula Free Guy o que nos pongamos intensos xD y nos vayamos a Westworld, una IA sin restricciones, no solo que fuese muy buena, sino que pudiese aprender, mejorar y evolucionar, podria acercanos terriblemente a Npcs conscientes, y eso, para bien y para mal, treaeria consecuencias impensables.

Una IA muy buena no es compatible con un juego porque frustraría a los jugadores, se puede usar una IA muy buena para probar a los mejores, y seguramente ganaría la IA porque está más que demostrado que todo lo tecnológico es más preciso que un humano, puede que al principio no lo sea pero lo termina siendo al final, por eso en las fábricas donde antes trabajaban 300 personas o más ahora solo trabajan diez, cuando estas personas se han podido sustituir por máquinas mucho más precisas y eficientes se ha hecho el cambio, en un juego donde lo que importa es el entretenimiento de la persona, del humano, no interesa eso, interesa que haya humanidad, margen de error alto en la mayoría de las situaciones, como mucho ensayo error como en los souls, no interesa una IA superinteligente que te venga a cada partida con una estrategia completamente diferente.

Sobre el tema de la consciencia, siempre que sea algo social, tendremos NPC's conscientes, de hecho hay juegos existentes que los tienen hasta cierto punto, RDR2 por ejemplo, donde los NPCs recuerdan si has hecho algo, aunque es todo hardcoded y muy limitado, en pocos años cualquier juego de mundo abierto podrá tener eso sin matarse a programar, cada NPC será un ente independiente que analizará y reaccionará al entorno de forma diferente que los otros, como lo haría un individuo.

De todas formas se puede limitar el entrenamiento y poner barreras, se puede hacer que cuando le pregunten cosas raras a un NPC te envíen a la mierda o incluso te maten.

Por ejemplo, si en RDR2 vas a los NPC's y les hablas de que vienes del futuro, que existen los coches y todas esas historias, es muy probable que termines colgado de una soga en un pueblo, igual eso sería más medieval, me refiero a que te cuelguen por decir esas cosas, colgar si colgaban, o que la gente del pueblo no quiera hablar contigo si te comportas de esa forma, por lo que perderías igual posible interacción para resolver cosas, ya que obviamente no encaja en el contexto histórico y sonaría a loco, el mismo juego te forzaría a adaptarte a el momento histórico, se pueden hacer cosas muy chulas realmente.

Y obviamente habrán glitches conversacionales y cosas muy locas dentro de esas IAs, formas de hacerlas reaccionar con palabras clave, pues como cualquier juego seguro que tendrán sus errores y que no serán perfectas, por lo menos no las primeras.

En este hilo hice un ejemplo real de IA conversacional con RDR2 para darle personalidad a cada NPCs del mundo, para que tengan todos profundidad, cosa que no tienen en el juego, son aburridos y sosos.

Obviamente la IA no es perfecta, es una IA gratuita, seguro que las hay mejores.

El hilo donde se explica:

hilo_red-dead-redemption-2-mods-redm-openiv-4-0-1_2401145_s50#p1752854374En ese hilo puedes ver que yo le doy un contexto a la IA, creo una historia para el personaje que quiero y si yo le pregunto algo al personaje este me responde en función a ese contexto sobre su vida, no es perfecta pero es bastante alucinante el hecho de pensar que podríamos tener ya algo así en un videojuego si las desarrolladoras quisieran meterse manos a la obra cuando yo mismo lo he podido hacer desde mi casa.

Además que yo he creado ese contexto, podría existir una IA que cree contextos, entrenar una IA con todo el lore de RDR2 y darle contextos a cada NPC de forma automática, e incluso modificar esos contextos en función de lo que ocurra en el juego, si disparar en la pierna a un NPC en las líneas del contexto igual se añade "Un hombre con una bandana me disparó en la pierna", lo mismo le pica una serpiente, y entonces va diciendo que le ha picado una serpiente, esa frase activa el buscar ayuda en otros NPCs o medicina.

Una frase puede desencadenar una animación perfectamente, o un estado de ánimo en el NPC, por ejemplo, insultar a un NPC puede poner en estado de alerta al NPC, o incluso volverlo agresivo, igual le puede hacer llorar.

Imagina que es un NPC que tiene un contexto triste, de persona débil y descubres que le ha pasado, te ríes de lo que le ha pasado, pues igual eso le pone triste y a otro le enfada.

Luego está el tema de la memoria, el hecho de que se puedan generar diferentes contextos, podría haber un contexto para la memoria: "Hoy he visto un hombre con una camiseta azul, pelo largo cruzar por la calle tal y pascual". He NPC podría registrar en su contexto varias líneas sobre gente que se cruza ese día en su vida rutinaria, y que esté programado con una aleatoriedad que ese recuerdo se borrará pasados tres días, dependiendo de muchos factores más, porque una animación de hacer algo pues igual genera más memoria que otra, no es lo mismo que ir por la calle andando y ver una persona muy alta, que una persona normal, te fijas más en la muy alta, o una persona peleando con otra en el suelo que una persona que pasa de largo, hay cosas en las que te fijas más, pues eso también se podría tener en consideración, encadenar según que animaciones con valores de permanencia de recuerdos.

Luego puedes acercarte a un NPC y preguntarle ¿Has visto a una persona alta con una camiseta azul? Pues si, ayer vi una persona muy alta por la calle tal.

Se pueden hacer cosas muy chulas.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif) no para mejorar los avances logrados sino para recortar trabajo y costos y pues ya sabemos el resultado.

no para mejorar los avances logrados sino para recortar trabajo y costos y pues ya sabemos el resultado.no para mejorar los avances logrados sino para recortar trabajo y costos y pues ya sabemos el resultado.