Wghos7 escribió:@Xlooser Aquí la comparan con una 1060:

https://www.youtube.com/watch?v=tbHwLZOHwLQ

https://www.youtube.com/watch?v=c4Sghz3puKY

https://www.youtube.com/watch?v=jwH0ixlmpLI

https://www.youtube.com/watch?v=dGa_7Ds13Ls

![reojillo [reojillo]](/images/smilies/nuevos2/ooooops.gif)

Wghos7 escribió:@Xlooser No lo conozco, no sabía que era un hater. ¿Qué pasó?

Solamente en el vídeo del FFXV muestra las opciones que usa

Yui Shojei escribió:@Xlooser y un supuesto PC de 450 dólares en USA a cuántos euros equivaldría en Europa? Porque mi torre son 500€ mas una 1050ti de 150€ y no creo que mueva eso así....

niñodepapa escribió:Esta generación las consolas son PC pero en la siguientes van a ser buenos PC. Yo estoy abandonando el PC por las consolas principalmente por que si la consola no esta comprometida (vamos que no puedas jugar juegos piratas en esa plataforma) para el multiplayer es mucho mejor ya que en PC se esconden bajo el paraguas de los Mods un montón de mierdas que destrozan el juego.

La siguiente generación captara a muchos ya que los precios de los componentes rozan lo absurdo. Si a la consola le sumas algunos periféricos, como teclado y ratón, o servicios como permitir crossplay entre las dos principales plataformas le darán duro al PC.

Ahora bien, al Cesar lo que es del Cesar, jamas será más potente una consola que un PC contemporáneo a ella con lo mejor de lo mejor, esto es así y se dice desde el primer post. No creo que monten lo mejor de lo mejor por que tiene que ser rentable, así que se irán a la gama media del momento que es lo que han estado haciendo hasta ahora. Cuando salio la FAT se fuerón a por la gama media baja y otros a por la media, cuando sacaron la X se fuerón a la gama media, ¿por qué no montaron una Vega? Esta claro que es por que les tiene que salir una maquina rentable y equilibrada, así que por esto no creo que monten algo como la gama alta, montaran algo resultón, que es de sobra para contentarnos al 99% de nosotros.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

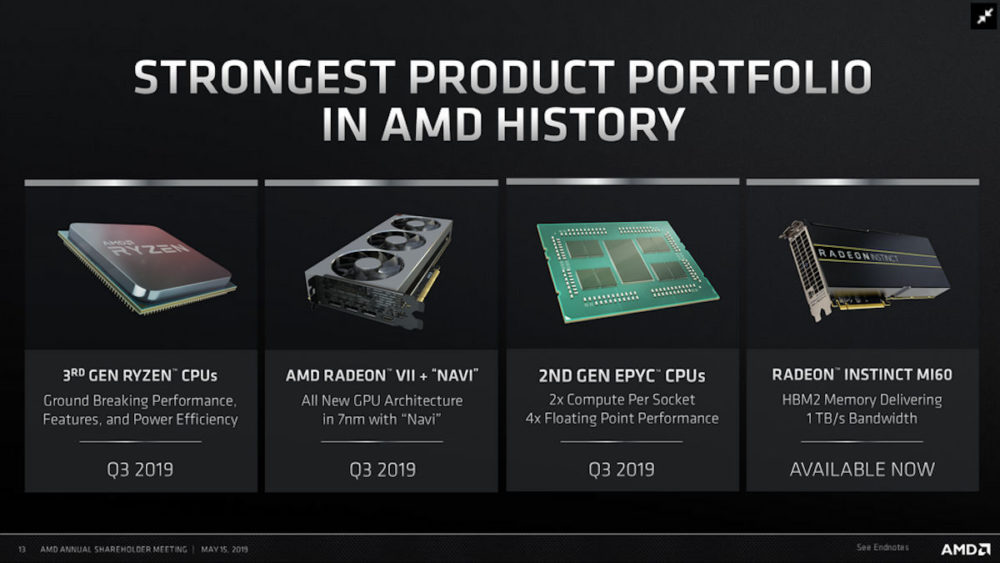

niñodepapa escribió:@eloskuro AMD no va a tener nada mejor que la Radeon VII que es Vega 20 a 7nm y es la gama entusiasta.

Yo en vuestro lugar esperaría algo así como una GTX 1080 OC, Vega 64 o GTX 2060. Por supuesto que si sale en el 2021 pueden montar algo un poco mejor seguro y en el 2022 mucho mejor![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

Es correcto también indicar que cuando salio la FAT la gráfica que montaron llevaba casi dos años en el mercado, ese modelo en concreto no, pero el grueso de la serie 7000 se lanzo, puso a la venta, entre Enero y Marzo del 2012 (incluyendo la 7970) es más la RX 290X y 290 salieron antes que la consola en 2013... yo no apostaría a que la nueva consola va a montar algo diferente de Navi si se lanza en 2020.

eloskuro escribió:

Insistes en lo de Radeon 7 y aún no ha salido lo que tiene Navi. El lunes creo que podrémos hablar con más datos y más certezas. Hasta ahora Radeon 7 sólo es una transición con poco stock,Dudo mucho que sea el buque insignia de AMD hasta finales de 2020

He insisto. No he dicho que Scarlet sea más potente que 2080Ti, que es lo que usas para criticarme y reirte. Solo he dicho que lo normal es que si Xbox One X(de 2017) hace 4k/30 o 1800p/30 en la mayoría de juegos, con el doble de potencia en todos los ambitos(Como se presupone) dificil no será que no haga 4k/60 anaconda en 2020. Como Hace la 2080 Ti. Que lugeo con la 2080 tengo más settings en Ultra? ok. Tambien cuesta ella sola más del doble.

niñodepapa escribió:eloskuro escribió:

Insistes en lo de Radeon 7 y aún no ha salido lo que tiene Navi. El lunes creo que podrémos hablar con más datos y más certezas. Hasta ahora Radeon 7 sólo es una transición con poco stock,Dudo mucho que sea el buque insignia de AMD hasta finales de 2020

He insisto. No he dicho que Scarlet sea más potente que 2080Ti, que es lo que usas para criticarme y reirte. Solo he dicho que lo normal es que si Xbox One X(de 2017) hace 4k/30 o 1800p/30 en la mayoría de juegos, con el doble de potencia en todos los ambitos(Como se presupone) dificil no será que no haga 4k/60 anaconda en 2020. Como Hace la 2080 Ti. Que lugeo con la 2080 tengo más settings en Ultra? ok. Tambien cuesta ella sola más del doble.

Ehh para el carro, yo no me estoy riendo de ti. Si te molestan lo emoticonos lo siento, es mi forma de ser es como una coña, pero no me río de ti. Tampoco te critico, tener otro punto de vista o decirte que algo no es como crees no es criticar como tal en el mal sentido de la palabra, que es como creo la usas, asi que te aclaro que tampoco vengo por cabezas como indicaba otro compi por ahí.

Por lo demas ya te digo que no, que no hace 4K 30fps hace 1080p a X frames, con la CPU que tiene seguro que por debajo de 60 muchas, muchas veces y lo reescala.

eloskuro escribió:niñodepapa escribió:eloskuro escribió:

Insistes en lo de Radeon 7 y aún no ha salido lo que tiene Navi. El lunes creo que podrémos hablar con más datos y más certezas. Hasta ahora Radeon 7 sólo es una transición con poco stock,Dudo mucho que sea el buque insignia de AMD hasta finales de 2020

He insisto. No he dicho que Scarlet sea más potente que 2080Ti, que es lo que usas para criticarme y reirte. Solo he dicho que lo normal es que si Xbox One X(de 2017) hace 4k/30 o 1800p/30 en la mayoría de juegos, con el doble de potencia en todos los ambitos(Como se presupone) dificil no será que no haga 4k/60 anaconda en 2020. Como Hace la 2080 Ti. Que lugeo con la 2080 tengo más settings en Ultra? ok. Tambien cuesta ella sola más del doble.

Ehh para el carro, yo no me estoy riendo de ti. Si te molestan lo emoticonos lo siento, es mi forma de ser es como una coña, pero no me río de ti. Tampoco te critico, tener otro punto de vista o decirte que algo no es como crees no es criticar como tal en el mal sentido de la palabra, que es como creo la usas, asi que te aclaro que tampoco vengo por cabezas como indicaba otro compi por ahí.

Por lo demas ya te digo que no, que no hace 4K 30fps hace 1080p a X frames, con la CPU que tiene seguro que por debajo de 60 muchas, muchas veces y lo reescala.

Quew Xbox One X hace 1080p a X frames?

No seas mentiroso anda.

RDR2 va a 4k nativosy 30 fps

Fh4 va a 4k Nativos y 30 fps

BFV entre 1900p y 4k y 60 fps

AC Oddyssey entre 2944x1656 y 4k (el 60%del tiempo 4k) y 30 fps

Shadow of the tomb Raider 4k nativos y 30 fps

Metro Exodus 4k Nativos y 30 fps

----------------

Juegos de primer nivel. Más todos los first party a 4k, claro....

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

niñodepapa escribió:eloskuro escribió:niñodepapa escribió:

Ehh para el carro, yo no me estoy riendo de ti. Si te molestan lo emoticonos lo siento, es mi forma de ser es como una coña, pero no me río de ti. Tampoco te critico, tener otro punto de vista o decirte que algo no es como crees no es criticar como tal en el mal sentido de la palabra, que es como creo la usas, asi que te aclaro que tampoco vengo por cabezas como indicaba otro compi por ahí.

Por lo demas ya te digo que no, que no hace 4K 30fps hace 1080p a X frames, con la CPU que tiene seguro que por debajo de 60 muchas, muchas veces y lo reescala.

Quew Xbox One X hace 1080p a X frames?

No seas mentiroso anda.

RDR2 va a 4k nativosy 30 fps

Fh4 va a 4k Nativos y 30 fps

BFV entre 1900p y 4k y 60 fps

AC Oddyssey entre 2944x1656 y 4k (el 60%del tiempo 4k) y 30 fps

Shadow of the tomb Raider 4k nativos y 30 fps

Metro Exodus 4k Nativos y 30 fps

----------------

Juegos de primer nivel. Más todos los first party a 4k nativos, claro....

Mentiroso me llamas anda que tiene cojones... primero lloras y despues insultas, y sobre todo cuando afirmas hace 4k 30fps... anda que no tienes ni puta idea, desde cuando una RX 580 ( y ya te doy vidilla) con una CPU de bajo consumo a 2.3Ghz va bien. Ya el mero hecho de reescalar desde la resolución que sea, que muchas de las que dices habrá que ver.. no es 4K y desde luego nada mesurable y comparable puesto que ni los settings son claros.... 4k dices![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

eloskuro escribió:

Las que he dicho que son 4k son 4k nativos según Digital Foundry.

LAs que he dicho que reescalan, reescalan dinamicamente a esos niveles que he puesto, segun Digital Foundry.

Solo teines que leer sus artículos. Si tienes información de cualquier otra web del nivel que maneje otros datos sobre esos juegos me dices y retiraré lo de mentiroso. Mientras no sea así y te reafirmes en que esos juegos no van a la resolución que he dicho, me pareces un mentiroso. No es insultar. Es claramente lo que haces si obvias la realidad objetiva(datos de DF)y tratas de negarla.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif) si hombre sí, lo que tu digas, ¿como lo miden y donde lo puedo ver?, ¿lo puedo emular yo igual que ellos en casa? Con un PC sí puedo, ¿es algo oficial que se especifique en los juegos? Anda que sí, que a ver cuantos analistas afirman eso.

si hombre sí, lo que tu digas, ¿como lo miden y donde lo puedo ver?, ¿lo puedo emular yo igual que ellos en casa? Con un PC sí puedo, ¿es algo oficial que se especifique en los juegos? Anda que sí, que a ver cuantos analistas afirman eso.![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

niñodepapa escribió:eloskuro escribió:

Las que he dicho que son 4k son 4k nativos según Digital Foundry.

LAs que he dicho que reescalan, reescalan dinamicamente a esos niveles que he puesto, segun Digital Foundry.

Solo teines que leer sus artículos. Si tienes información de cualquier otra web del nivel que maneje otros datos sobre esos juegos me dices y retiraré lo de mentiroso. Mientras no sea así y te reafirmes en que esos juegos no van a la resolución que he dicho, me pareces un mentiroso. No es insultar. Es claramente lo que haces si obvias la realidad objetiva(datos de DF)y tratas de negarla.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

si hombre sí, lo que tu digas, ¿como lo miden y donde lo puedo ver?, ¿lo puedo emular yo igual que ellos en casa? Con un PC sí puedo, ¿es algo oficial que se especifique en los juegos? Anda que sí, que a ver cuantos analistas afirman eso.

La mejor es esa de " a 4k el 60% del tiempo" jajajajaja

Como ya sabemos como acaba te dejo, que cuando saquen la nueva ya volvere a estos temas con más risas![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

niñodepapa escribió:Tranquilos que voy con la lección aprendida

Para medir rendimiento entre GPU se usan los Tflops al margen de la arquitectura, etc.. y para ver la resolución interna hay que hacer caso a Digital Foundry que hace lo imposible y de forma mágica, por que FCAT que es la herramienta que se usan para medir los fps tras una captura de vídeo no sirve para eso, pero ellos tras un exhaustivo análisis del vídeo mirando frame a frame ven si en alguno decae la resolución y de ahi lo deducen jajajajajajaja a ver que cojo aire jajajajajajajajajajaja

Grandes los gurus del foro jajajajajajajaja.

Lo que se necesita para determinar las resoluciones nativas son, preferentemente bordes geométricos largos y afilados, preferentemente de alto contraste en la naturaleza para resaltar los bordes escalonados '' de la línea. A partir de ahí, a través de lo que es generalmente una muestra de 30 píxeles, se cuenta la cantidad de escaleras pasos generados por la consola. Suponiendo que estamos hablando de resolución vertical, 20 pasos de una muestra de 30 nos da este cálculo - (20/30) x 1080. El resultado final: 720p. Si ves 25 pasos, eso es (25/30) x 1080 ... 900p.

PowerMore escribió:IridiumArkangel escribió:NosferatuX escribió:

La competidora de la proxima generacion al menos con RT no es la serie 2000, Microsoft y Sony no estan haciendo consolas 4K de estandar para que luego se arrastren a con RT y estan vigilando ese tema bien de cerca.

Y... aquí creo que estará el quid de la cuestión. Tengo la impresión de que con el tema del RT habrá "jugada del chepas". Hay calidades y calidades de RT (no es lo mismo 1 Gigarayos/seg que 10 Gigarayos/seg), y tampoco me extrañaría que se sacasen de la manga una "solución RT propia" con un RT light para limitar justo eso que mencionas; que afecte en demasía a la estabilidad de lo ejecutado.

Cuando vi esto, me pareció una pista de lo que habrá en las next-gen:Gran Turismo Dev Polyphony Digital Are Working on Their Own Real-Time Ray Tracing Tech

https://wccftech.com/gran-turismo-polyphony-raytracing/

Lo dicho, ya iremos viendo, pero equipararlas o incluso decir que superarán el rendimiento que logra una 2080Ti me parece algo muy osado; sin más.

Me imagino que tampoco es lo mismo tener RT por hardware con chips dedicados donde destinas una potencia de casi 2 Tflops independientes de la potencia del sistema a esta tecnología, a utilizar RT por software donde quieras o no te comes recursos potenciales del hardware. La interesante será ver si el RT por software merma el rendimiento de la consola y en que medida cuando lo compares con un hardware con chips dedicados para RT.

Szasz escribió:@IridiumArkangel

Tienes razón y no, y me explico. Voy a coger lo q has puesto para referirte a "rendimiento".

"Rendimiento: En informática, medida o cuantificación de la velocidad/resultado con que se realiza una tarea o proceso. En una computadora, su rendimiento no depende sólo del microprocesador como suele pensarse, sino de la suma de sus componentes como la memoria, el bus, gpu, diversos dispositivos, etc. y sus softwares"

La GPU es un elemento más del tándem, del rendimiento final. Si lo q tú estás hablando es de benchmarks sintéticos dónde se haga trabajar a la GPU de una forma aislada al resto de componentes pues sí, podrías tener razón. Pero si de lo q hablamos es de correr juegos hay q tener en cuenta otras variables. ¿Como es posible q un Jaguar a velocidades ridículas comparadas con los PC de sobremesa sea capaz de mover un juego como Battlefield con 64 personajes a 60 fps. Alguien ha probado a jugar con un jaguar (debería de ser de 4 núcleos desgraciadamente) a un Battelfield? Son elementos q se optimizan tanto a nivel hardware como es el caso de Xbox, como a nivel software. Consiguiendo rendimientos superiores a los de sus homónimos en PC. Lógicamente si tu usas un benchmark sintético y lo lanzas sobre esos jaguar y luego sobre otra CPU que te de el mismo rendimiento en el Battelfield q hemos hablado antes, veremos q la CPU de PC es más potente, pero sin embargo en el juego comentado no lo demuestra. Este es un ejemplo básico de optimización de las consolas, y es lo q la gente se refiere a rendimiento. Rendimiento JUGANDO, q es diferente a rendimiento teórico.

Xlooser escribió:IridiumArkangel escribió:Que en Pc utilicen las Gpu sin miramientos de manera bruta sin aprovecharla en profundidad, no exime que el RENDIMIENTO que te ofrece una GTX2080Ti sea muy bruto por los mismos números que gasta.

Venga tío, ¿debo tener en cuenta el rendimiento POSIBLE que no se materializa en el mundo real? Ya sé que un juego programado específicamente para una cierta arquitectura dará mejores resultados, aunque menos de lo que esperas, pues los motores hoy en día son muy escalables.Scarlet puede llegar a ser tan EFECTIVA como una GTX2080Ti

Exacto, pero yo digo que será mejor, mejor de verdad. Los números han de ser suficientes para el resultado que quieres lograr, el resto sólo incrementará el coste.

Si 500 GB/s son suficientes para alimentar el 100% del tiempo a tus 3840 stram processors ¿para qué más? No vas a ganar rendimiento.

Si el planificador de la GPU tiene un límite de "x" wavefronts con "y" elementos para dar curro a "z" stream processors" ¿para qué quieres "z"+500?

Si 64 ROPs son suficientes para escribir un búfer 4K con 4 bytes por píxel ¿por qué vas a montar 128?

Así con todo. Eso sí, los números en el papel van a abrir todas las bocas de los lectores.Con respecto a la manida mágica optimización de las consolas, otro apunte (y soy usuario de consolas, no tengo Pc gamer, pero las cosas como son). Optimización es cuasi sinónimo de reducción de calidad

Optimización es hacer más con menos, no reducción de calidad. A lo mejor los conceptos deberíamos repasarlos (todos, no sólo tú) y hacer menos caso a la prensa "especializada" que coge una linde y sigue y sigue.mediante el uso de múltiples técnicas ideadas por los desarrolladores del laborioso arte de engañar al ojo/cerebro humano. Esto es como querer equiparar 4k nativos con 4k chekerboard, ambos dan una salida 4k...

No es una técnica para engañar al cerebro, sino para inferir 4K reales, otra cosa es que lo consiga. ¿Si con una técnica novedosa se escala de 1080p a 4K con IDÉNTICO resultado que renderizar a 4K, estás siendo engañado? Yo creo que no, estás viendo 4K, el camino para conseguirlo es indiferente al resultado.La optimización en las consolas siempre ha sido una buena baza cuando los hardwares de estas eran soluciones específicas diferentes de la x86 de los Pc que los desarrolladores explotaban focalizándose en sus fuertes hasta el extremo. Hoy en día, las consolas "son Pcs x86" levemente customizados por la marca Z que toque por lo que muchas de las optimizaciones hechas para las Gpu de AMD de estas son aprovechables para las Gpu de AMD en Pc, disminuyendo ese gap de optimización real entre hardware parejos. Nvidia va por libre, pero vamos que ya se encargan ellos de hacer lo propio.

¿Por qué con arquitectura x86 la optimización ya no funciona?

Bueno, a mi no me parece tan leve reducir miles o cientos de miles de instrucciones a 11. Ni reducir las latencias. Ni disminuir el tiempo de las referecias a memoria. Ni comprimir la información de color un 20% sin pérdida de calidad, ni hacer que un ROP escriba 8 bytes por ciclo en vez de 4.....Todas estas optimizaciones ("reducciones de calidad") son por hardware, si en un PC no existen, pues..........no será tan eficiente. Lo que está claro es que si una consola es un PC tal cual, el rendimiento será el mismo.Las bondades de un hardware único, cerrado y capado están ahí, al igual que las de un hardware abierto y flexible que incluso permite llegar a forzar sus límites con overclock o mejorar los juegos con mods. Cada uno tiene sus pros y contras, y cada vez aunque mantengan sus clásicas características, son hardwares más parecidos al contrario que antaño.

Estoy de acuerdo, yo también lo he dicho varias veces.Luego hay un parámetro que no se está contemplando, los estudios de desarrollo. Si tienes un estudio de desarrollo que te exprime hasta la extenuación tu hardware, parece increible lo que logran. Luego en cambio otro estudio con el mismo hardware, te hace una medianía técnica. Vease Naughty Dog o Turn 10 como ejemplos prácticos.

También estoy de acuerdo, por eso yo hablo de rendimiento. Al equiparar una consola con un PC de hardware superior ese es el primer parámetro con el que cuento. Las técnicas más novedosas no se normalizarán hasta que las usen en consolas. El RT no será lo cotidiano hasta PS5 y Scarlett. La super-resolución tampoco. El Checkerboard....lo que se te ocurra. Técnicas así se inventan por tener un límite superior y la necesidad de hacer más con menos.Dale a uno de esos estudios una GTX 2080Ti para desarrollar específicamente, e íbamos a ver realmente de lo que sería capaz un hardware como ese...

Lo sé, sería espectacular. Pero bueno, yo pienso que en Scarlett se verían mejores cosas. Me tragaré mis palabras si resulta que no es así, no tengo ningún problema.

La GPU de Xbox One se basa en la HD7790, ¿crees que la mejor tarjeta de la generación anterior de AMD (Radeon HD6970) es superior a una Xbox One en cuanto a rendimiento? No es compatible con DX12, con lo que ya es menos avanzada.

Por cierto, cuando una RTX usa RT, los shaders se bloquean, no hacen nada. Eso es una cagada del diseño desde cualquier ángulo que mires. Me extrañaría que el RT fuera igual en Scarlett. Sólo arreglando eso, la mejora es sustancial.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![facepalm [facepalm]](/images/smilies/facepalm.gif)

y para el que no lo pille.

Xbox X tiene juegos 4k nativos le guste o no a la gente

Y el pc SIEMPRE será mejor que una consola ( con su debida inversión claro) le guste o no a la gente

Szasz escribió:@IridiumArkangel

Pero ésto q pones aquí:

"Con respecto al resto, claro que estoy de acuerdo en que en consolas se optimizan y puede que sea más efectivo que el redimiento directo que te ofrece su homónimo en Pc, pero ello suele conllevar también una reducción de la calidad global JUGANDO como le comenté a Xlooser... (menos/peores efectos efectos, texturas menos detalladas, LoDs, sombras, etc etc)"

No lo termino de entender. Yo me refiero a q por ejemplo en One X tu tienes una GPU q por número de Stream processors equivale a una Rx 580, pero los retoques en el ancho de banda, reducción de cuellos de botella en áreas q Microsoft había detectado, etc....hace q el rendimiento final esté por encima de está. Tú te refieres a compararlo con el PC como si siempre debiera compararse con el tope de gama y es lógico q en ese escenario la consola siempre pierda. Otro tipo de comparativa sería la q he dicho, buscar algo equivalente en el mundo del PC, y ya si tienes en cuenta precio y consumo eléctrico, verás q la consola siempre tiene un mejor aprovechamiento de los recursos, bien por via software (desarrollo mejor adaptado a una arquitectura cerrada) o vía hardware (pequeños retoques q permiten mejores consumos y rendimientos superiores a la hora de ejecutar juegos).

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Xlooser escribió:Wghos7 escribió:@Xlooser No lo conozco, no sabía que era un hater. ¿Qué pasó?

Solamente en el vídeo del FFXV muestra las opciones que usa

Que se compare la X con un PC despierta muchas ampollas, y Youtubers como en este caso, pues.........se nota su parcialidad. Quien esté tan seguro de la superioridad de una GTX1070 no se molesta porque otros afirmen que están al mismo nivel en rendimiento.

Hay que matizar, algo que ya he hecho varias veces, pero entiendo que tú no lo hayas leido. Una GTX1070 es indudablemente superior, no hay discusión posible, es mejor hardware. Lo que yo digo, y veo a diario, es que la mejor versión de un juego en la X, es decir, con optimización a tope está al mismo nivel que en un i7+GTX1070 con optimización típica. Si en PC la optimización es buena, tendrás mejores resultados en PC siempre, aunque no tanto como marca la diferencia de precio, tamaño, consumo, etc, etc....

Por supuesto, un PC es tan flexible que lo puedes poner en 1440p ó 1080p si quieres y ganar en el resto de apartados. El renidmiento por watio y rendimiento por coste pertenece a la plataforma cerrada, esto tampoco admite discusión.Yui Shojei escribió:@Xlooser y un supuesto PC de 450 dólares en USA a cuántos euros equivaldría en Europa? Porque mi torre son 500€ mas una 1050ti de 150€ y no creo que mueva eso así....

Como esté el cambio + 7% de impuestos, 431,43 euros. Lo que está claro que hay mucha gente que miente como bellacos diciendo que con una GTX1060 de 3 GB juega mejor que con una X a cualquier juego o que consigue nosecuantos fps a 4K con una GTX1070 y le ha costado 80 euros............claro que sí, me lo creo. El mundo real es diferente y resulta que no hay tanta gente con GTX1080, que parece que se regalan con los cereales jajajaja.

![Adorando [tadoramo]](/images/smilies/adora.gif) pero como es una consola no cuenta, jajaja

pero como es una consola no cuenta, jajaja Grinch escribió:O sea que los juegos a 4k nativos no van a 4k nativos por que .... pue porque si.

![adios [bye]](/images/smilies/nuevos2/adio.gif)

![facepalm [facepalm]](/images/smilies/facepalm.gif)

Wghos7 escribió:@Xlooser Para recapitular: La GPU de la X se acerca más a una 1070 que a una 1060 pero debido a la CPU eso no se plasma al 100%. Como ya te comenté la 1070 es más para 1440p, si la emparejas con un i7, va a rendir más que la X en su conjunto, lo mismo que la 1060 a 1080p. Todo esto hablando de 60fps o más y de juegos que dependan más de la CPU.

Creo que ya nos vamos entendiendopero no consigo entender porque usas un i7 para comparar.

Edit: Ok ya lo entendí, he visto vídeos a 4k con un Ryzen 3 y hace cuello de botella hasta a una 1060 aunque con un i5/Ryzen 5 sobra.

niñodepapa escribió:Grinch escribió:O sea que los juegos a 4k nativos no van a 4k nativos por que .... pue porque si.

a 4k iran algunos poco demandantes, pero algo como Red Dead Redemptión ni de coña o Battlefield 5. Es que es gracioson todo esto por que simplemente no hay manera de saber a que resolución interna se renderiza sin tener acceso al codigo, motor, o como lo quieras llamar para que nos entendamos.

Tiburon Man escribió:A mí me la suda sobremanera la diferencia con un pc, pero lo que no es de recibo es que se vea mejor y más nítido el rage 2 en una gtx 960 de 100 pavos que una one x, no se la está aprovechando.

Me está pasando como en mi infancia, que tuve un msx que dejaba por los suelos al spectrum y al final el 90% del catálogo eran ports del mentado

IridiumArkangel escribió:Xlooser escribió:IridiumArkangel escribió:Que en Pc utilicen las Gpu sin miramientos de manera bruta sin aprovecharla en profundidad, no exime que el RENDIMIENTO que te ofrece una GTX2080Ti sea muy bruto por los mismos números que gasta.

Venga tío, ¿debo tener en cuenta el rendimiento POSIBLE que no se materializa en el mundo real? Ya sé que un juego programado específicamente para una cierta arquitectura dará mejores resultados, aunque menos de lo que esperas, pues los motores hoy en día son muy escalables.Scarlet puede llegar a ser tan EFECTIVA como una GTX2080Ti

Exacto, pero yo digo que será mejor, mejor de verdad. Los números han de ser suficientes para el resultado que quieres lograr, el resto sólo incrementará el coste.

Si 500 GB/s son suficientes para alimentar el 100% del tiempo a tus 3840 stram processors ¿para qué más? No vas a ganar rendimiento.

Si el planificador de la GPU tiene un límite de "x" wavefronts con "y" elementos para dar curro a "z" stream processors" ¿para qué quieres "z"+500?

Si 64 ROPs son suficientes para escribir un búfer 4K con 4 bytes por píxel ¿por qué vas a montar 128?

Así con todo. Eso sí, los números en el papel van a abrir todas las bocas de los lectores.Con respecto a la manida mágica optimización de las consolas, otro apunte (y soy usuario de consolas, no tengo Pc gamer, pero las cosas como son). Optimización es cuasi sinónimo de reducción de calidad

Optimización es hacer más con menos, no reducción de calidad. A lo mejor los conceptos deberíamos repasarlos (todos, no sólo tú) y hacer menos caso a la prensa "especializada" que coge una linde y sigue y sigue.mediante el uso de múltiples técnicas ideadas por los desarrolladores del laborioso arte de engañar al ojo/cerebro humano. Esto es como querer equiparar 4k nativos con 4k chekerboard, ambos dan una salida 4k...

No es una técnica para engañar al cerebro, sino para inferir 4K reales, otra cosa es que lo consiga. ¿Si con una técnica novedosa se escala de 1080p a 4K con IDÉNTICO resultado que renderizar a 4K, estás siendo engañado? Yo creo que no, estás viendo 4K, el camino para conseguirlo es indiferente al resultado.La optimización en las consolas siempre ha sido una buena baza cuando los hardwares de estas eran soluciones específicas diferentes de la x86 de los Pc que los desarrolladores explotaban focalizándose en sus fuertes hasta el extremo. Hoy en día, las consolas "son Pcs x86" levemente customizados por la marca Z que toque por lo que muchas de las optimizaciones hechas para las Gpu de AMD de estas son aprovechables para las Gpu de AMD en Pc, disminuyendo ese gap de optimización real entre hardware parejos. Nvidia va por libre, pero vamos que ya se encargan ellos de hacer lo propio.

¿Por qué con arquitectura x86 la optimización ya no funciona?

Bueno, a mi no me parece tan leve reducir miles o cientos de miles de instrucciones a 11. Ni reducir las latencias. Ni disminuir el tiempo de las referecias a memoria. Ni comprimir la información de color un 20% sin pérdida de calidad, ni hacer que un ROP escriba 8 bytes por ciclo en vez de 4.....Todas estas optimizaciones ("reducciones de calidad") son por hardware, si en un PC no existen, pues..........no será tan eficiente. Lo que está claro es que si una consola es un PC tal cual, el rendimiento será el mismo.Las bondades de un hardware único, cerrado y capado están ahí, al igual que las de un hardware abierto y flexible que incluso permite llegar a forzar sus límites con overclock o mejorar los juegos con mods. Cada uno tiene sus pros y contras, y cada vez aunque mantengan sus clásicas características, son hardwares más parecidos al contrario que antaño.

Estoy de acuerdo, yo también lo he dicho varias veces.Luego hay un parámetro que no se está contemplando, los estudios de desarrollo. Si tienes un estudio de desarrollo que te exprime hasta la extenuación tu hardware, parece increible lo que logran. Luego en cambio otro estudio con el mismo hardware, te hace una medianía técnica. Vease Naughty Dog o Turn 10 como ejemplos prácticos.

También estoy de acuerdo, por eso yo hablo de rendimiento. Al equiparar una consola con un PC de hardware superior ese es el primer parámetro con el que cuento. Las técnicas más novedosas no se normalizarán hasta que las usen en consolas. El RT no será lo cotidiano hasta PS5 y Scarlett. La super-resolución tampoco. El Checkerboard....lo que se te ocurra. Técnicas así se inventan por tener un límite superior y la necesidad de hacer más con menos.Dale a uno de esos estudios una GTX 2080Ti para desarrollar específicamente, e íbamos a ver realmente de lo que sería capaz un hardware como ese...

Lo sé, sería espectacular. Pero bueno, yo pienso que en Scarlett se verían mejores cosas. Me tragaré mis palabras si resulta que no es así, no tengo ningún problema.

La GPU de Xbox One se basa en la HD7790, ¿crees que la mejor tarjeta de la generación anterior de AMD (Radeon HD6970) es superior a una Xbox One en cuanto a rendimiento? No es compatible con DX12, con lo que ya es menos avanzada.

Por cierto, cuando una RTX usa RT, los shaders se bloquean, no hacen nada. Eso es una cagada del diseño desde cualquier ángulo que mires. Me extrañaría que el RT fuera igual en Scarlett. Sólo arreglando eso, la mejora es sustancial.

Me gustaría contestarte punto por punto en detalle, pero llevo una semana muy ajetreada y apenas tengo tiempo de esplaye.

Claro que hay que ver la capacidad máxima de una 2080Ti de benchmark (es como se comparan las Gpu de Pc punto por punto), aunque en la realidad los desarrolladores no le saquen todo su jugo. Por tu regla de 3, yo podría decir que mi Civic iguala a un Ferrari para conducir por autopista a 120 Km/h que es como vamos todos en la realidad; y no se me ocurre decir tal cosa...![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Optimización puede llegar a ser "hacer más con menos", pero suele conllevar en muchos de los casos bajada de calidad no jodamos, aunque un ojo no entrenado no se entere. El Hellblade por ejemplo, que lo tenemos a disposición desde su versión Pc hasta la de una Switch. En todas es el mismo juego, pero su calidad global varía por tener que rebajar calidades optimizándolo en base al hardware disponible.

Por cierto, cuando hablo de optimización siempre me refiero a optimización por técnicas de software (checkboard, aplicación de efectos, reflejos, calidad de assets, LoD, etc) con diferente coste computacional y con ello también calidad final, no a las de hardware. Estas últimas si que pueden marcar diferencias notables, como por ejemplo lo ha sido en la Cpu de la XOne X que todo el mundo sigue diciendo que es "la misma mierda de Jaguar que Ps4/XOne"; y está más que demostrado que no es así. Eso sí, estas modificaciones también pueden llegar a ser un lastre si el desarrollador no las tiene en cuenta/aprovecha, y para muestra la ESRAM de la XOne (mira, otro caso con múltiples ejemplos a principio de gen donde no se le sacaba todo el jugo real al hardware, y no por ello decimos que la X360 estaba a la altura de XOne porque al no aprovechar la ESRAM sacaban juegos a 720p).

Y sí, la 2080Ti tiene errores de diseño que seguro que los siguientes modelos mejorarán, pero sigue siendo una mala burra pese a ellos.

Para acabar, mira que he estado casi siempre de acuerdo en todo lo que dices porque además lo razonas muy acertadamente, pero en este caso con la 2080Ti siento discrepar. Ojalá tengas razón y las next-gen equiparen las capacidades de esa bestia parda, yo no lo veo...

Saludos

THANOS-TITAN-Z escribió:Así de potente luce Gears 5 en PC a 4K y con todas las opciones gráficas en Ultra

Tres vídeos corriendo sobre una tarjeta grafica GeForce RTX2080Ti muestran las enormes capacidades visuales del nuevo Gears of War.

https://www.3djuegos.com/noticias-ver/1 ... todas-las/

Lammothh escribió:@kikomanco Aquí podéis dar por saco los PCros!!!!

Este artículo es interesante y curioso.

Los de DF han simulado equipos para imitar las futuras consolas y fijaos las GPU que asignan a cada una.

Simulando la hipotética Xbox Scarlett

CPU Ryzen 7 3700X

GPU Radeon RX 5700 XT

Simulando la hipotética PlayStation 5

CPU Ryzen 7 3700X

GPU AMD Radeon RX 5700

https://generacionxbox.com/potencia-xbo ... y-ps5/amp/

Han llegado a la conslusion de que Scarlett será el doble de X y PS5 el triple de Pro. 12Tf VS 12,6Tf pero Scarlett con GPU más avanzada, (XT)